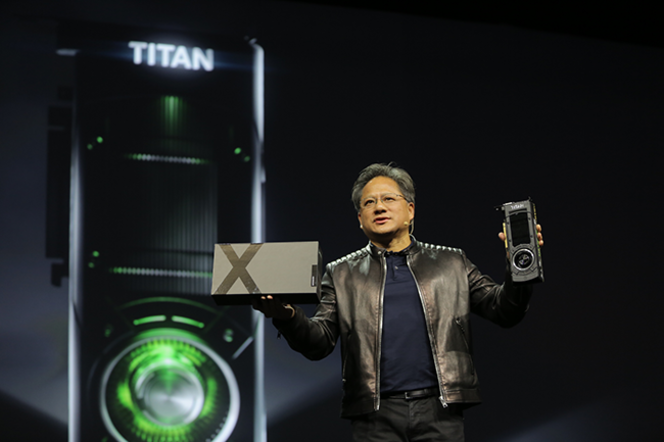

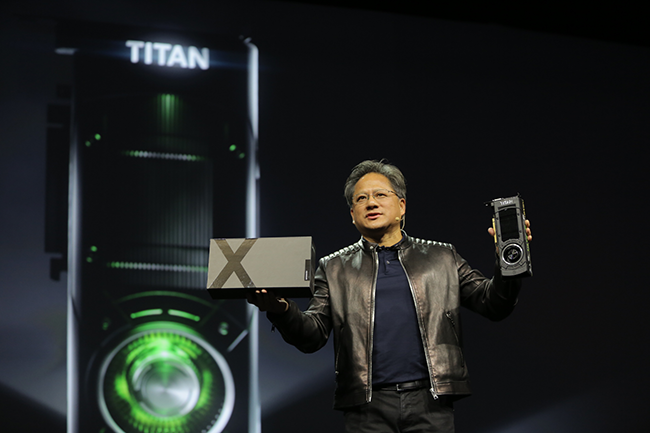

Après une brève apparition à la Game Developer Conference entre les mains du patron et co-fondateur de Nvidia, la carte graphique GeForce GTX Titan X a eu droit à une officialisation en bonne et due forme, toujours en compagnie de Jen-Hsun Huang.

La présentation par Nvidia ( cliquer pour agrandir )

En prenant appui sur la micro-architecture Maxwell 28 nanomètres, cette nouvelle vitrine technologique pour la firme au caméléon promet des performances de haut vol, tout en assurant une maitrise énergétique. Grâce à son cœur GM200 à 1 GHz ( ou 1,075 GHz en mode Turbo ) composé de 3 072 processeurs de traitement et sa mémoire vidéo GDDR5 de 12 Go interfacée en 384-bit, elle permet en effet jusqu’à 7,1 TFlop/s en simple précision. Et cela avec un TDP de 250 Watts. Autrement dit, plus de performances que la GeForce GTX Titan Black Edition ( 5,1 TFop/s ), mais avec la même consommation. De quoi assurer du jeu vidéo en ultra haute définition 4K avec une fluidité continue.

Comme précisé par Nvidia, tous les acheteurs seront logés à la même enseigne, puisqu’il n’y aura pas de modèle customisé chez les partenaires. Ces derniers devront en effet se limiter au modèle de référence, qui sera d’ailleurs vendu 999 dollars ( environ 1 000 euros chez nous donc ) et qui a déjà été annoncé chez Zotac et Gigabyte.

Les GeForce GTX Titan X de Gigabyte et Zotac ( cliquer pour agrandir )