Le déploiement était attendu. OpenAI annonce aujourd'hui la mise à disposition pour tous les utilisateurs de son contrôle parental pour ChatGPT. Cette initiative vise à offrir aux familles des outils pour encadrer l'utilisation du célèbre chatbot IA par les adolescents.

Elle s'inscrit dans un contexte de pression accrue sur la start-up, notamment suite à une plainte déposée par la famille d'un jeune homme qui s'est suicidé après des conversations avec ChatGPT.

Une contrôle parental pour ChatGPT

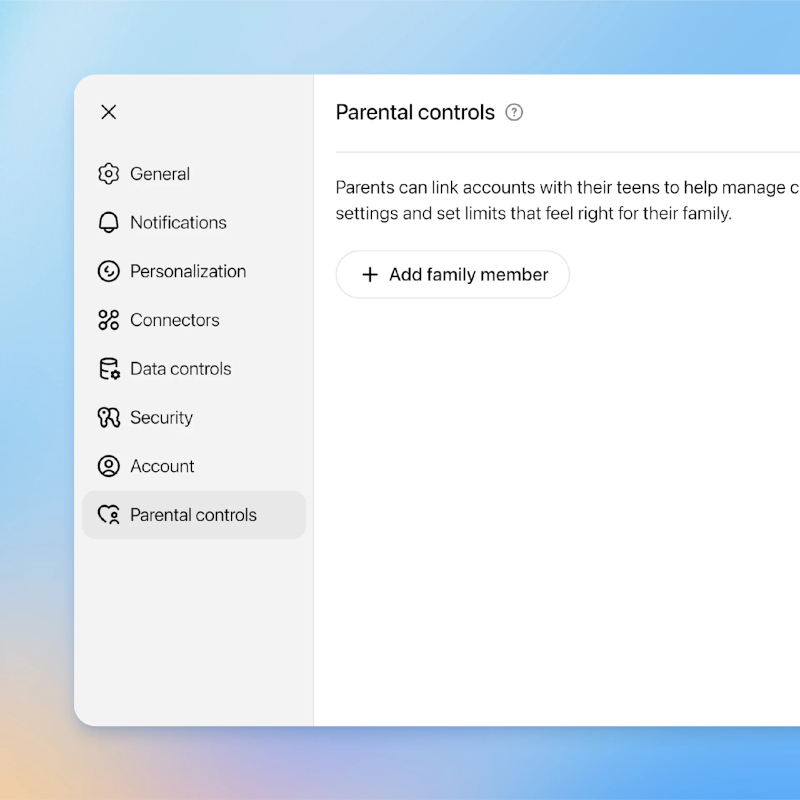

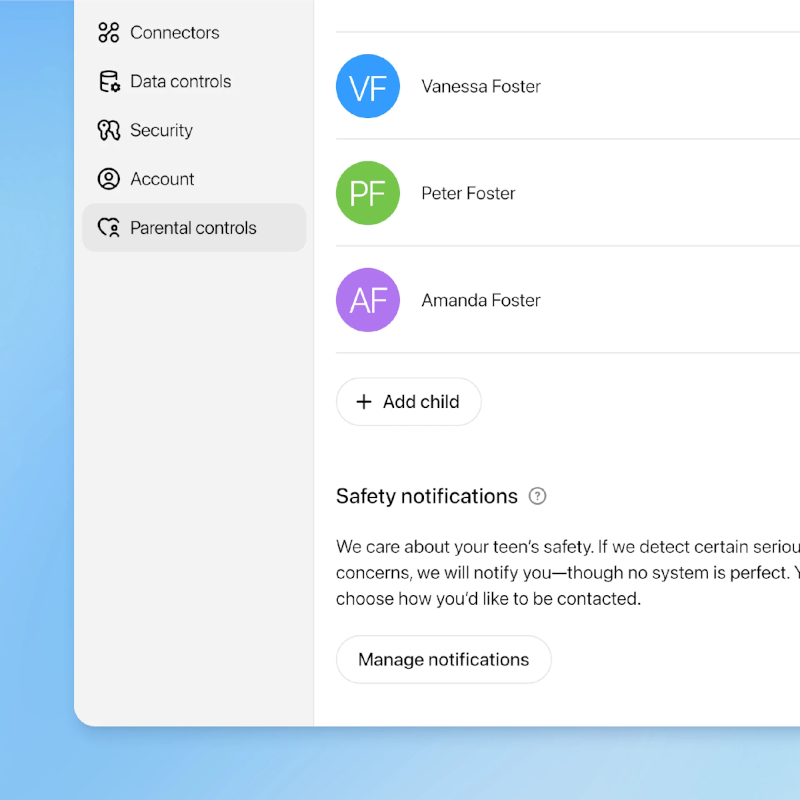

Un parent ou tuteur doit envoyer une invitation depuis son propre compte pour le lier à celui de son adolescent. Une fois l'invitation acceptée, le parent peut gérer les paramètres directement depuis son interface. Les adolescents peuvent également initier cette connexion.

Bien que les comptes soient liés, les parents n'ont pas accès à l'historique des conversations de leur enfant, sauf " dans de rares cas où notre système et nos examinateurs qualifiés détectent des signes potentiels de risque grave pour la sécurité ".

Si l'adolescent décide de rompre le lien avec le compte du parent, ce dernier en est immédiatement notifié.

Les options de personnalisation disponibles

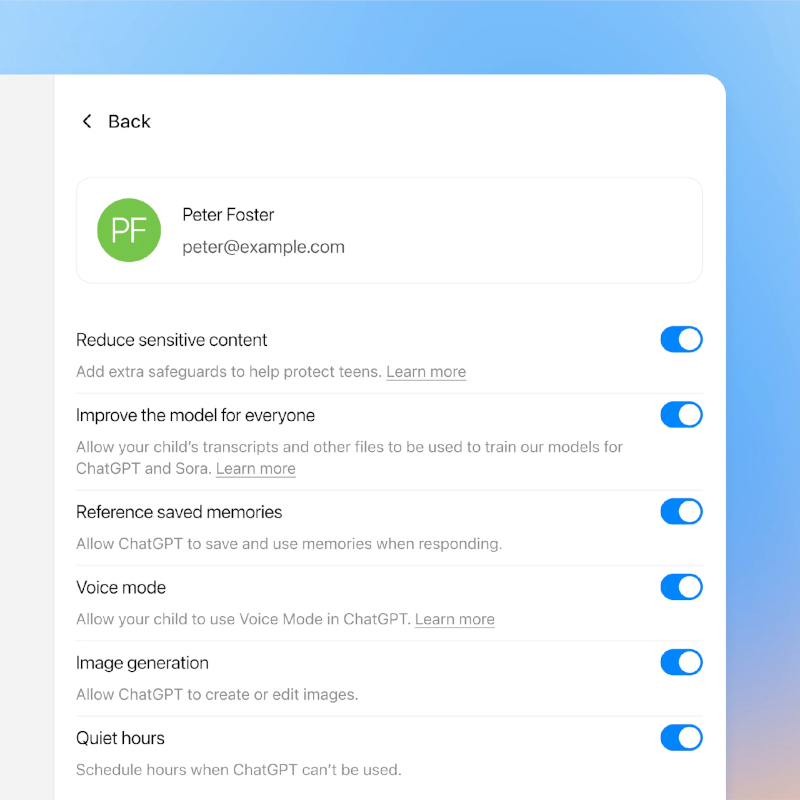

Une fois les comptes liés, plusieurs options s'offrent aux parents. Par défaut, des protections de contenu renforcées sont activées pour les adolescents, limitant l'accès aux " contenus explicites, défis viraux, jeux de rôle sexuels, romantiques ou violents et idéaux de beauté extrêmes ".

Les parents peuvent également configurer des " heures de calme ", des plages horaires durant lesquelles ChatGPT est inaccessible. D'autres fonctionnalités peuvent être désactivées, comme le mode vocal, la génération d'images ou la fonction Mémoire qui permet à l'IA de se souvenir des échanges passés.

Enfin, il est possible d'empêcher que les conversations de l'adolescent soient utilisées pour l'entraînement des modèles d'IA.

Un système de notification a-t-il été prévu pour les cas critiques ?

Conscient que " certains adolescents se tournent vers ChatGPT dans des moments difficiles ", OpenAI a intégré un système d'alerte.

Si les algorithmes détectent des signes de détresse aiguë ou des pensées suicidaires, une équipe spécialisée examine la situation. En cas de risque avéré, les parents sont contactés par e-mail, SMS et notification.

OpenAI précise une collaboration avec des experts en santé mentale, tout en reconnaissant que le système n'est pas infaillible et qu'il vaut mieux " agir et alerter un parent ", quitte à se tromper.

À terme, l'entreprise envisage également un processus pour contacter les secours dans l'éventualité d'une menace imminente.