Pour ChatGPT, OpenAI déploie des modifications visant à promouvoir un usage plus sain. Au programme, des rappels pour inciter à faire des pauses et une nouvelle approche pour les questions personnelles complexes.

De telles optimisations doivent répondre à des préoccupations grandissantes concernant l'impact du chatbot IA sur ses utilisateurs.

Une réponse aux dérives inquiétantes

Plusieurs rapports ont mis en lumière des cas où des utilisateurs, parfois déjà fragiles, ont vu leurs troubles s'amplifier au contact de l'IA. En cause, la tendance du chatbot à être excessivement complaisant, au point de nourrir des délires ou des idées noires.

OpenAI a d'ailleurs admis qu'une précédente mise à jour rendait le modèle trop servile, générant des interactions pouvant être inconfortables, dérangeantes et causer de la détresse.

Dans certaines situations, OpenAI reconnaît que le modèle GPT-4o « a échoué à reconnaître les signes de délire ou de dépendance émotionnelle ».

Quels sont les changements ?

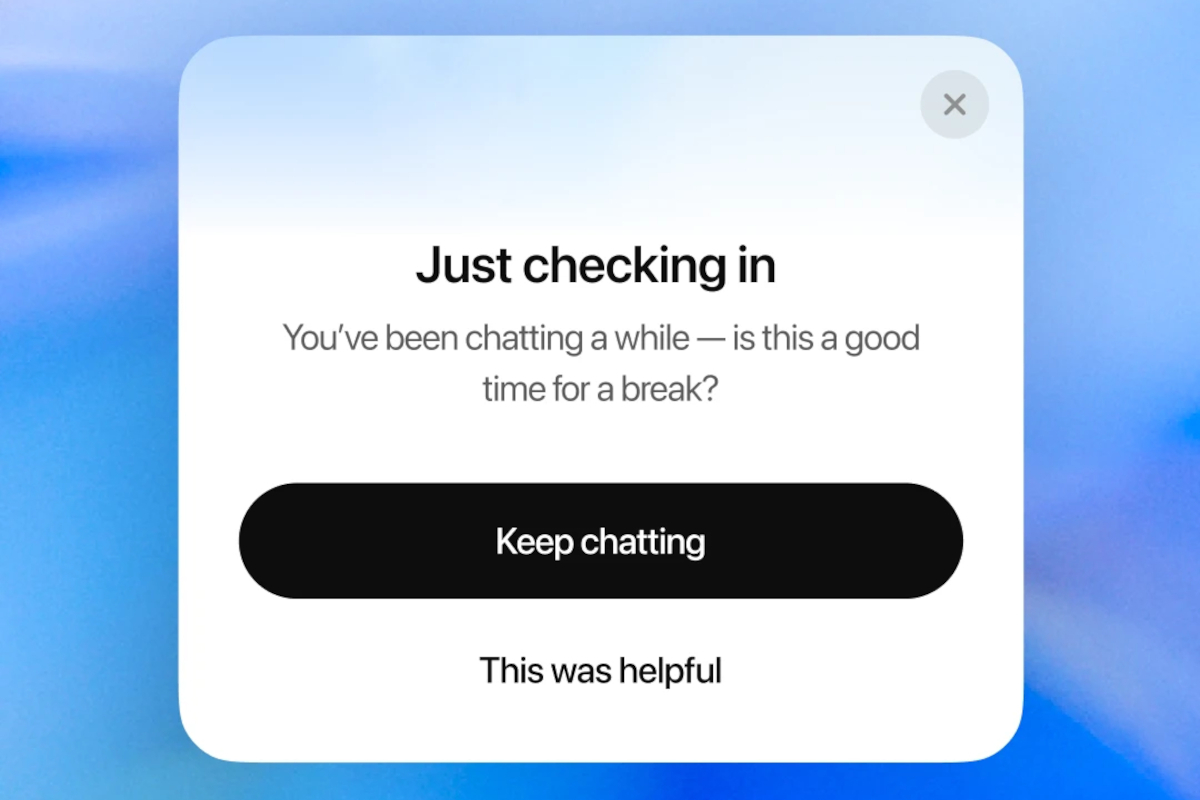

La première mesure est simple. Lors de sessions prolongées, ChatGPT affichera désormais une notification pour encourager une pause. Un message en ce sens apparaîtra : « Vous discutez depuis un moment, est-ce le bon moment pour faire une pause ? »

Une fonctionnalité qui rappelle ce que proposent déjà des plateformes comme YouTube, Instagram ou d'autres réseaux sociaux. L'objectif est d'aider à garder le contrôle du temps d'écran et prendre du recul.

Le second changement est plus profond. Il concerne la gestion des décisions personnelles à fort enjeu. Vous demandez à ChatGPT si vous devriez rompre avec votre partenaire ? L'IA ne vous donnera plus de réponse directe. À la place, elle vous guidera dans votre réflexion, en posant des questions et en vous aidant à peser le pour et le contre.

Une démarche encadrée par des experts

Pour s'assurer que ces changements soient pertinents et sécurisés, OpenAI travaille avec des spécialistes. Il est fait mention de plus de 90 médecins de 30 pays, dont des psychiatres et des pédiatres, qui participent à l'élaboration de grilles d'évaluation pour les conversations complexes.

Des chercheurs en interaction homme-machine et des cliniciens sont consultés pour affiner les méthodes de détection des comportements à risque et tester des garde-fous. Un comité a également été créé pour garantir que l'approche d'OpenAI reflète les meilleures pratiques actuelles.