Une version avancée de l'IA Gemini de Google DeepMind a obtenu un score digne d'une médaille d'or aux Olympiades Internationales de Mathématiques (IMO) dans son édition 2025. Il s'agit de la compétition la plus prestigieuse au monde pour les jeunes mathématiciens.

Google DeepMind souligne que les médailles sont décernées à la meilleure moitié des candidats. Environ 8 % d'entre eux reçoivent une médaille d'or. L'IA se positionne alors non plus comme un simple outil, mais comme un concurrent redoutable pour l'élite intellectuelle humaine.

Une performance certifiée qui change la donne

Contrairement aux tentatives précédentes, cet exploit a été réalisé dans les règles de l'art. L'IA de Google a été officiellement évaluée et certifiée par les coordinateurs de l'IMO, suivant les mêmes critères que les étudiants en chair et en os.

En résolvant parfaitement cinq des six problèmes en moins de 4,5 heures, Gemini a récolté 35 points sur 42, un score qui lui assure l'or. Le président de l'IMO, Gregor Dolinar, a qualifié la performance de remarquable : « Nous pouvons confirmer que Google DeepMind a atteint ce jalon tant convoité. […] Leurs solutions étaient étonnantes à bien des égards. Les correcteurs de l'IMO les ont trouvées claires, précises et pour la plupart faciles à suivre. »

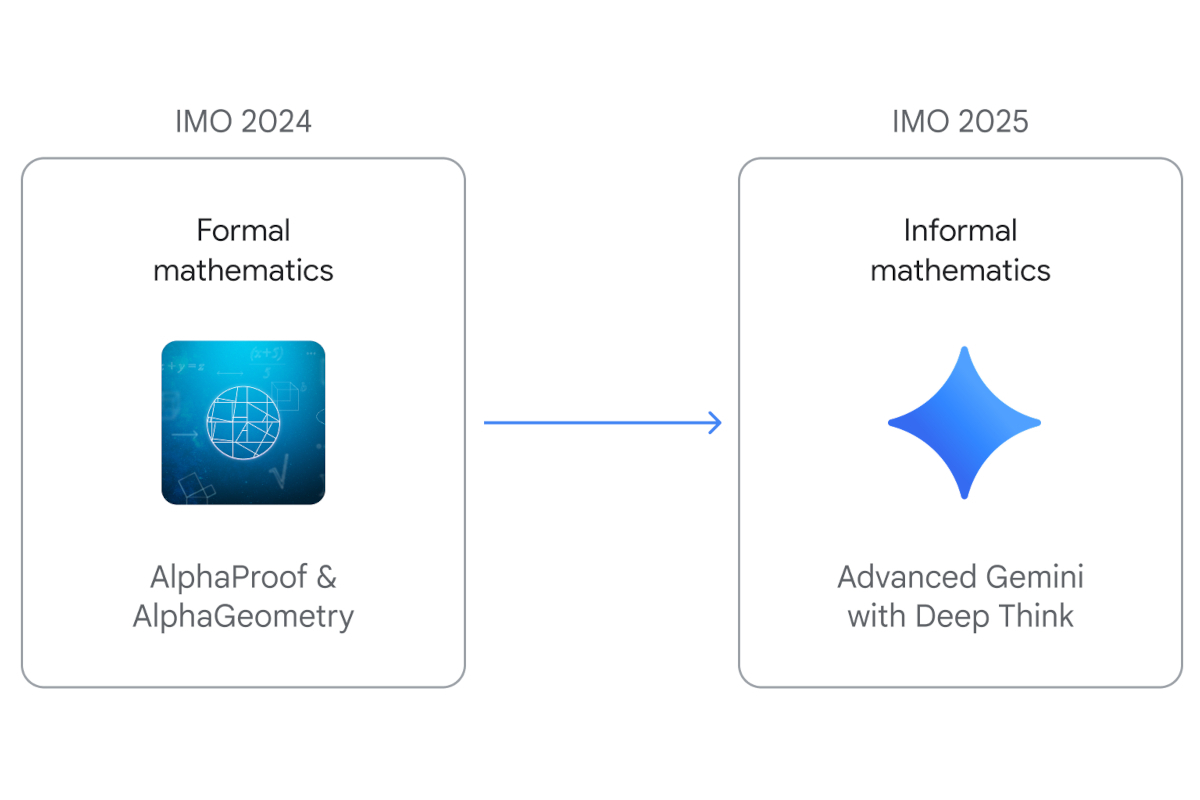

C'est un saut de géant par rapport à l'année dernière. En 2024, le modèle de Google avait besoin d'experts pour traduire les problèmes en langage machine. Cette année, l'IA a tout fait seule, en partant du langage naturel pour produire des preuves mathématiques rigoureuses.

Gemini Deep Think : le secret d'une IA experte en mathématiques

Comment un tel résultat est-il possible ? La réponse se trouve dans une version spéciale du modèle, baptisée Gemini Deep Think. Ce mode de raisonnement avancé expérimental s'appuie sur une approche de « pensée parallèle », lui permettant d'explorer simultanément plusieurs pistes de raisonnement au lieu de suivre une seule idée linéaire.

Pour la préparation à l'épreuve, Google a eu recours à un entraînement avec des techniques d'apprentissage par renforcement novatrices, en fournissant une base de données de solutions mathématiques de très haute qualité. L'IA a même fait preuve d'une forme d'ingéniosité. Sur un problème, de nombreux candidats humains ont utilisé un théorème de niveau universitaire. Gemini a trouvé une solution plus élégante en utilisant uniquement des mathématiques élémentaires.

Même les génies ont cependant leurs limites. Le modèle a échoué sur le sixième problème, jugé le plus difficile de la compétition et que seuls cinq étudiants ont réussi à résoudre.

La bataille de la crédibilité avec OpenAI

L'arène des maths est aussi devenue le théâtre d'une rivalité féroce. Avant l'annonce de Google, OpenAI avait revendiqué l'équivalent d'une médaille d'or avec un modèle expérimental. La situation a rapidement tourné à la polémique.

Google souligne être le seul à avoir suivi le processus de validation officiel de l'IMO. De son côté, OpenAI a admis avoir fait évaluer ses résultats par un panel de trois anciens médaillés des Olympiades, une méthode qui, selon Google, ne garantit pas la même rigueur.

Cette passe d'armes illustre la course acharnée que se livrent les géants de la tech pour la perception publique. Être vu comme le leader de l'IA est aussi un enjeu majeur pour attirer les meilleurs talents et convaincre les marchés.

La version surpuissante de Gemini pour les opérations de mathématiques et de codage très complexes sera prochainement accessible aux abonnés de Google AI Ultra. Pour OpenAI, son modèle de raisonnement doué en mathématiques ne sera pas intégré à GPT-5 et attendra encore plusieurs mois avant une disponibilité.