S'appuyant sur les mêmes technologies que celles utilisées pour la création des modèles Gemini, les modèles Gemma de Google DeepMind sont des modèles d'IA open source. Ils entrent dans le registre des petits modèles de langage SLM (Small Language Model), par opposition aux grands modèles de langage LLM (Large Language Model).

Un bon entre Gemma 2 et Gemma 3

En se basant sur Gemini 2.0, Google introduit Gemma 3 dans une variété de tailles : 1B, 4B, 12B et jusqu'à 27B pour 27 milliards de paramètres. Les développeurs ont ainsi l'opportunité d'opter pour le modèle le mieux adapté à leurs besoins en matière de matériel et de performances.

De fait, les modèles plus petits sont plus rapides et nécessitent moins de ressources de calcul, tandis que les modèles plus grands se positionnent pour de meilleures performances avec des tâches plus complexes à exécuter.

La fenêtre de contexte de Gemma 3 est de 32 000 tokens (1B) ou 128 000 tokens (4B, 12B et 27B), alors qu'elle est de 8 000 tokens pour Gemma 2. De quoi traiter de grandes quantités d'informations.

Hormis Gemma 3 1B (uniquement anglais), les autres versions de Gemma 3 sont multimodales (images et texte) et prennent en plus de 140 langues.

Une prouesse à seul GPU

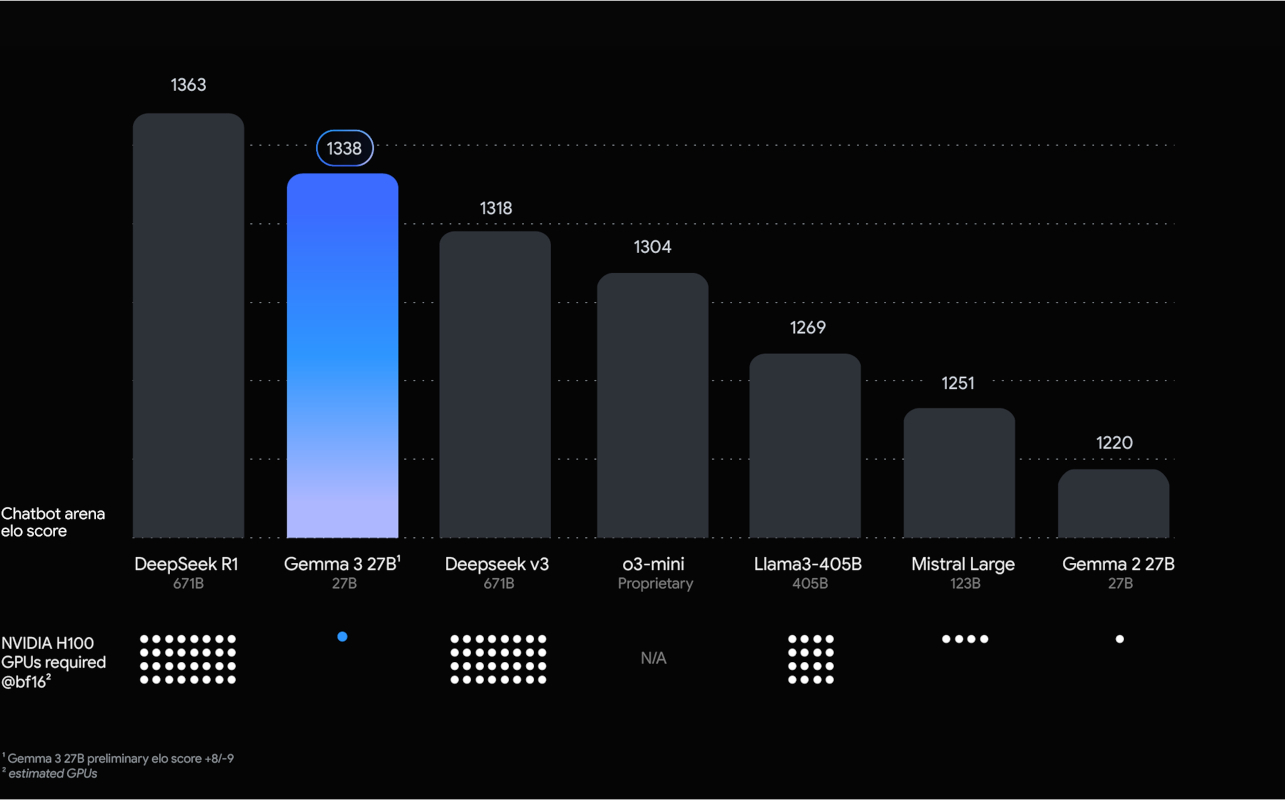

Une caractéristique principale de Gemma 3 est sa capacité à offrir des performances de pointe en comparaison à sa taille, jusqu'à surpasser d'autres modèles de même catégorie tout en fonctionnant sur un seul GPU ou un hôte TPU.

Avec le système de classement Elo et la plateforme Chatbot Arena pour évaluer les préférences des utilisateurs, Gemma 3 27B se positionne largement devant o3-mini (OpenAI), Llama3 405B (Meta), Mistral Large (123B ; Mistral AI) et Gemma 2 27B.

Gemma 3 27B est pris en sandwich entre DeepSeek R1 (98 % de son score) et DeepSeek V3, mais en tournant sur un seul accélérateur Nvidia H100 contre « l'équivalent » de 32. Il s'agit néanmoins d'une évaluation avec une part de subjectivité inhérente.

Rappelons par ailleurs que s'il est fait mention de 671 milliards de paramètres pour les modèles de DeepSeek, ils peuvent utiliser de manière sélective 37 milliards de paramètres en désactivant certaines parties.