Le mois de mai 2024 marque un tournant dans l'usage des intelligences artificielles en apportant de nouvelles formes d'interactions beaucoup plus naturelles et fluides, ce qui donne à l'IA un côté plus humain et facile à prendre en main.

OpenAI a donné le ton dès lundi en annonçant GPT-4o, son modèle d'IA conçu pour comprendre des instructions vocales et interpréter un contexte à partir d'image et de vidéos, mais aussi de pouvoir répondre en y ajoutant des intonations en fonction de ce qui a été interprété.

Cela permet de tenir une conversation vivante avec l'IA comme s'il s'agissait d'un humain, avec une meilleure interprétation du contexte et une latence réduite. L'ère des prompts est-elle déjà bientôt révolue ?

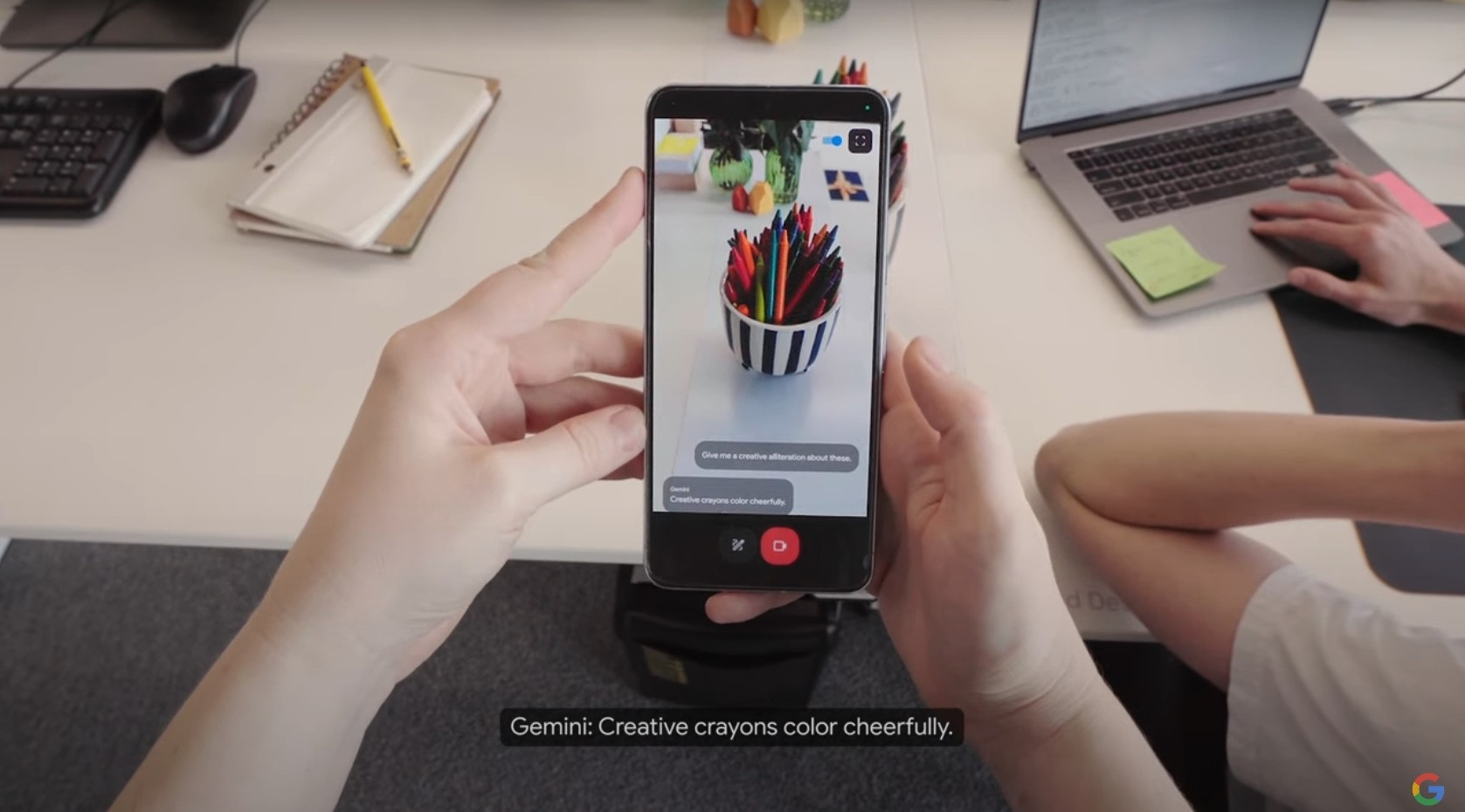

De son côté, Google a dévoilé durant son événement annuel Google I/O 2024 ses dernières avancées en matière d'intelligence artificielle. Parmi celles-ci, il y a le Project Astra conçu avec Google Deepmind qui offre la même possibilité de communiquer par la voix, l'image ou la vidéo avec l'IA Gemini.

Project Astra, quand Gemini se fait plus vivant

La firme en avait donné un aperçu avant la keynote sans préciser de quoi il s'agissait, la démonstration réalisée sur smartphone se suffisant à elle-même. Elle l'a détaillée par la suite en la présentant comme l'avenir des assistants numériques.

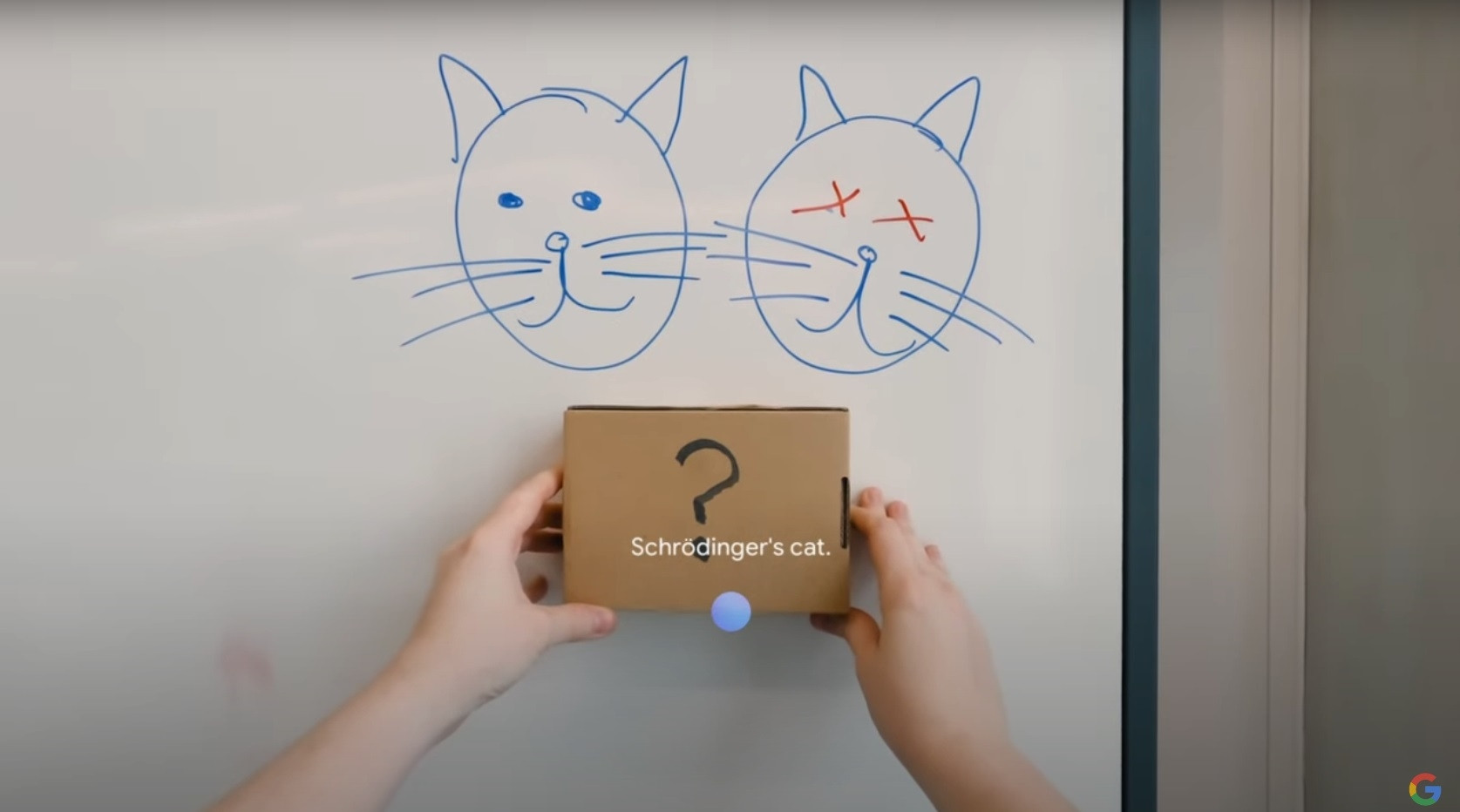

Comme pour GPT-4o, le Project Astra donne la possibilité à Gemini d'interpréter des instructions vocales et visuelles qui enrichissent sa compréhension du contexte et lui permettent de tirer ses propres déductions sur le ton d'une conversation dans laquelle l'IA décrit ce qu'elle voit et comprend tout en relançant la discussion par des questions pour engranger plus de données et orienter ses observations vers ce qu'attend l'utilisateur.

Là où Google avait fait une démonstration similaire il y a quelques mois de ce que pourrait être une conversation naturelle avec une IA (en trichant un peu), l'entreprise réalise cette fois une véritable démonstration montrant les nouvelles capacités de l'intelligence artificielle et surtout sa puissance d'adaptation.

GPT-4o et Project Astra se percutent frontalement sur les intentions et les démos d'OpenAI ont un côté plus abouti avec une voix plus naturelle et des temps de latence plus réduits, mais cela reste de la démonstration qui doit être testée en conditions réelles tandis que Google ne dévoile sans doute pas tout des capacités de son propre projet.

Gemini a beaucoup à offrir

Google indique ainsi que sa démonstration du Project Astra a été réalisée avec un smartphone Pixel...mais aussi avec un prototype de lunettes connectées qui pourrait constituer le vecteur parfait pour les nouvelles capacités des IA en levant la contrainte de tenir le smartphone et d'orienter ses caméras vers la scène à analyser.

Avec des lunettes connectées, l'IA pourrait simplement suivre le regard de l'utilisateur et interpréter directement ce qu'elle voit, voire anticiper les requêtes selon des scénarios dignes des films d'anticipation.

OpenAI a tout de même réussi à casser l'effet de surprise de ces nouveaux modèes d'interactions avec l'IA en dévoilant sa propre solution un jour avant Google. La conquête de l'IA se poursuit et les annonces ne sont plus séparées que de quelques heures, contre quelques mois précédemment, témoignant de la vivacité du secteur et de la forte concurrence qui s'y joue.

Ces transformations vont également modifier en profondeur la façon dont on réalise des recherches sur Internet. L'intégration de Gemini dans Google Search reste toujours expérimentale mais gagne rapidement en puissance.

Gemini promet enfin de révolutionner la recherche photo avec la nouvelle fonctionnalité Ask Photos qui permet de retrouver un ancien cliché dans une masse de photos en décrivant simplement la scène.