La course à l'intelligence artificielle s'accélère et la hiérarchie des grands modèles de langage est plus volatile que jamais. Le classement de septembre 2025 de la plateforme LMArena, qui fait référence en matière d'évaluation par les utilisateurs, confirme un changement de paradigme majeur.

Si OpenAI a longtemps fait la course en tête, son nouveau fleuron, GPT-5, peine à convaincre, laissant le trône à un concurrent de plus en plus redoutable : Claude 4.1 d'Anthropic. Ce nouveau paysage, plus fragmenté, montre qu'il n'y a plus une seule IA pour tout dominer, mais des champions spécialisés dans des domaines distincts.

Quel est le classement général des IA en septembre 2025 ?

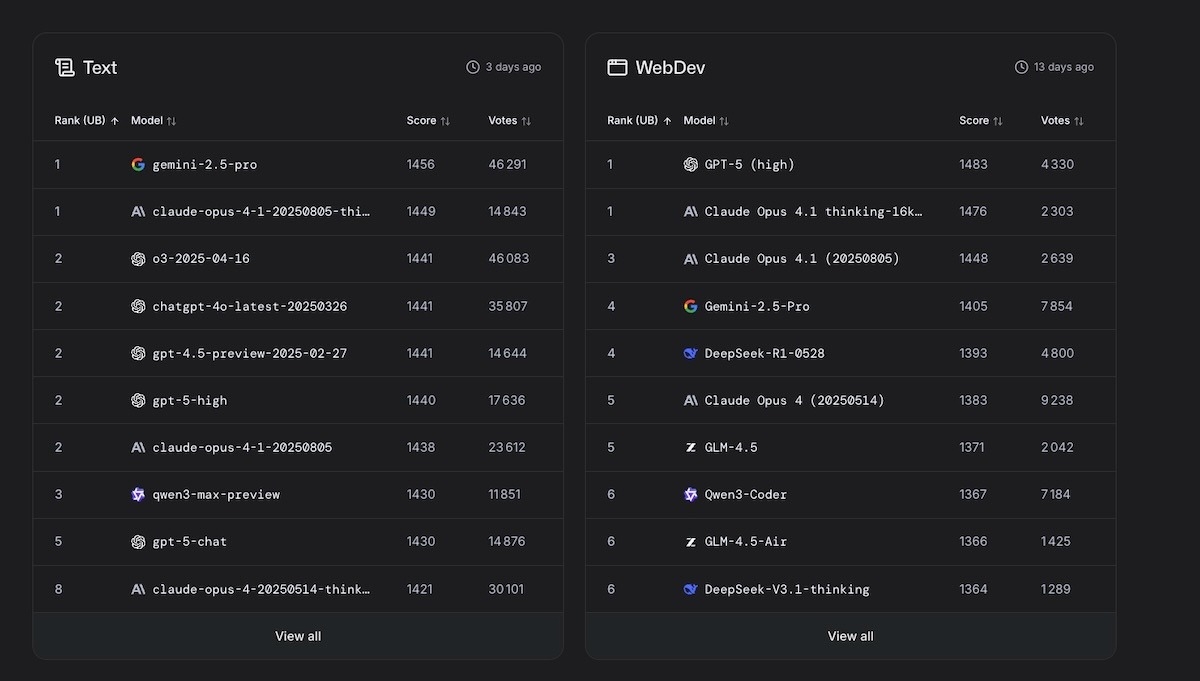

Les résultats de LMArena, basés sur des centaines de milliers de votes d'utilisateurs, sont sans appel. Le modèle Claude Opus 4.1 d'Anthropic, dans sa version "thinking", occupe la première place avec une avance confortable. Il est suivi par le Gemini 2.5 Pro de Google, qui confirme sa montée en puissance.

La surprise vient d'OpenAI : non seulement son ancien modèle phare, GPT-4o, se maintient de justesse sur le podium, mais son très attendu GPT-5 s'effondre à la sixième place. Le marché global des logiciels d'IA est en pleine explosion, et cette compétition féroce pousse chaque acteur à trouver son terrain d'excellence pour survivre.

Quelle IA est la meilleure pour des tâches spécifiques ?

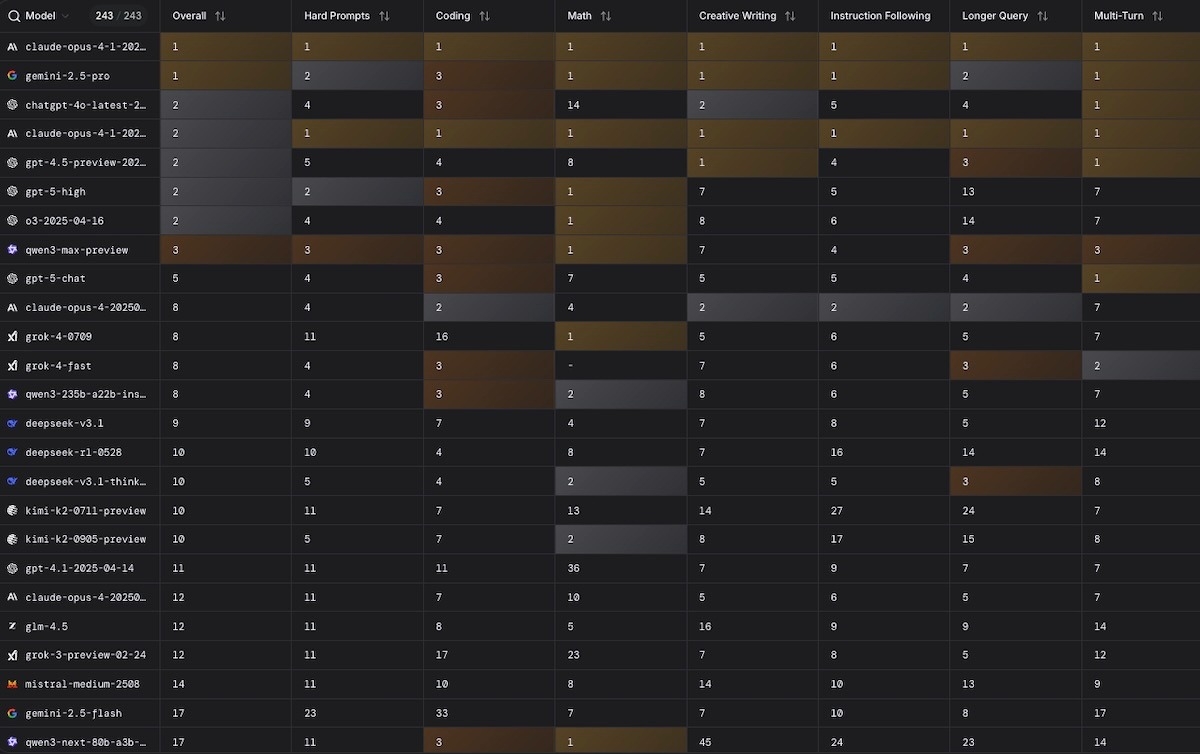

L'ère de l'IA "à tout faire" semble révolue. Le classement détaillé de LMArena met en lumière une spécialisation de plus en plus marquée selon les usages :

- Génération de texte : Gemini 2.5 Pro de Google reste le maître incontesté.

- Développement web et code : C'est le pré carré de GPT-5, qui domine cette catégorie.

- Génération d'images : Seedream, un modèle de ByteDance (la maison mère de TikTok), crée la surprise en devançant les IA de Google.

- Recherche web : Grok-4 d'xAI s'impose, détrônant les précédents leaders.

Cette fragmentation oblige désormais les utilisateurs à adopter une approche multi-outils, en choisissant le modèle le plus pertinent pour chaque besoin spécifique.

Comment LMArena établit-il ce classement ?

La force du classement LMArena réside dans sa méthodologie, qui se veut la plus objective possible en s'appuyant sur l'avis humain. La plateforme organise en permanence des "duels" à l'aveugle : deux modèles d'IA répondent à la même instruction, et les utilisateurs votent pour la meilleure réponse sans savoir qui l'a générée.

Un score Elo, similaire à celui utilisé pour les échecs, est ensuite calculé pour chaque modèle. Ce système de vote massif et anonyme permet de refléter la performance perçue dans des conditions réelles, loin des benchmarks synthétiques souvent biaisés. C'est une approche cruciale pour évaluer une industrie en constante évolution.

Foire Aux Questions (FAQ)

Le nouveau GPT-5 est-il un échec ?

Pas tout à fait un échec, mais son lancement est en deçà des attentes colossales qu'il suscitait. S'il excelle dans des domaines techniques comme le codage, il semble marquer le pas face à Claude Opus 4.1 en matière de raisonnement complexe, de nuance et de créativité textuelle. OpenAI a probablement encore une marge de progression avant de retrouver son leadership incontesté.

Pourquoi Claude Opus 4.1 est-il si performant ?

Le modèle d'Anthropic se distingue par sa capacité à gérer des contextes longs et complexes, à produire des raisonnements détaillés et à générer des textes d'une grande cohérence. Sa version "thinking" semble bénéficier d'une capacité de planification et de structuration de la pensée avant de générer la réponse, ce qui lui confère une supériorité notable sur un large éventail de tâches.

Ce classement va-t-il encore évoluer ?

Oui, et très rapidement. Le secteur de l'IA avance à une vitesse fulgurante, avec des mises à jour et de nouveaux modèles annoncés presque chaque mois. Le classement LMArena est mis à jour en continu et il est certain que la hiérarchie que nous observons aujourd'hui sera à nouveau bousculée dans un futur très proche.