Nous entrons dans une ère où lire les pensées n'est plus tout à fait de la science-fiction. Une étude publiée dans Science Advances détaille une nouvelle technique : le "mind captioning".

Elle utilise des scanners IRM et des modèles de langage (IA) pour générer des descriptions structurées et détaillées de ce que les participants voient ou se rappellent.

Comment fonctionne cette technique de "légendage de l'esprit" ?

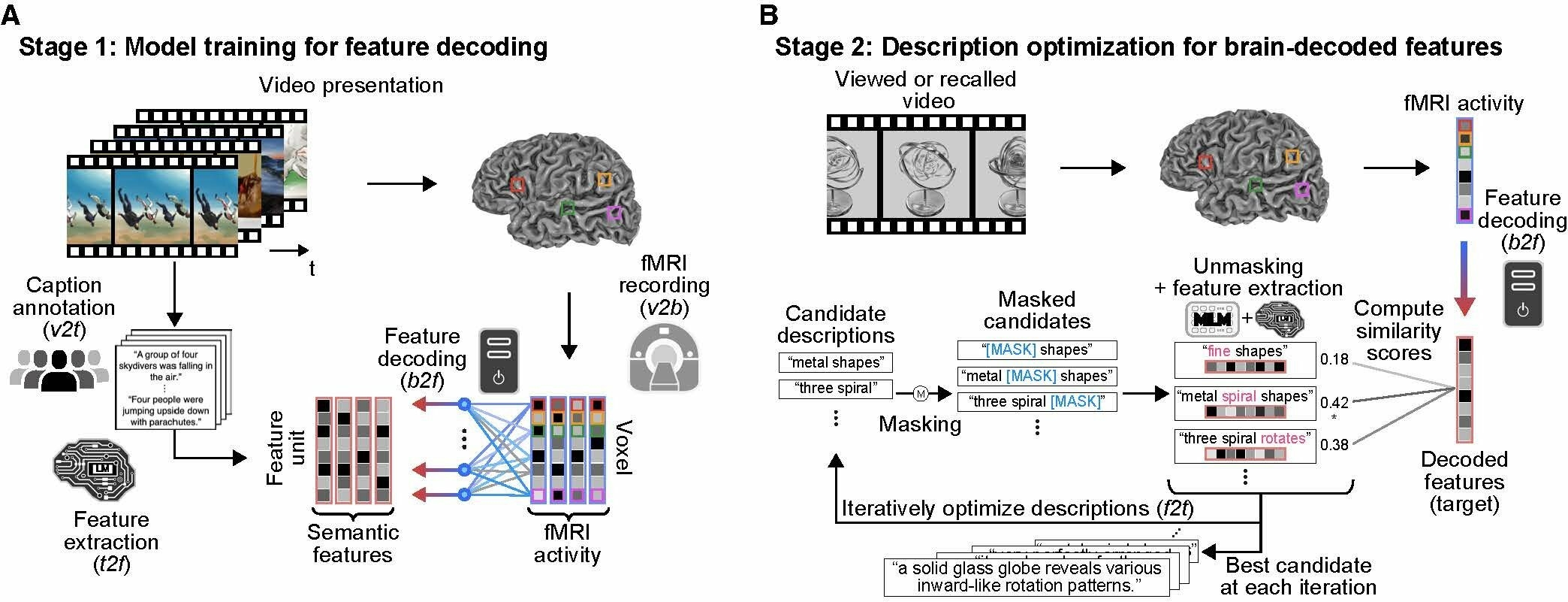

Le processus est complexe : des participants ont regardé 2196 courtes vidéos pendant que leur activité cérébrale était scannée par IRMf. Un modèle de langage (DeBERTa-large) a d'abord analysé les descriptions de ces vidéos pour en extraire des "caractéristiques sémantiques".

Un autre modèle (RoBERTa-large) a ensuite été entraîné à faire le lien entre ces caractéristiques et l'activité du cerveau. L'IA génère ensuite des phrases par "optimisation itérative" pour coller au mieux au signal cérébral.

Est-ce plus précis que les méthodes précédentes ?

Oui, et c'est là toute la différence. Les techniques antérieures se concentraient sur des mots uniques ou devaient analyser les zones du langage du cerveau. Cette nouvelle approche, basée sur l'IRM, est différente.

Elle décode des "représentations sémantiques complexes" (les relations entre les objets, les actions) directement depuis les zones visuelles et associatives. Elle n'a pas besoin que le sujet "pense" les mots. L'étude a atteint 50% de précision pour identifier la bonne vidéo parmi 100, ce qui est bien au-dessus du hasard (1%).

L'IA peut-elle aussi lire les souvenirs ?

C'est l'étape la plus fascinante. Les chercheurs ont demandé aux participants de se remémorer les vidéos, toujours sous IRM. L'IA a réussi à générer des descriptions reflétant le contenu des vidéos rappelées.

L'IA a pu identifier la vidéo rappelée parmi 100 candidates avec 40% de précision (chez les meilleurs sujets). Cela prouve que le cerveau encode des informations complexes et structurées en dehors des centres de langage traditionnels.

Quelles sont les implications et les risques ?

L'implication est double. D'un côté, c'est un espoir immense pour les personnes ayant perdu l'usage de la parole (AVC, SLA, aphasie). L'IA pourrait traduire leur pensée non verbale en langage.

D'un autre côté, les questions éthiques sont vertigineuses. Les chercheurs soulignent que la "vie privée mentale" et le consentement sont des préoccupations majeures avant toute utilisation plus large de cette technologie.

Foire Aux Questions (FAQ)

La description est-elle parfaite ?

Pas encore. Les chercheurs montrent un exemple où l'IA commence par "flux de printemps" (fragmenté), puis affine en "au-dessus d'une chute d'eau rapide" pour finir par "une personne saute par-dessus une chute d'eau profonde sur une crête de montagne". Le processus s'améliore par itérations.

Cette technologie peut-elle lire mes pensées secrètes ?

Pas pour l'instant. Les chercheurs sont clairs : le modèle actuel est entraîné sur des perceptions visuelles (vidéos) ou des souvenirs de ces perceptions. Il n'a pas été démontré qu'il pouvait décoder des pensées privées ou abstraites non liées à une stimulation visuelle.