Alors que Meta vient tout juste de rendre disponible son plus grand modèle d'IA open source à ce jour avec Llama 3.1, Mistral dégaine Mistral Large 2. Face à une version de Llama 3.1 comptant 405 milliards de paramètres, Mistral fait valoir une taille de 123 milliards de paramètres, sans rougir de la concurrence.

Mistral indique que la nouvelle génération de son grand modèle de langage phare est conçue pour l'inférence sur un seul nœud H100, ce qui le rend performant et rentable. Un autre point mis en avant est une meilleure gestion des hallucinations.

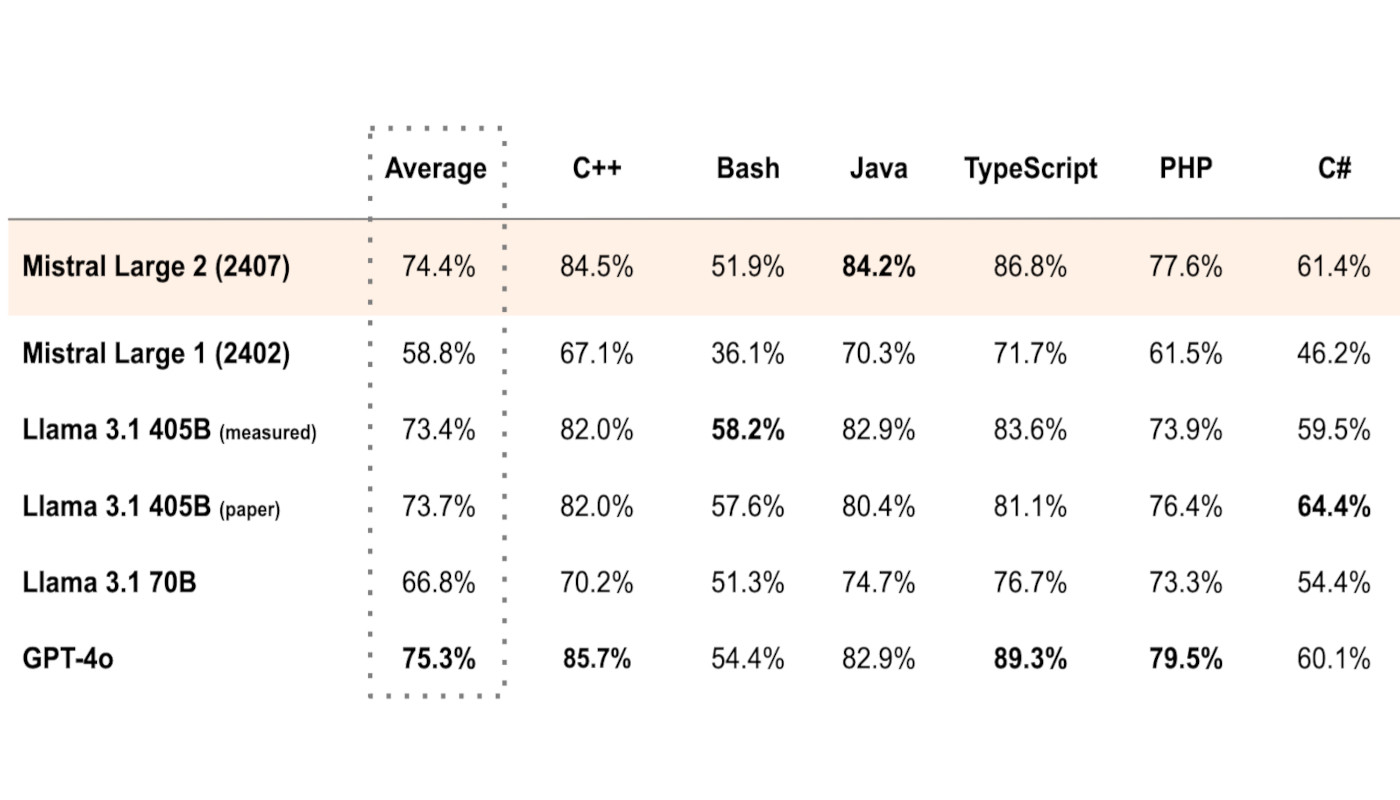

Avec une fenêtre contextuelle de 128 000 tokens et la prise en charge native de près d'une quinzaine de langues, Mistral Large 2 obtient des résultats comparables à GPT-4o d'OpenAI et Llama 3 405B en matière de génération de code, mathématiques et raisonnement.

Une large disponibilité

Pour les développeurs, une fonction calling permet au modèle d'exécuter des appels de fonctions parallèles et séquentiels. Mistral souligne ainsi un " moteur d'alimentation d'applications métiers complexes. "

La publication de Mistral Large 2 se fait sous l'égide d'une licence gratuite Mistral Research qui autorise l'utilisation et la modification pour la recherche et les usages non-commerciaux. Dans le cadre d'une utilisation commerciale et un déploiement autonome, une licence Mistral Commercial doit être acquise.

Hormis une arrivée sur diverses plateformes (Google Vertex AI, Azure AI Studio, Amazon Bedrock, IBM watsonx.ai), Mistral Large 2 est disponible par le biais de La Plateforme (infrastructure dans l'UE) en tant que mistral-large-2407 et peut être testé avec le chatbot IA Le Chat (Le Chat Mistral).