En début d'année, la start-up française d'intelligence artificielle générative Mistral AI a introduit le modèle Mistral Small 3. Avec une mise à disposition sous licence Apache 2.0, Mistral Small 3 avait été vanté comme complémentaire des grands modèles de raisonnement open source.

Modèle de 24 milliards de paramètres, Mistral Small 3 se montrait compétitif par rapport à des modèles plus grands de type LLM (Large Language Model), en plus d'être un remplaçant open source à GPT-4o mini d'OpenAI.

Des améliorations pour la fiabilité

Depuis, une version 3.1 de Mistral Small a vu le jour, et c'est désormais une mouture 3.2 qui vient d'être officialisée. En comparaison à Mistral Small 3.1, il s'agit d'une petite mise à jour.

Pour Mistral Small 3.2, Mistral AI met en avant plusieurs améliorations ciblées, en particulier une compréhension et une exécution plus fidèles des consignes précises qui sont données. La mise à jour tend également à réduire les erreurs de répétition, à savoir la génération de texte en boucle ou la répétition de mêmes phrases.

Un autre aspect souligné avec la mise à jour mineure est l'amélioration de l'appel de fonctions. En la matière, le modèle est plus robuste ce qui rend l'intégration à des systèmes ou des outils externes plus stable et prévisible.

Performances en hausse... mais pas partout

Avec le passage d'une version 3.1 à 3.2, le suivi des instructions précises du modèle obtient une justesse de 84,74 % contre 82,75 % auparavant. Un gain peut-être modeste, mais qui a son importance.

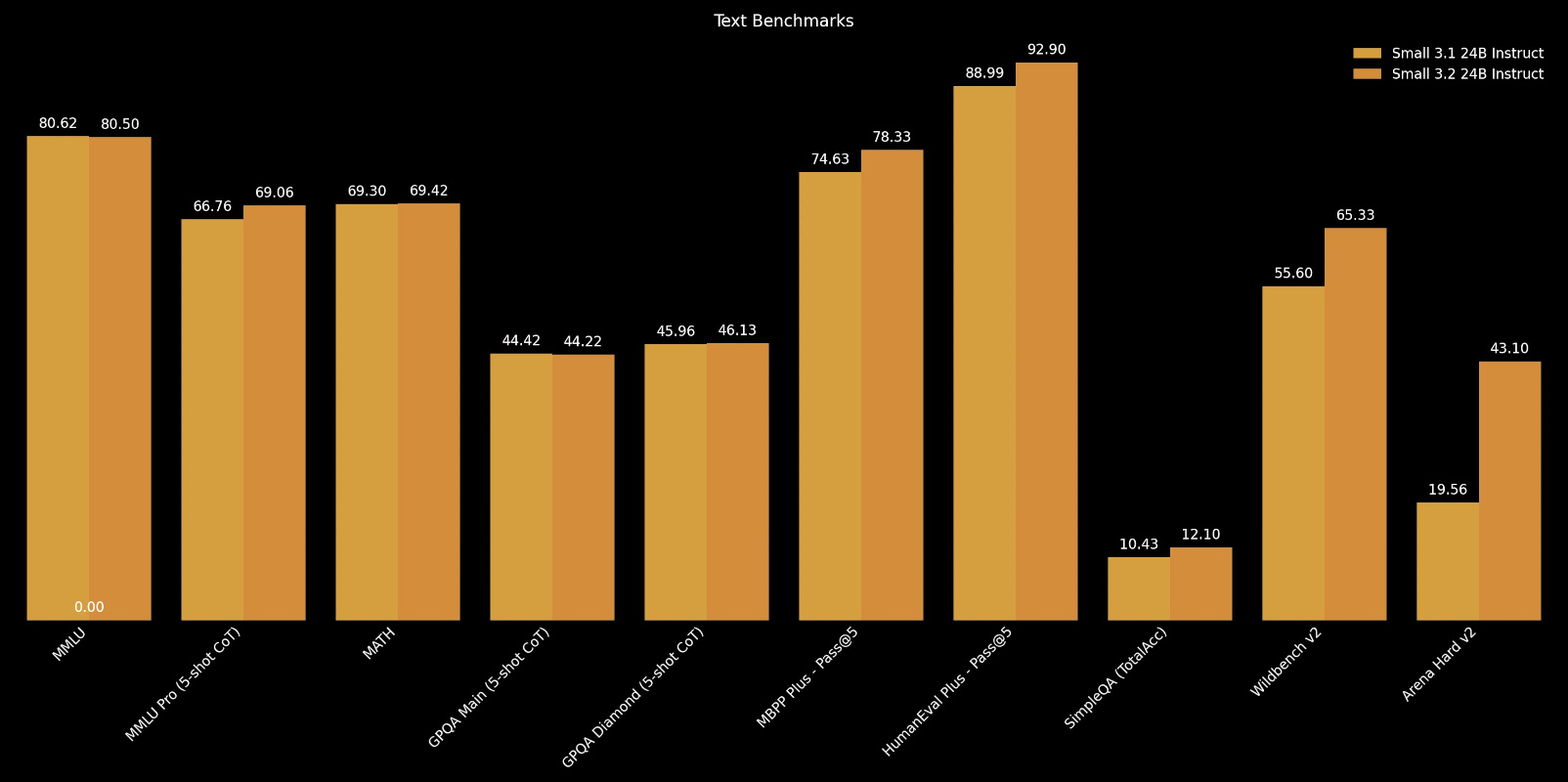

Si Mistral Small 3.2 progresse nettement sur des tests de raisonnement et de codage tels que HumanEval Plus (88,99 % à 92,90 %) ou Arena Hard (19,56 % à 43,10 %), il peut toutefois marquer le pas ailleurs.

Une régression notable concerne le benchmark MMLU de compréhension linguistique multidisciplinaire. Le score baisse légèrement de 80,62 % à 80,50 %.