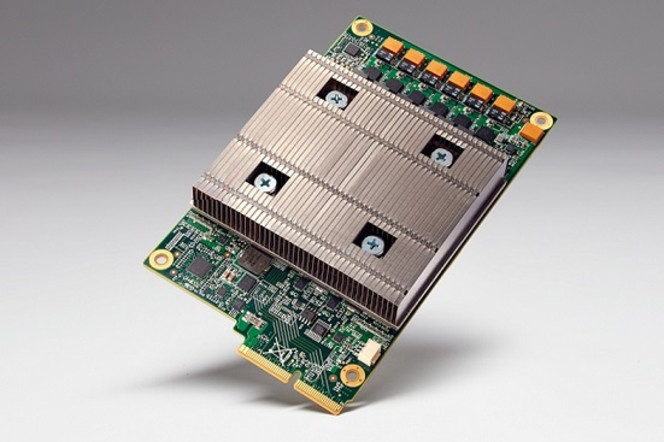

Parallèlement au développement d'un environnement TensorFlow dédié au machine learning et aux intelligences artificielles, Google a créé son propre hardware dédié avec le TPU (TensorFlow Processing Unit) afin de gérer plus efficacement les charges de travail spécifiques du machine learning par rapport à d'autres configurations.

Google n'avait pas donné beaucoup de détails sur ce composant qui a été l'un des artisans du succès de l'intelligence artificielle AlphaGo pour vaincre d'excellents joueurs humains mais une nouvelle publication apporte divers détails, notamment sur ses performances.

Par son fonctionnement spécifique, le TPU offrirait une réactivité de traitement de charges de machine learning largement supérieure à celle de configurations CPU/GPU et une efficience énergétique bien plus élevée.

Google indique avoir tenté diverses approches depuis plusieurs années, passant par les GPUS et les FPGA puis vers les composants ASICS dédiés, avant d'arriver à la forme finale du TPU adapté pour un type particulier de réseau neuronal, les perceptrons multi-couches, selon une approche différente de la plupart des solutions concurrentes.

En l'état, le groupe de Mountain View ne prévoit de proposer ses composants TPU ailleurs que dans ses serveurs cloud mais les travaux réalisés pourront toujours servir à développer des dérivés commerciaux.