Lors de la conférence Google I/O 2016, le géant de Mountain View a levé le voile sur le TPU (TensorFlow Processing Unit), un composant qu'il a conçu en interne pour répondre spécifiquement aux besoins des intelligences artificielles.

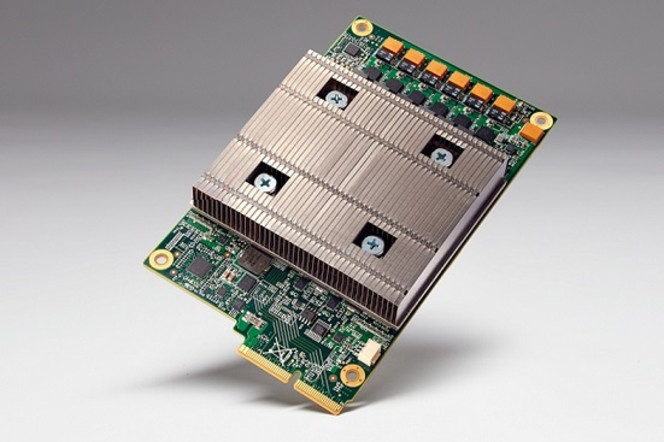

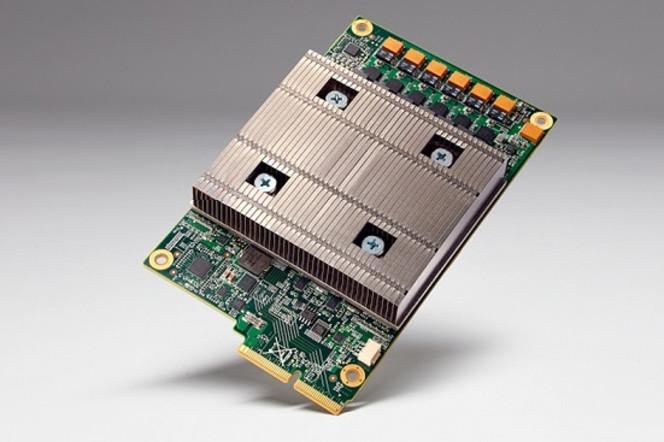

Le groupe s'est assez peu étendu sur l'architecture de ce nouvel élément déjà déployé dans les serveurs de certains de ses datacenters et l'image officielle fournie révèle peu de détails. Le site Re/code a tenté d'en savoir plus et a demandé des précisions sur le TPU.

Toutes les interrogations n'ont pas trouvé de réponse mais elles apportent quelques détails sur la conception et le fonctionnement du composant. Re/code a tout d'abord demandé si le TPU était "pré-entraîné", à savoir si l'intelligence artificielle (AI) embarquée avait au préalable été entraînée sur un système externe (généralement par un procédé d'essais/erreurs de millions de combinaisons). Aucune réponse n'a été donnée mais cela pourrait bien être le cas, à l'image d'autres composants au fonctionnement similaire du marché.

Puisque les algorithmes d'AI sont susceptibiles d'évoluer au fil du temps, la question suivante a donc été de savoir si le TPU peut être reprogrammé pour prendre en compte ces changements. Le composant est compris comme un ASIC, un élément aux tâches très spécifiques et en principe peu évolutif mais il existe sur le marché des composants facilement reprogrammables connus sous l'acronyme FPGA (Field Programmable Gate Array).

Dans sa réponse, Google souligne que les FPGA, du fait de leur nature non spécifique, ne sont pas très efficients en matière de consommation d'énergie, mais dans le même temps, le groupe confirme que son TPU dispose d'un jeu d'instructions permettant de faire évoluer les algorithmes ou d'en intégrer de nouveaux.

Le groupe de Mountain View explique également que si le composant est optimisé pour sa ressource open source TensorFlow, il peut tout de même exploiter d'autres environnements pour intelligence artificielle. Par ailleurs, il confirme que plusieurs TPU ont été utilisés ensemble pour faire fonctionner AlphaGo, l'intelligence artificielle qui a remporté un duel en cinq manches (4-1) contre l'un des meilleurs joueurs au monde du jeu de go.

Enfin, aucun détail n'est donné sur la quantité de mémoire embarquée, cachée sous le large dissipateur de chaleur, ou sur le fondeur qui a produit ces composants et qui pourrait être TSMC ou GlobalFoundries, selon les premières spéculations.