Le groupe Microsoft avait créé la surprise en annonçant il y a quelques semaines ses premiers composants dédiés pour ses services cloud Azure et c'est au tour du géant de l'e-commerce Amazon de mettre à jour ses propres puces spécialisées et conçues en interne.

Ses composants progressent d'une génération avec le processeur AWS Graviton4 pour les services cloud d'une part et la puce AWS Trainium2 pour l'entraînement des intelligences artificielles d'autre part.

Comme toujours, ces puces sont pensées pour les besoins spécifiques de l'infrastructure AWS, avec une efficience, des caractéristiques particulières et des critères qui ne pourraient être obtenus avec des composants standard.

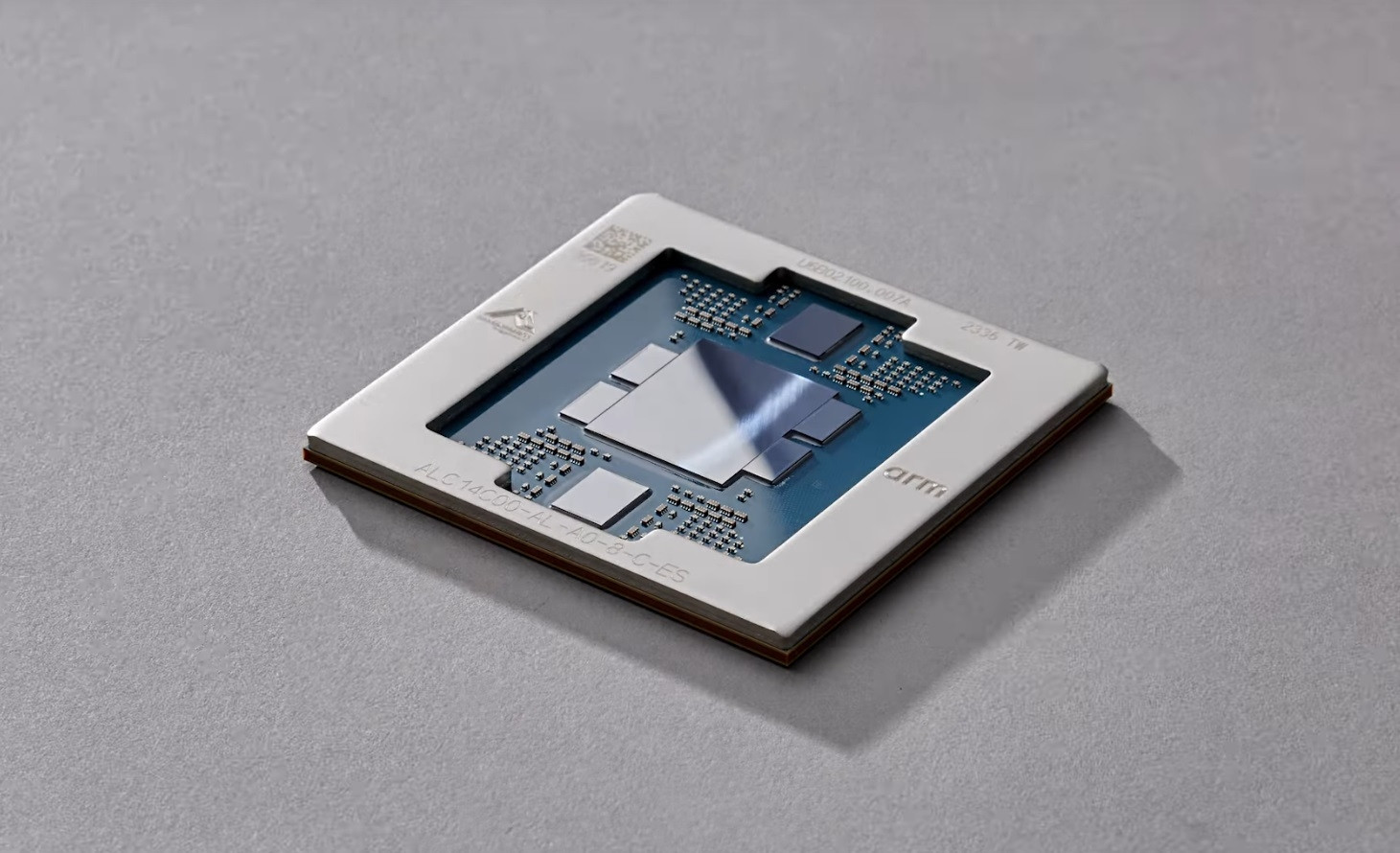

AWS Graviton4, le nouveau processeur phare pour les instances EC2

Le processeur Graviton4 offrira 30% de performance en plus par rapport à Graviton3 (annoncé en mai 2022) grâce à 50% de coeurs en plus et 75% de bande passante supplémentaire, tout en renforçant sa sécurité par des chiffrements supplémentaires.

Amazon AWS Graviton4

Les processeurs Graviton sont maintenant bien installés dans l'écosystème AWS avec 2 millions de processeurs (toutes générations) produits et utilisés par 50 000 clients, dont certains du Top 100 des clients des instances Amazon EC2 (Elastic Compute Cloud) avec la capacité de gérer de multiples charges de travail, des bases de données aux serveurs Web.

Graviton4 sera proposé sur les instances Amazon EC2 R8g destinées aux charges de travail demandant beaucoup de mémoire (bases de données, big data...). Cette configuration est déjà disponible en preview pour les clients intéressés avant une mise à disposition dans les mois qui viennent.

AWS Trainium2, tout pour entraîner les IA génératives

L'intelligence artificielle étant un domaine en forte progression, notamment pour entraîner des modèles de langage (LLM) qui donneront vie à des IA génératives toujours plus pertinentes, Amazon annonce également le composant AWS Trainium2 permettant un entraînement IA jusqu'à quatre fois plus rapide que la génération précédente, avec trois fois plus de capacité mémoire utilisable.

Il pourra être déployé dans de gros clusters Amazon EC2 UltraClusters pouvant regrouper jusqu'à 100 000 puces pour un entraînement IA plus rapide mais aussi plus efficace énergétiquement.

Trainium2 sera intégré dans les instances Amazon EC2 Trn2 avec 16 puces Trainium par instance. Le regroupement de 100 000 puces Trainium2 pourra donner naissance à des systèmes dotés d'une puissance de traitement de 65 exaflops IA, permettant d'entraîner des LLM de 300 milliards de paramètres en quelques semaines au lieu de plusieurs mois.

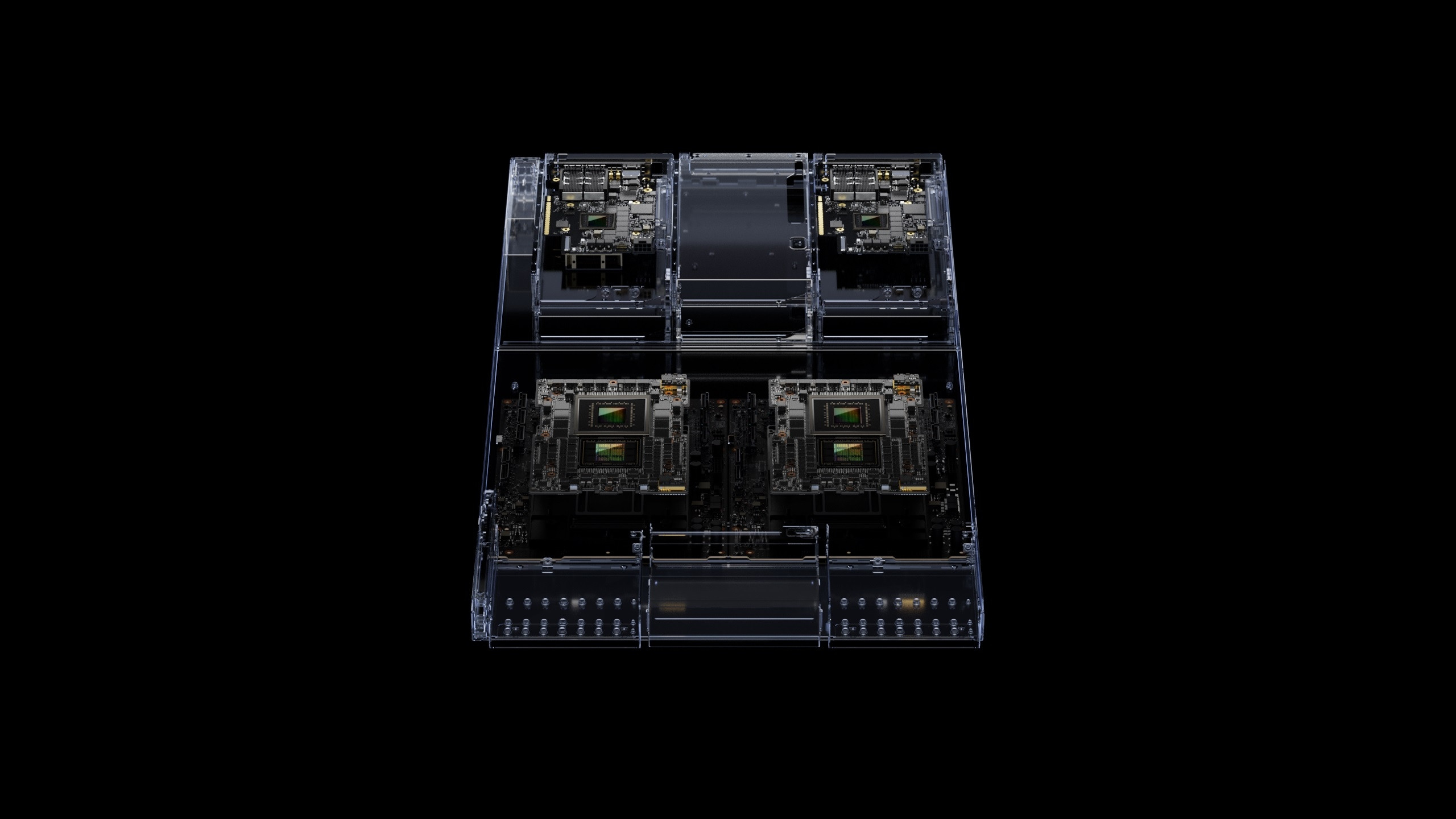

Les derniers produits IA de Nvidia dans AWS

Dans le même temps, Amazon ne laisse pas tomber Nvidia et annonce au contraire un partenariat étendu qui va lui permettre d'intégrer des superpuces Grace Hopper Nvidia GH200 reliées avec les technologies NVLink et NVSwitch de Nvidia.

Nvidia GH200

Il est aussi question d'intégrerma solution Nvidia DGX Cloud au sein de l'infrastructure AWS pour pouvoir entraîner des IA génératives et des LLM massifs de plus de 1000 milliards de paramètres.

Les deux entreprises travailleront sur le projet Ceiba qui vise à créer le plus gros supercalculateur AI alimenté par des GPU, ici 16 384 superpuces Nvidia GH200, pour déliver 65 exaflops de puissance de traitement en IA.

Enfin, AWS va créer de nouvelles instances EC2 : P5e avec des GPU Nvidia H200, G6 avec des composants Nvidia L4 et G6e avec des GPU L40S, toujours pour répondre aux besoins des projets d'intelligence artificielle.