Avec l'essor des intelligences artificielles, les accélérateurs graphiques deviennent une ressource stratégique et intéressent de plus en plus de monde. Pendant que Nvidia mène la danse avec son module H100 et que AMD prépare sa riposte, c'est Microsoft qui sort du bois à l'occasion de sa conférence Ignite.

La firme de Redmond y a en effet dévoilé ses propres composants dédiés pour l'IA qu'elle compte déployer dans son infrastructure cloud Azure pour faire tourner de nouveaux services comme Copilot et les applications dérivées de son partenariat avec OpenAI.

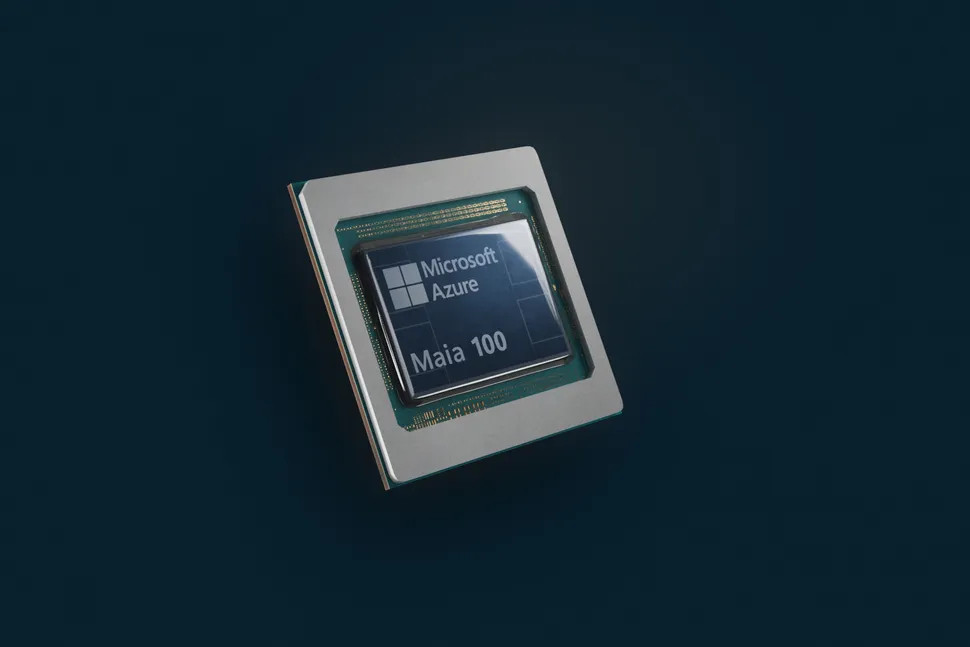

Maia 100, l'accélérateur graphique custom de Microsoft

Cela passera par un accélérateur graphique Azure Maia 100 de 105 milliards de transistors et gravé en 5 nm chez le fondeur TSMC et qui servira à faire fonctionner de larges modèles de langage (ou LLM). Sans surprise, OpenAI a servi de testeur et fourni des retours avant la mise en service de ce composant l'an prochain dans les serveurs de Microsoft.

L'intérêt de cette solution custom est qu'elle est spécifiquement taillée pour l'infrastructure et les besoins de Microsoft, ce qui devrait apporter de solides en efficacité. Cela reste également un composant exclusivement utilisé par Microsoft et pas destiné à se retrouver dans des structures concurrentes, contrairement aux accélérateurs graphiques d'autres marques.

Microsoft n'a toutefois pas fourni de comparatif de performances entre son composant Maia 100 et des équivalents du marché comme l'accélérateur Nvidia H100, très demandé dans l'écosystème des IA. Et c'est sans compter avec le composant Nvidia H200 qui doit pousser encore plus loin les performances et que Microsoft compte aussi utiliser l'an prochain, tout comme les accélérateurs MI300X d'AMD.

Cobalt 100, le CPU ARM de 128 coeurs 64-bit

A côté de ce nouvel accélérateur graphique, Microsoft a également présenté un processeur Cobalt 100 de 128 coeurs avec architecture ARM. Utilisant des coeurs ARM Neoverse, il promet une amélioration de performance de 40% par rapport aux solutions CPU ARM utilisées dans Azure actuellement.

La conception a porté ici sur une amélioration de la performance par watt et le processeur contribuera au fonctionnement de services comme Teams ou Azure SQL.

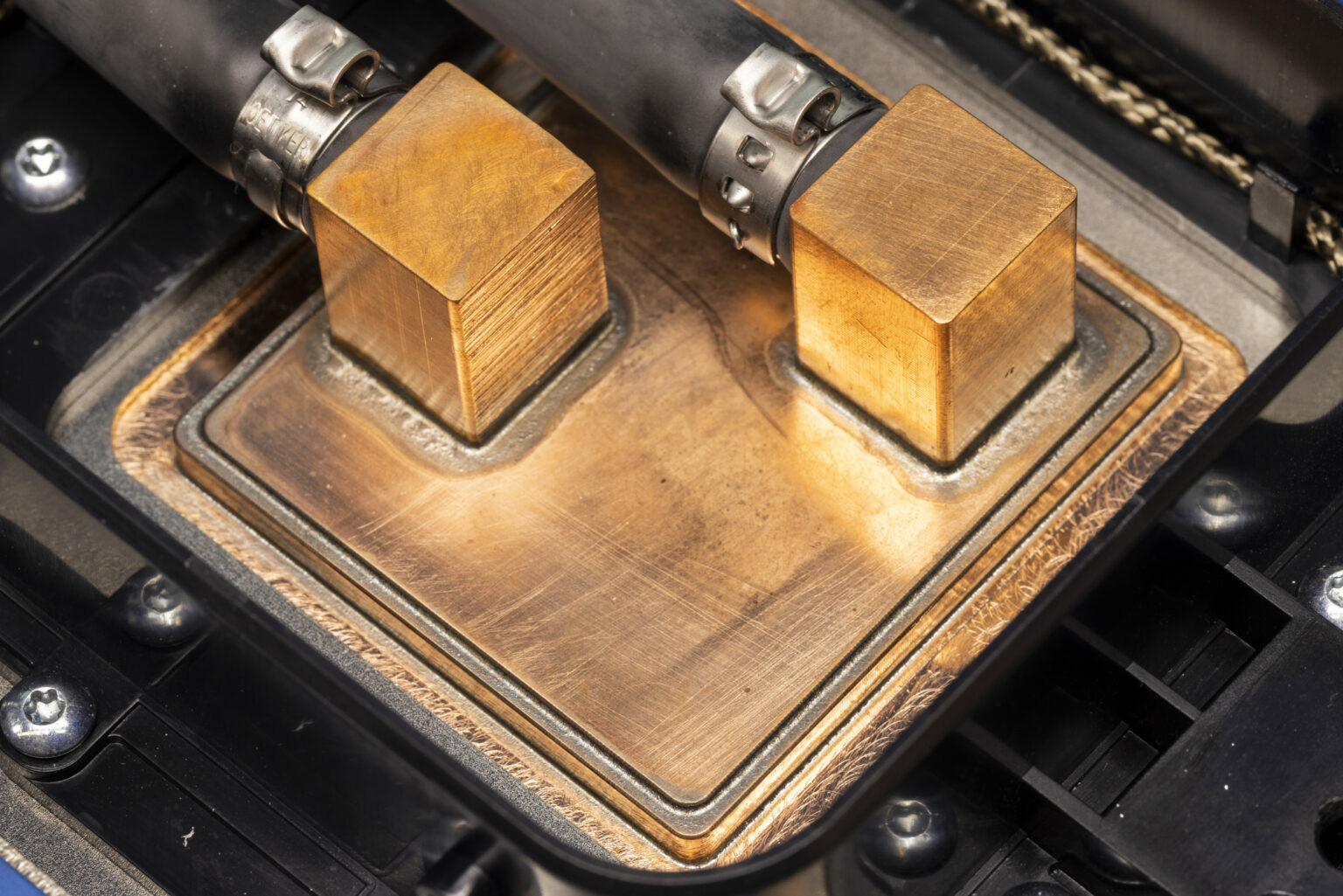

Et pour garantir un fonctionnement optimal des accélérateurs graphiques Maia 100, Microsoft a dû repenser l'architecture des racks de serveurs et surtout leur système de refroidissement.

Il a donc fallu imaginer un système spécifique de refroidissement des GPU, baptisé Sidekick, utilisant un mécanisme de refroidissement liquide au plus près de la puce plutôt que l'habituel refroidissement par ventilation d'air, insuffisante pour ce nouveau composant.

Les plaques de refroidissement liquide sur les GPU Maia

Cette solution doit permettre d'intégrer plus de GPU dans les racks et de donner ainsi aux datacenters plus de puissance de calcul. Microsoft ne donne pas encore beaucoup de détails sur ses deux puces custom mais indique qu'elles entreront en service dans le courant de l'année prochaine.