Depuis sa mise à disposition du public, l'agent conversationnel ChatGPT de la firme OpenAI a surpris bien du monde sur sa capacité à générer des réponses argumentées aux requêtes, laissant entrevoir l'avenir des moteurs de recherche, mais aussi à créer du texte de façon créative.

Sa capacité de rédaction sur tous les sujets ou presque (en fonction de la modération) peut aussi bien séduire pour ses possibilités d'aide à la création que faire craindre la disparition de certains métiers.

Elle est tellement convaincante qu'il n'a pas fallu longtemps pour s'apercevoir qu'elle pouvait rédiger des dissertations et mémoires à la place des étudiants avec un certain talent à défaut d'avoir un style flamboyant. C'est d'ailleurs ce qui peut confondre les petits malins. Encore faut-il avoir la puce à l'oreille.

Enfin un outil de détection ?

Cette possibilité de triche ravit les fraudeurs et inquiète les enseignants qui font sans doute face à une vague de copies produites en quelques secondes par l'intelligence artificielle plutôt qu'humaine.

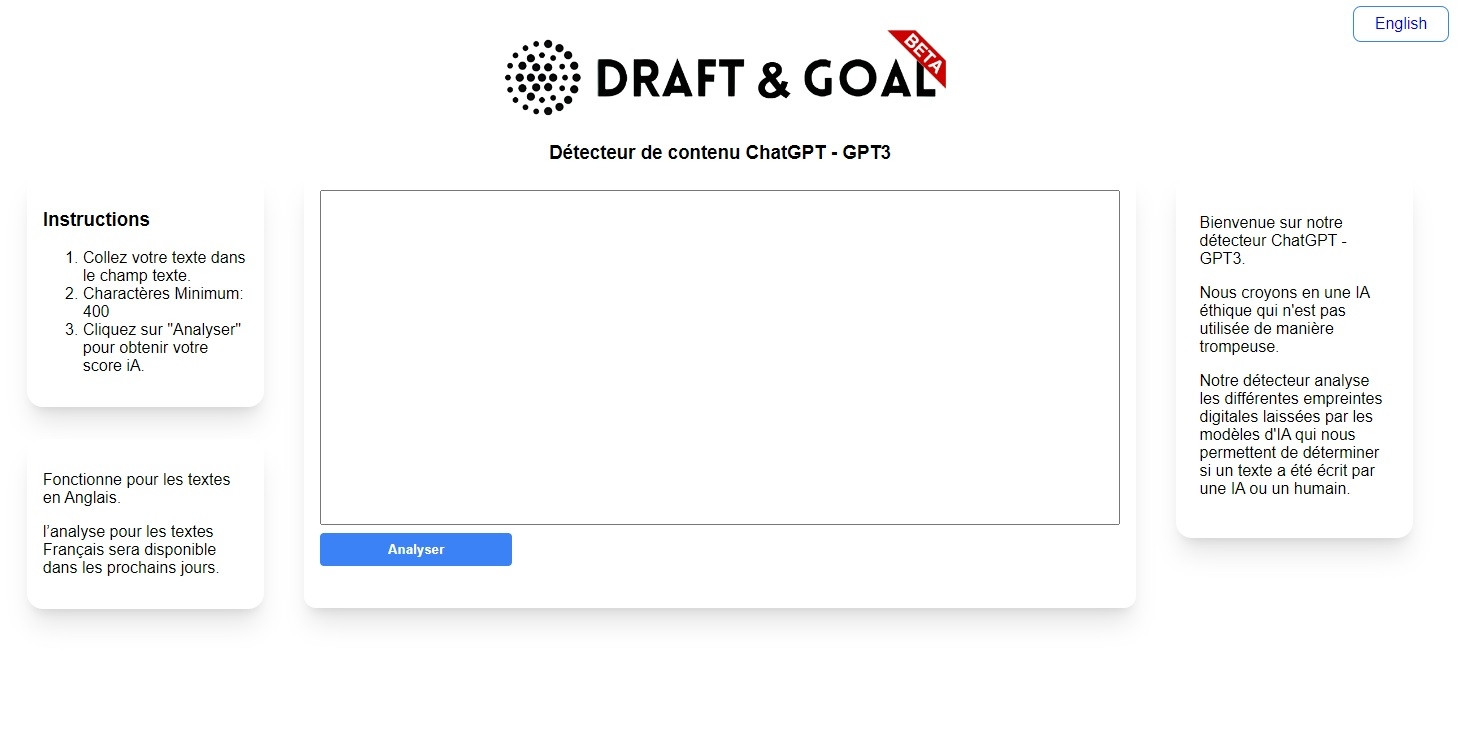

Un début de riposte est apparu avec un outil en ligne créé par la startup Draft & Goal et qui permet de détecter si un texte a été produit par ChatGPT. Son fonctionnement est très simple puisqu'il suffit de copier/coller un texte pour obtenir un score de 0 à 100%.

Plus il est proche de 100% et plus il est probable que le document a été produit via ChatGPT. Conçu pour "aider les enseignants en détresse", il offre une fiabilité de 93% sur les textes en anglais et sera bientôt disponible pour les textes en français, avec la même finesse de détection.

Seule réserve, le texte doit faire plus de 400 mots pour être analysable. Le directeur technique de Draft & Goal, Vincent Terrasi, explique au Figaro Etudiant que la qualité de détection varie en fonction du nombre de mots que l'étudiant aura modifié.

Des progrès à faire des deux côtés

Pour repérer des textes générés par ChatGPT, l'outil utilise les failles rédactionnelles de l'IA : beaucoup de répétitions et de tournures creuses qui donnent ce style assez impersonnel qui peut faire illusion au premier abord.

La marge d'erreur laisse le problème de faux positif (considérer un texte légitime comme produit par ChatGPT) en suspens pour le moment mais la startup estime que son système est plutôt fiable au regard du nombre de paramètres à considérer.

L'outil utilise aussi la faculté de l'IA d'affirmer que des choses totalement fausses sont vraies avec d'importants biais de raisonnement. OpenAI a déjà annoncé des évolutions pour son robot conversationnel et il reste à voir dans quelle mesure ces défauts de jeunesse détectables le seront encore dans de prochaines versions.

Cette capacité d'utiliser ChatGPT pour tricher est aussi une préoccupation pour son créateur OpenAI. La firme réfléchit à des solutions et notamment à des marqueurs invisibles qui permettraient de détecter si l'IA est à l'origine d'un texte. Là encore, il semble que cela ne pourra fonctionner que sur des textes modérément longs.