Google Cloud lance sa 7e génération de puces TPU (Tensor Processing Unit), Ironwood, et ses nouveaux CPU Arm Axion. Cette offensive hardware vise à dominer l'ère de l'inférence.

La course à l'infrastructure IA entre dans une nouvelle phase. Pendant des années, l'industrie s'est concentrée sur l'entraînement de modèles toujours plus grands, un domaine largement dominé par les GPU de Nvidia.

Aujourd'hui, le véritable enjeu économique se déplace vers l'âge de l'inférence : la capacité à servir ces modèles à des milliards d'utilisateurs de manière fiable, rapide et économique.

C'est dans ce contexte que Google dégaine son portefeuille de silicium customisé. Comme nombre de géants high-tech, la firme ne veut pas s'appuyer uniquement sur des composants tiers mais elle cherche à maîtriser toute la chaîne, du design de la puce au logiciel, pour optimiser les performances et les coûts.

Ironwood : la puissance de feu de l'IA Hypercomputer

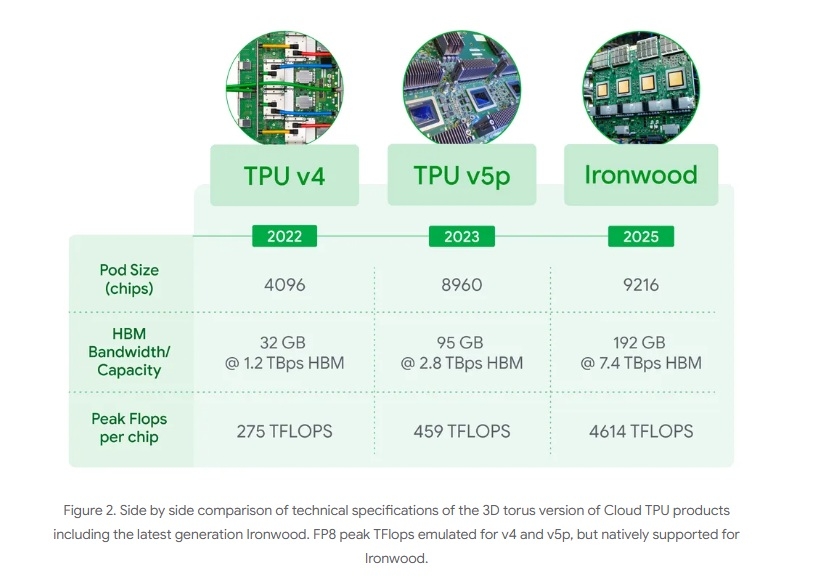

Le TPU Ironwood ofre des performances multipliées par quatre par rapport à la génération précédente, tant pour l'entraînement que pour l'inférence. Mais la véritable innovation réside dans l'échelle.

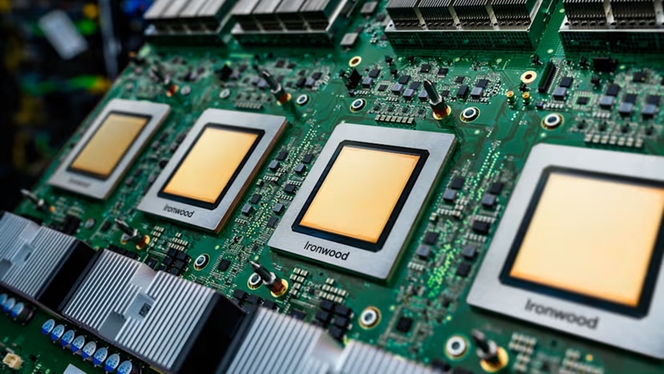

Un seul "pod" Ironwood peut connecter jusqu'à 9 216 puces individuelles, fonctionnant comme un supercalculateur unifié. Ces puces partagent 1,77 pétaoctets de mémoire rapide HBM (High Bandwidth Memory) grâce à une interconnexion propriétaire ultra-rapide (9,6 Tbps).

Pour garantir une fiabilité proche de 99.999%, Google utilise une technologie de commutation de circuit optique (OCS) qui redirige le trafic en millisecondes en cas de défaillance matérielle.

Le pari d'Anthropic : un million de TPU

La validation la plus spectaculaire de cette stratégie ne vient pas de Google, mais de l'un de ses principaux clients : Anthropic. L'entreprise derrière la famille de modèles Claude s'est engagée à accéder à un million de puces TPU Ironwood.

Ce contrat, estimé à plusieurs dizaines de milliards de dollars, est l'un des plus importants jamais signés dans le cloud. Krishna Rao, CFO d'Anthropic, justifie ce choix par "le rapport prix-performance et l'efficacité" des TPU pour répondre à la "demande en croissance exponentielle" de leurs clients.

Cet accord fournit à Anthropic une capacité de "bien plus d'un gigawatt" d'ici 2026, soit la consommation d'une petite ville, dédiée à l'inférence de ses modèles.

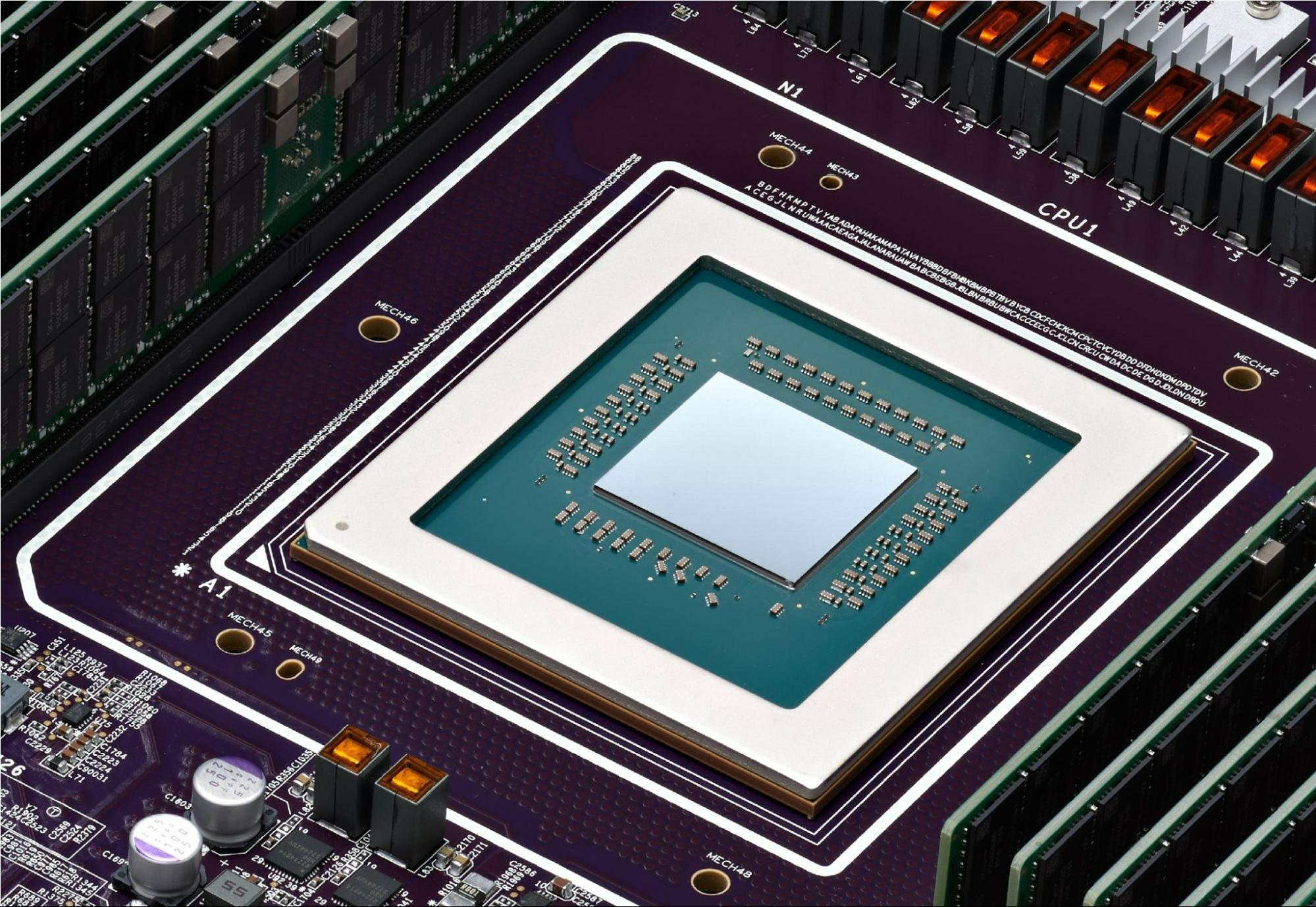

Axion, le complément indispensable du silicium

L'IA s'appuie sur des accélérateurs spécialisés mais aussi sur les microservices et la préparation des données, Google déploie aussi ses propres processeurs généralistes basés sur l'architecture Arm : la famille Axion.

Google lance ainsi les instances N4A (en preview) et C4A (disponibilité générale). La société affirme que ses puces Axion offrent des performances jusqu'à 30% supérieures aux instances Arm concurrentes dans le cloud et un rapport prix-performance jusqu'à 60% meilleur que les puces x86 comparables, selon les tests de clients comme ZoomInfo.

En combinant Ironwood (pour le calcul lourd) et Axion (pour le reste de la stack applicative), Google propose une infrastructure verticalement intégrée, son "AI Hypercomputer". Si la domination de Nvidia sur le marché reste écrasante, la bataille pour l'infrastructure de l'inférence, elle, ne fait que commencer.