Le monde de la cybersécurité fait face à une inflexion stratégique majeure. Si l'utilisation de l'intelligence artificielle par les cybercriminels n'est pas nouvelle, elle se cantonnait jusqu'ici principalement à des tâches préparatoires : génération d'emails de phishing convaincants, reconnaissance de cibles ou encore aide au développement de code. Mais les dernières découvertes de Google montrent une évolution inquiétante.

Les attaquants, qu'ils soient étatiques ou criminels, exploitent désormais les grands modèles de langage (LLM) non plus seulement comme des outils de productivité, mais comme des composants actifs de leurs malwares, directement déployés dans leurs opérations.

PROMPTFLUX, le malware qui "pense"

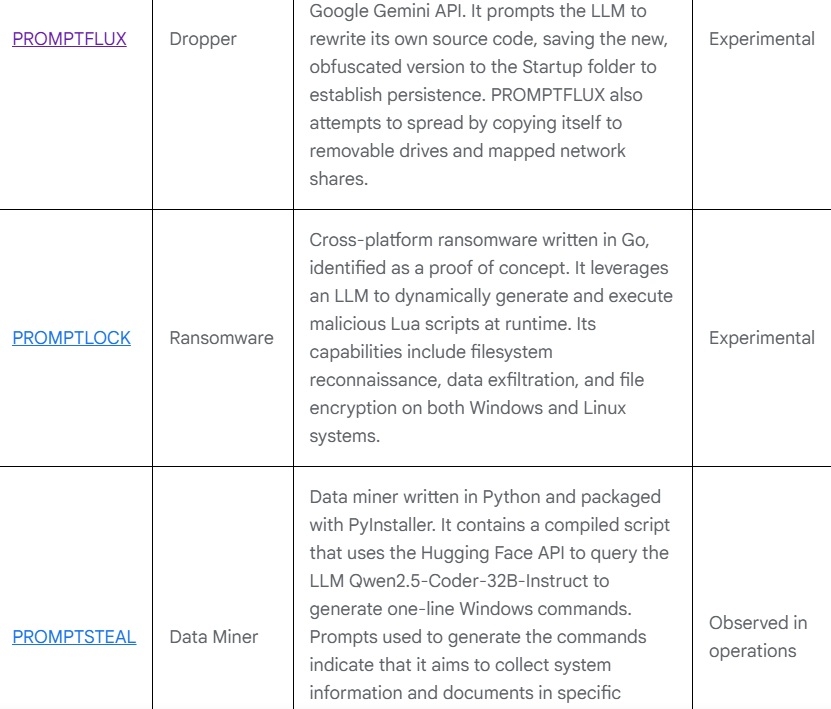

L'exemple le plus frappant identifié par Google est un malware expérimental nommé PROMPTFLUX. Écrit en VBScript, ce dernier se distingue par son module baptisé "Thinking Robot" (le robot pensant). Sa particularité : il interagit directement avec l'API de Gemini, le modèle d'IA de Google.

Grâce à une clé API codée en dur, PROMPTFLUX envoie périodiquement des requêtes très spécifiques au LLM. Il lui demande de lui fournir de nouvelles techniques d'obfuscation et d'évasion en VBScript.

En clair, le malware utilise Gemini pour réécrire son propre code source, parfois toutes les heures, afin de se transformer en permanence pour échapper aux détections.

Cette capacité d'auto-modification "juste-à-temps" (just-in-time) lui permet de changer constamment d'apparence pour déjouer les détections antivirus traditionnelles, souvent basées sur des signatures statiques.

Bien que PROMPTFLUX semble être encore en phase de test, l'intention des développeurs est claire : créer un script capable d'évoluer de manière autonome.

Des groupes étatiques déjà à la manœuvre

PROMPTFLUX n'est pas un cas isolé. Le rapport du GTIG détaille d'autres familles de malwares qui empruntent la même voie.

PROMPTSTEAL (ou LameHug), par exemple, a été utilisé par le groupe russe APT28 contre des cibles en Ukraine. Il interroge des modèles open-source sur Hugging Face pour générer à la volée des commandes Windows servant à récolter des fichiers et des données système.

L'abus des modèles d'IA par des acteurs étatiques est généralisé. Des groupes liés à la Corée du Nord (MASAN, PUKCHONG) ont utilisé Gemini pour des campagnes de vol de cryptomonnaies et le développement d'exploits.

Des acteurs iraniens (APT42, MUDDYCOAST) s'en sont servis pour du phishing, mais aussi pour déboguer leurs propres malwares.

Ironiquement, le groupe MUDDYCOAST a accidentellement révélé sa propre infrastructure de commande et de contrôle (C2) en tentant de déboguer un script malveillant avec Gemini, permettant à Google de démanteler ses opérations.

Vers une industrialisation de la menace

Au-delà de ces usages étatiques, c'est l'ensemble de l'économie souterraine du cybercrime qui s'adapte. Les chercheurs de Google ont constaté une maturation rapide du marché des outils de piratage basés sur l'IA, vendus sur des forums anglophones et russophones.

Ces "services" sont souvent proposés via des modèles d'abonnement, similaires aux offres SaaS légitimes. Ils abaissent considérablement le coût d'entrée et la barrière technique pour lancer des attaques sophistiquées, allant de la création de deepfakes au développement automatisé de malwares.

Face à cette menace grandissante, Google affirme avoir désactivé les comptes liés à ces activités et renforcé ses modèles. L'entreprise met en avant son framework SAIF (Secure AI Framework) comme un guide éthique et technique pour sécuriser le cycle de vie de l'IA.

Reste à savoir si ces défenses tiendront face à des adversaires qui, désormais, apprennent et s'adaptent aussi vite que les modèles qu'ils détournent.