La suprématie quantique, c'est cette capacité à venir des ordinateurs quantiques à pouvoir réaliser dans des délais raisonnables des calculs qui prendraient un temps extrêmement long avec l'informatique traditionnelle.

Cela implique d'utiliser des processeurs quantiques farcis de qubits selon différentes approches. L'une des voies de recherche porte sur des qubits supraconducteurs pouvant être placés en état de superposition quantique.

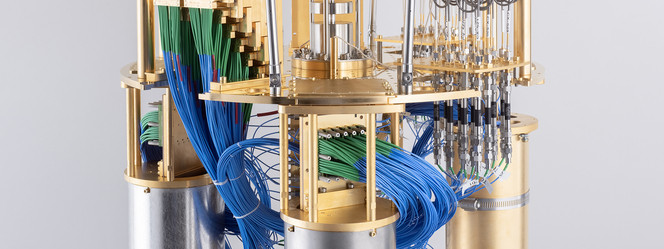

Le problème est que, outre la complexe machinerie nécessaire pour assurer leur fonctionnement à très basse température et la technique de contrôle et de traitement de ses qubits, l'état de superposition quantique est très sensible à la moindre perturbation et génère des erreurs qui impactent la précision du résultat final.

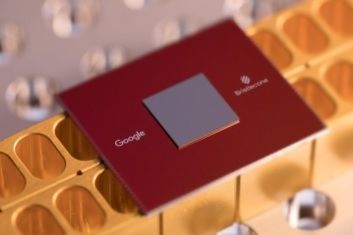

Google Bristlecone

Le nombre de qubits d'un système ne suffit donc pas à définir ses performances et sa qualité. En 2019, Google avait affirmé avoir atteint la suprématie quantique avec sa puce Bristlecone de 72 qubits mais la nouvelle avait été accueillie avec suspicion et il avait été démontré que le résultat pouvait être obtenu en informatique traditionnelle.

Pas encore la suprématie quantique mais IBM s'en rapproche

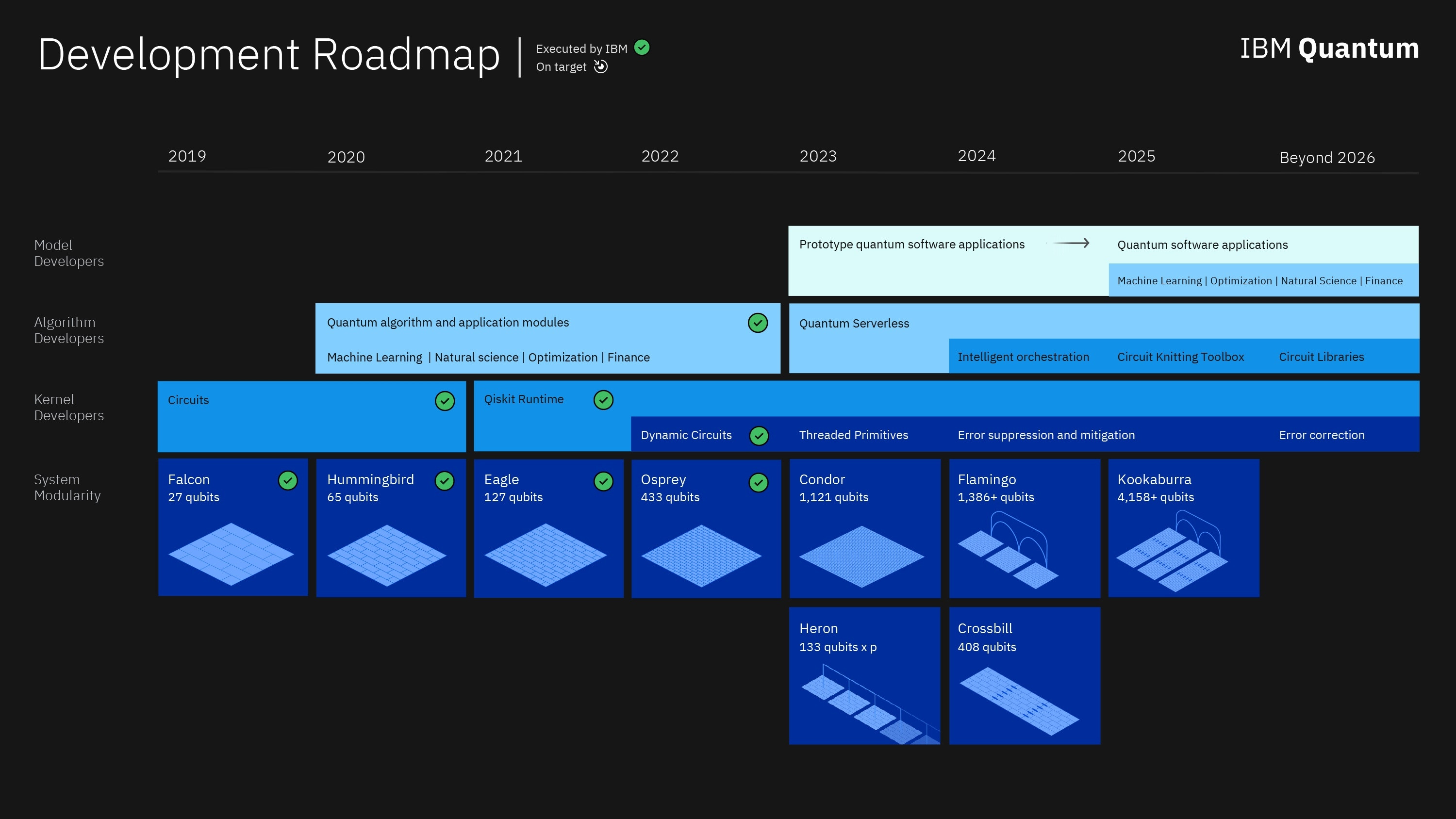

La quête pour la suprématie quantique serait donc toujours d'actualité et IBM espère faire partie des premiers (sinon d'en être l'initiateur) à pouvoir la revendiquer. La firme, qui travaille depuis plusieurs années sur différents processeurs quantiques, avait annoncé en 2021 un processeur quantique Eagle susceptible d'y parvenir.

Ces derniers jours, IBM a résumé ses travaux dans un article de Nature en affirmant avoir trouvé le moyen de se rapprocher de la suprématie quantique avec des systèmes de plus de 100 qubits.

En utilisant le processeur quantique Eagle doté de 127 qubits et un système de correction d'erreurs amélioré capable de réduire le bruit quantique si fatal à la précision du résultat final, ils ont démontré que leur modèle quantique était plus apte à simuler l'état magnétique d'un solide en deux dimensions que les résultats obtenus en informatique classique via le Lawrence Berley National Lab à mesure que la modélisation se complexifiait.

Une solide roadmap pour progresser dans le quantique

La réduction de bruit a été permise par l'étude fine des imperfections des qubits, jusque dans leur production, de manière à identifier les causes prévisibles de leur désynchronisation et proposer un système de réduction des erreurs en amont, distinct de la correction d'erreur habituellement utilisée.

Ce n'est pas encore la suprématie quantique démontrant la supériorité totale des systèmes quantiques dans certains types de problèmes mais c'est une première étape en ce sens sur des systèmes simplifiés pour lesquels l'informatique classique commence à peiner.

IBM imagine déjà que cette étape symbolique pourrait être atteinte d'ici deux ans pour des problèmes plus complexes hors de portée des supercalculateurs actuels. La puce quantique Eagle n'est d'ailleurs qu'une étape intermédiaire. IBM a déjà commencé à évoquer une puce Osprey de 433 qubits et une puce Condor de 1121 qubits qui doit être dévoilée plus tard dans l'année, suivie par la suite de Flamingo (1386 qubits) puis Kookaburra (4158 qubits).