La présentation de la puce Rubin CPX par Nvidia lors de l'événement AI Infra Summit sonne comme un bouleversement pour l’intelligence artificielle appliquée aux longs contextes.

Conçue pour traiter des millions de tokens — qu’il s’agisse de texte, de vidéos ou d’audio — la puce promet d’accélérer radicalement le développement des IA génératives.

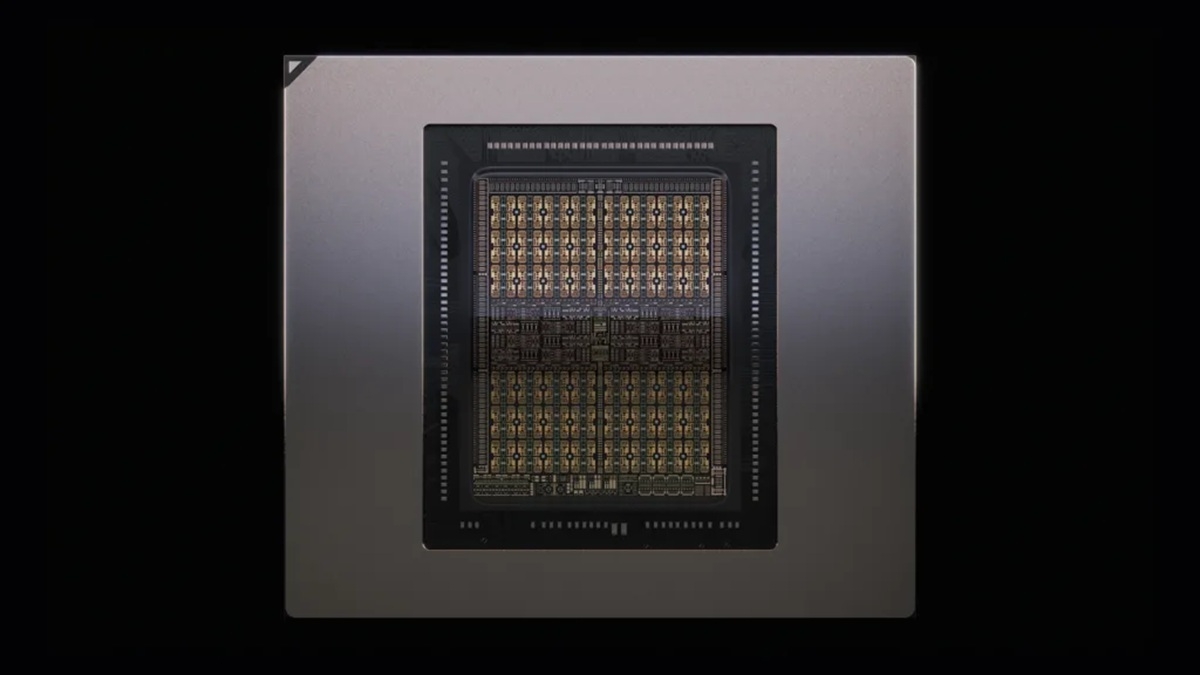

Elle exploite l'architecture graphique Rubin qui doit prendre la succession de l'actuelle Blackwell / Blackwell Ultra avec des optimisations et des fonctionnalités spécifiquement pensées pour l'IA et devant permettre à Nvidia de conserver son leadership dans le secteur.

Une architecture dédiée aux contextes étendus

Nvidia a conçu Rubin CPX pour surmonter le principal obstacle des modèles algorithmiques massifs. Selon Jensen Huang, CEO de Nvidia, cette puce « est le premier GPU CUDA taillé pour l’IA de contexte étendu, où les modèles raisonnent sur des millions de tokens simultanément ».

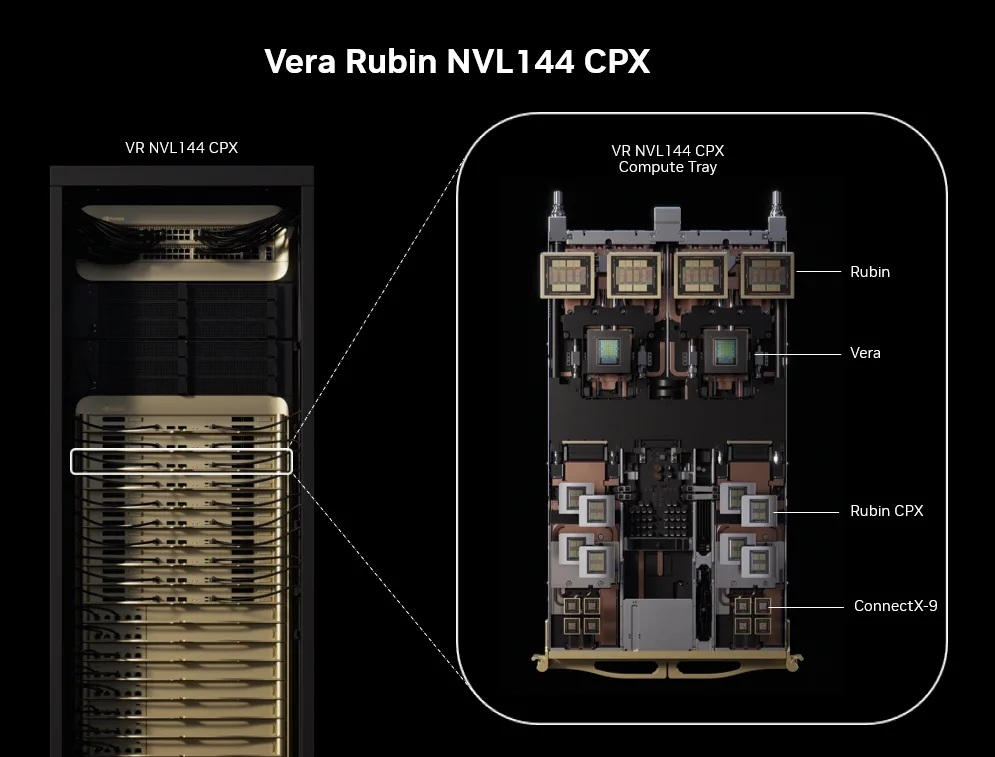

Grâce à son design monolithique et à une mémoire GDDR7 de 128 Go, Rubin CPX propose une bande passante de 1,7 pétaoctet par seconde dans sa version rack Vera Rubin NVL144 CPX, éliminant ainsi les goulets d’étranglement des générations précédentes.

C’est un jalon qui ouvre la porte à une exploitation de modèles multimodaux et long format, sans perte de vitesse ni dégradation de la performance.

30 pétaflops de puissance, 3 fois plus rapide

La force du Rubin CPX tient à son puissance de calcul : jusqu’à 30 pétaflops en précision NVFP4. Cette performance le place nettement au-dessus des précédentes références Nvidia, notamment le système Grace Blackwell BG300 NVL72.

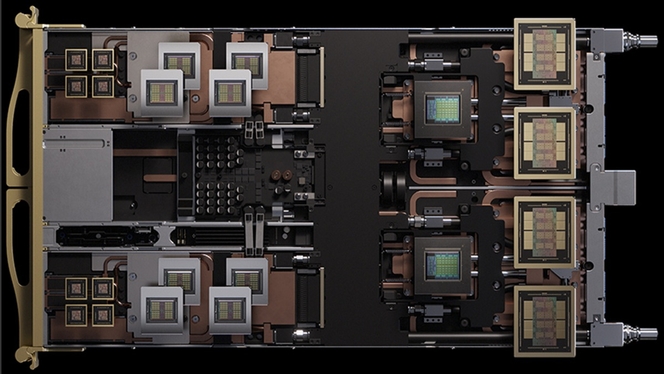

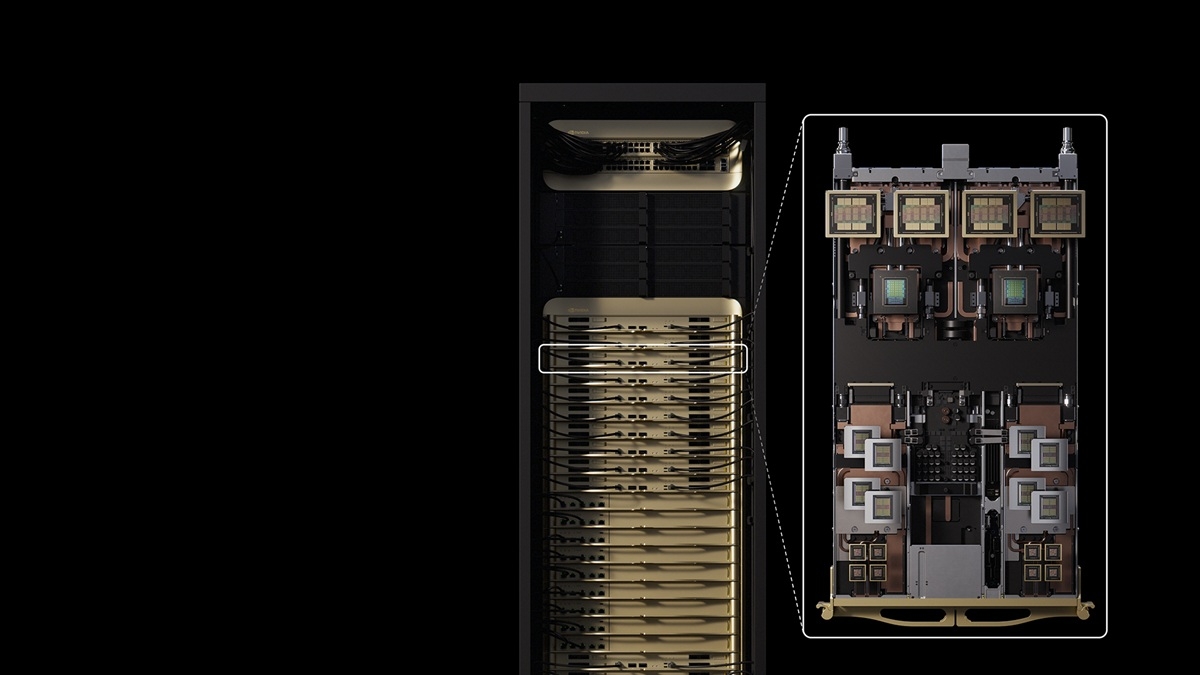

Dans la plateforme Vera Rubin NVL144 CPX (144 GPU et 36 CPU ARM Vera, successeurs de Grace), les capacités d’inférence sont portées à 8 exaflops, soit une augmentation de 7,5 fois par rapport aux générations Blackwell.

Le GPU intègre aussi quatre unités NVENC / NVDEC qui accélèrent l’encodage et le décodage vidéo en temps réel, une avancée décisive pour le secteur de la création visuelle automatisée.

Des usages pointus, une monétisation sans précédent

Avec Rubin CPX, Nvidia cible avant tout les entreprises du cloud public et les spécialistes de l’IA générative. Le GPU se démarque sur le traitement d’applications lourdes telles que la génération vidéo, l’analyse sémantique avancée ou l’édition logicielle sur de vastes corpus.

« Le système Vera Rubin NVL144 CPX peut générer 5 milliards de dollars de chiffre d’affaires IA tous les 100 millions de dollars investis » affirme Nvidia. Les modèles ouverts Nvidia Nemotron, proposés en version Nano (embarqué), Super (simple GPU) ou Ultra (data center), facilitent la création d’agents intelligents ultra-compétents.

Cette promesse de rentabilité explique l’intérêt marqué de sociétés comme Cursor, Runway ou Magic, déjà prêtes à déployer le GPU dans leurs solutions de développement logiciel ou de génération de contenu vidéo.

De la limitation à la démocratisation du calcul intensif

La sortie prévue en fin d’année 2026 du GPU Rubin CPX soulève aussi des questions sur la démocratisation du calcul intensif dans l’inférence IA. Le GPU est pensé pour s’intégrer dans les plateformes existantes par l’ajout d’un « compute tray » dédié, réduisant les coûts de migration pour les entreprises dotées de matériel Vera Rubin NVL144.

À terme, le CPX pourrait s’imposer comme la nouvelle référence pour toutes les tâches exigeant une mémoire persistante sur de longues interactions (analyse de code, montage vidéo, recherche sémantique avancée).

Cette avancée technique veut faciliter la mutation des systèmes traditionnels vers des infrastructures capables de traiter des contextes toujours plus longs et plus complexes.