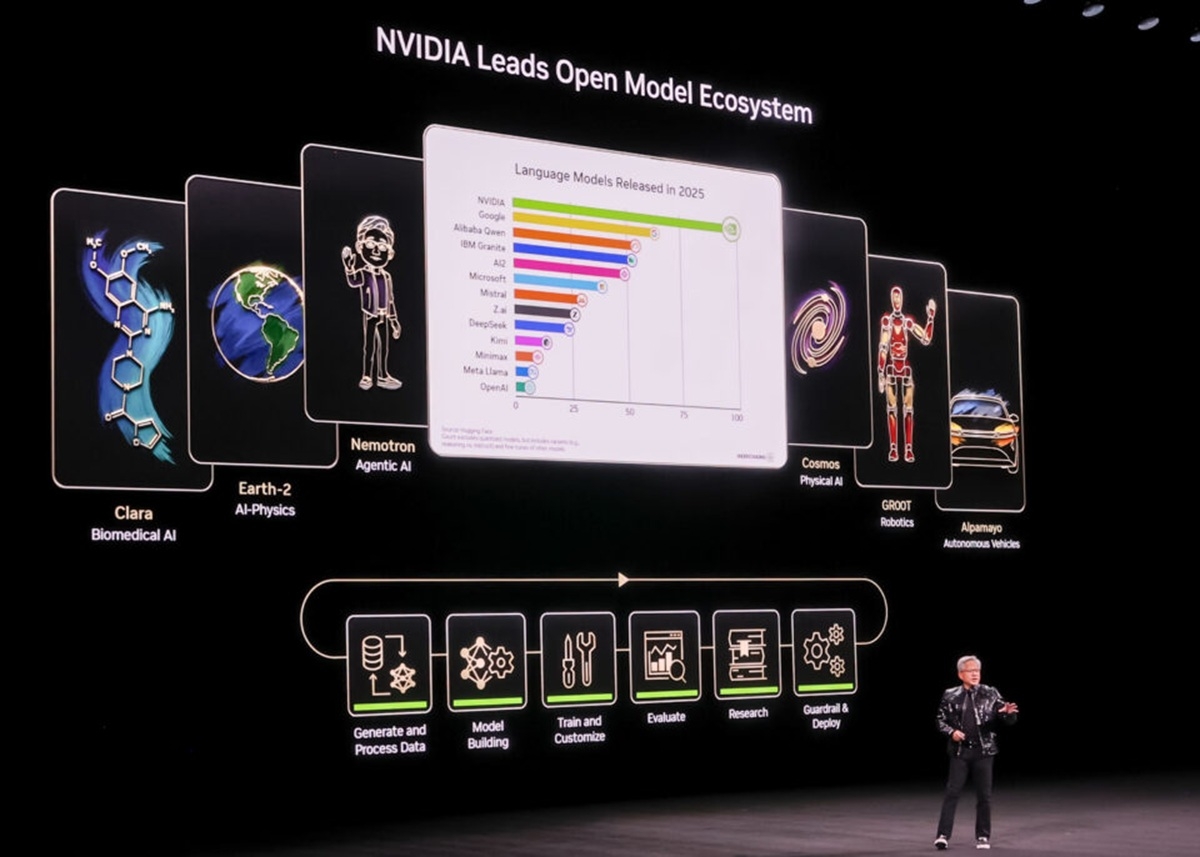

Dans un marché de l'intelligence artificielle où la demande en puissance de calcul ne cesse de croître, chaque nouvelle génération de matériel est scrutée avec une attention extrême.

Jusqu'à présent, la famille de puces Blackwell a solidement assis la domination de Nvidia, mais l'horizon concurrentiel se densifie, poussant le géant des semi-conducteurs à anticiper et à préparer le terrain pour sa prochaine offensive.

C'est dans ce contexte que s'inscrit l'annonce de la plateforme Vera Rubin, une architecture conçue pour répondre aux défis des modèles de langage de plus en plus complexes et gourmands en ressources, tout en tentant de garder une longueur d'avance sur des rivaux comme AMD et les initiatives internes de ses propres clients.

Le décor est planté pour une nouvelle étape dans la course à la suprématie des centres de données IA.

Une architecture pensée pour l'échelle et la performance

La plateforme Vera Rubin est un écosystème matériel et logiciel complet. Sa pierre angulaire est le rack NVL72, qui intègre de manière co-optimisée pas moins de six types de puces distinctes : le CPU ARM Vera, le GPU Rubin, le commutateur NVLink 6, la SuperNIC ConnectX-9, l'unité de traitement de données BlueField-4 et le commutateur Ethernet Spectrum-6.

Cette approche systémique vise à éliminer les goulots d'étranglement traditionnels en assurant une communication ultra-rapide et cohérente entre tous les éléments.

Les promesses de performance sont vertigineuses. Nvidia annonce des capacités en inférence jusqu'à cinq fois supérieures à celles de la génération Blackwell, et une multiplication par 3,5 pour les tâches d'entraînement.

Mais le chiffre qui retient le plus l'attention est la réduction annoncée de 10 fois du coût par token généré, un enjeu crucial pour la viabilité économique des modèles MoE (Mixture of Experts).

Cette avancée est le fruit d'une optimisation à tous les niveaux, de la bande passante mémoire HBM4 à l'efficacité des cœurs Tensor de nouvelle génération.

Plus qu'une puce, un écosystème complet

Pour atteindre de tels gains, le fabricant a introduit des innovations logicielles et architecturales majeures. L'une des plus notables est l' adaptive compression, une technique qui agit comme une forme de sparsité intelligente, permettant d'accélérer les calculs sans impacter la précision des résultats, particulièrement pour l'inférence.

Cette technologie est un pilier de la nouvelle fonctionnalité Transformer Engine intégrée aux GPU Rubin. Le géant vert met également l'accent sur la gestion du contexte, qui devient un facteur limitant majeur à mesure que les interactions avec les IA se complexifient.

En effet, Nvidia a bien compris que la performance brute ne suffit plus. La nouvelle architecture intègre un système de stockage de contexte (KV cache) optimisé, utilisant les DPU BlueField-4 pour décharger les GPU de cette tâche et leur permettre de se concentrer sur la génération de tokens.

La fiabilité des racks a aussi été améliorée, avec des fonctionnalités de maintenance automatisée permettant des diagnostics ou des remplacements de composants sans mettre l'ensemble du système hors ligne, un atout majeur pour les opérateurs de datacenters.

Quel avenir dans un marché en pleine mutation ?

La production de la plateforme Vera Rubin a déjà commencé et les premières livraisons sont attendues pour le second semestre 2026.

Les premiers à en bénéficier seront, sans surprise, les principaux fournisseurs de cloud comme AWS, Google Cloud et Microsoft Azure, qui sont à la fois les plus gros clients et certains des concurrents les plus sérieux de Nvidia.

Cette annonce précoce s'apparente à une manœuvre stratégique visant à sécuriser leur feuille de route technologique, face à une concurrence de plus en plus agressive, notamment celle d'AMD et de ses solutions Helios.

L'évolution rapide du marché pousse tous les acteurs à regarder encore plus loin. Nvidia a déjà esquissé les contours de la suite avec la génération Rubin Ultra, prévue pour 2027, qui promet de nouvelles avancées spectaculaires.

Cependant, cette course effrénée à la performance soulève une question de fond : celle de la consommation énergétique. Avec des racks qui pourraient atteindre plusieurs centaines de kilowatts, la gestion thermique et l'efficacité énergétique deviennent le prochain défi majeur pour l'ensemble de l'industrie.