Nvidia annonce que ses chercheurs ont développé un système basé sur du deep learning capable de proposer des vidéos en slow motion de haute qualité à partir de vidéos capturées à 30 images par seconde.

En s'appuyant sur des GPU Tesla V100 et le framework de deep learning PyTorch tirant parti de l'accélération GPU (CUDA Deep Neural Network de Nvidia), le système a été entraîné avec plus de 11 000 vidéos d'activités quotidiennes et sportives filmées nativement à 240 images par seconde.

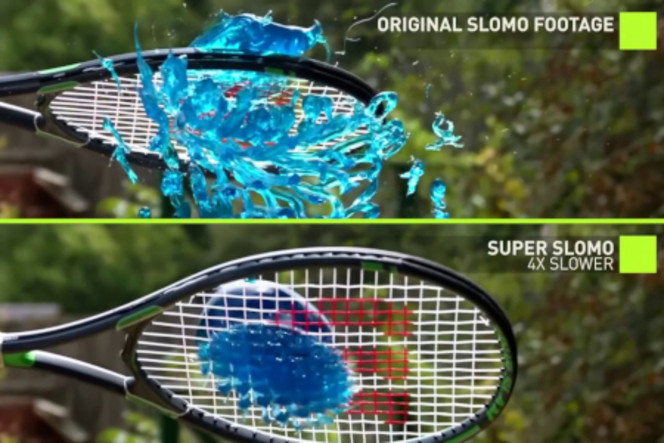

Nvidia explique qu'une fois entraîné, un réseau de neurones à convolution est capable de prédire les images supplémentaires. Autrement dit, pour une vidéo à 30 images par seconde, il est en mesure de prédire à quoi devraient ressembler les 210 images intermédiaires entre deux images pour obtenir un ralenti à 240 images par seconde.

Un jeu de données distinct a été utilisé pour valider l'exactitude du système et sa cohérence pour générer des images intermédiaires. Un même résultat peut être obtenu avec une vidéo à 60 images par seconde pour obtenir un ralenti à 480 images par seconde.

Pour le moment, il ne s'agit toutefois que d'un travail de recherche, et il n'est pas question d'une quelconque forme de commercialisation. Le cas échéant, on peut imaginer que le traitement s'effectuera essentiellement dans le cloud.