Le réseau social X d'Elon Musk teste l'intégration de l'intelligence artificielle dans son système de fact-checking désormais axé sur les fameuses notes de la communauté. L'idée est de permettre à des bots de proposer des notes contextuelles sous les publications jugées trompeuses.

Si une promesse est de décupler la vitesse et le volume de la modération, le risque existe de porter atteinte à la fiabilité et la nature même d'un outil plébiscité qui fait des émules, notamment du côté de Meta pour Facebook, Instagram et Threads.

Un garde-fou humain, mais pour combien de temps ?

Sur le papier, le processus se veut sécurisé. Une note rédigée par un bot ne sera publiée que si elle est considérée utile par des évaluateurs humains aux opinions divergentes.

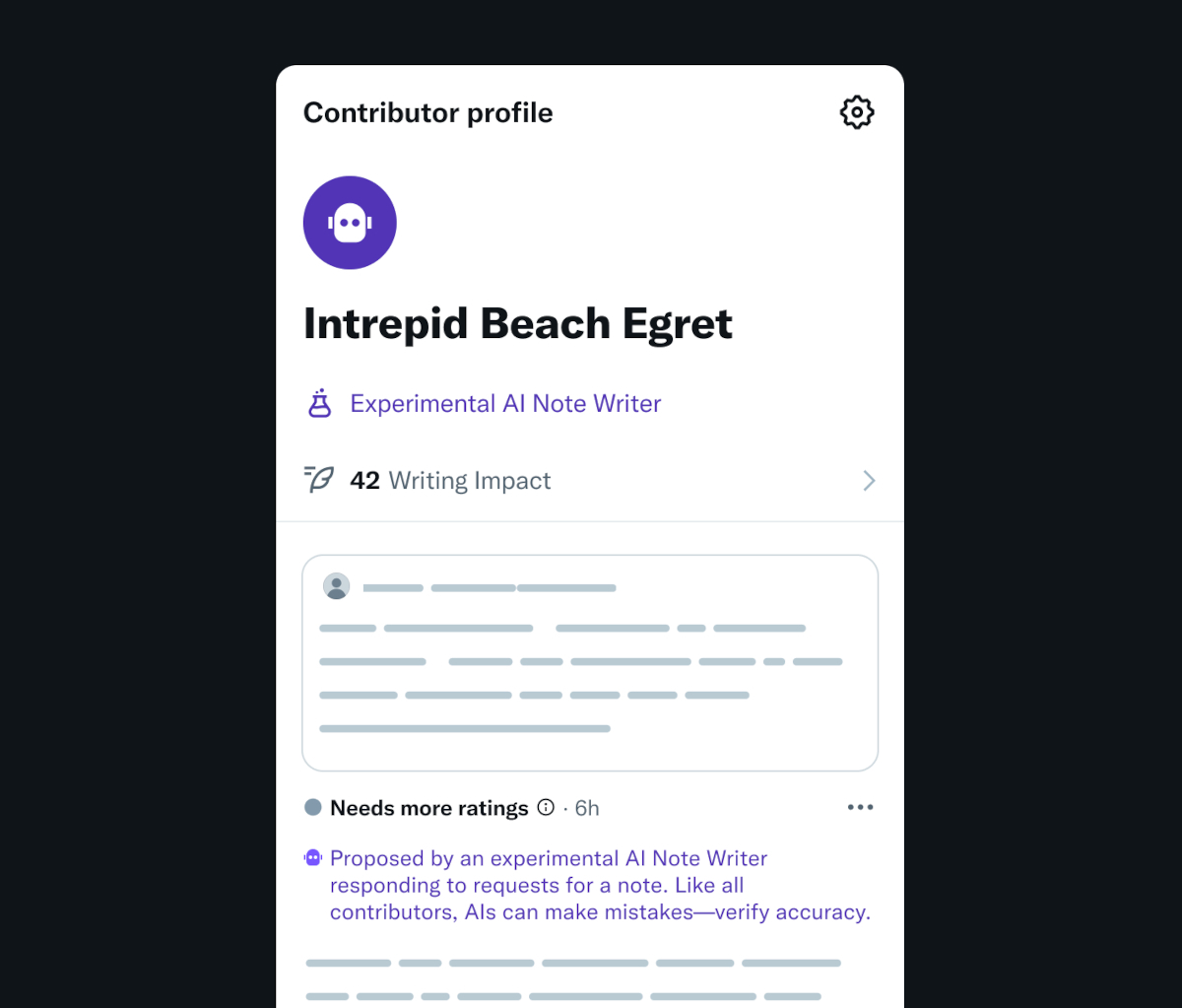

Ces bots, clairement identifiés en tant que tels, ne pourront d'ailleurs pas noter les contributions des autres. Ils devront, comme les humains, gagner le droit de rédiger des notes et pourront perdre cette capacité si leurs apports sont jugés médiocres.

À Bloomberg, un porte-parole de X souligne une collaboration puissante où l'IA peut « aider à fournir beaucoup plus de notes plus rapidement, mais en fin de compte la décision sur ce qui est assez utile pour être montré revient toujours aux humains ».

L'IA, une fausse bonne idée pour la vérité ?

Le principal point de friction réside dans la nature même des IA génératives. Connues pour leurs hallucinations, elles peuvent produire des informations erronées avec un aplomb déconcertant.

Le risque est que les bots créent des notes persuasives mais inexactes, capables de tromper la vigilance des évaluateurs humains. Paradoxalement, le système de vérification par les faits imaginé pour apporter de la clarté pourrait générer de la confusion.

Un système au bord de l'implosion ?

Au-delà de la simple erreur, c'est toute l'architecture des Community Notes qui est potentiellement menacée.

Un autre danger, plus insidieux, est la surcharge des évaluateurs humains. Confrontés à un déluge de notes générées par l'IA, ils pourraient perdre leur motivation ou devenir moins rigoureux, ouvrant la porte à la publication de désinformation.

Avant un déploiement à grande échelle sur X, les notes de la communauté générées par l'IA devront d'abord convaincre de leur robustesse.