Au début de ce mois de mars, Google annonçait le déploiement de Lens auprès du plus grand nombre. Son logiciel, resté exclusif aux smartphones Pixel pendant de nombreux mois se retrouvait ainsi accessible à tout terminal sous Android.

Starting today and rolling out over the next week, those of you on iOS can try the preview of Google Lens to quickly take action from a photo or discover more about the world around you. Make sure you have the latest version (3.15) of the app.https://t.co/Ni6MwEh1bu pic.twitter.com/UyIkwAP3i9

— Google Photos (@googlephotos) 15 mars 2018

Aujourd'hui, ce sont les utilisateurs d'iPhone et iPad qui peuvent désormais bénéficier de la fonctionnalité au sein de Google Photos qui analyse les images pour proposer des informations et interactions avec l'utilisateur.

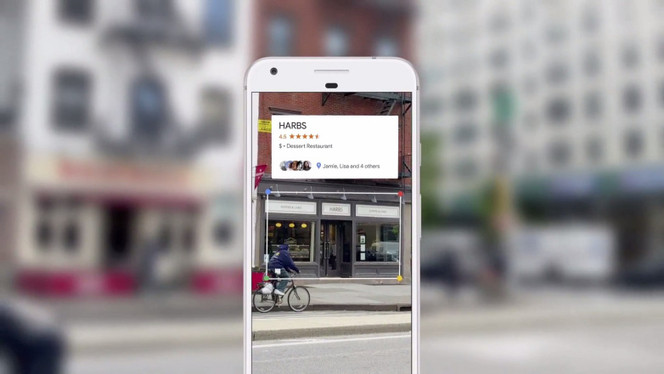

Lens profite ainsi du machine learning et d'un algorithme d'intelligence artificielle qui permet de "comprendre" les images qu'on lui propose et qui exploite le web à la recherche d'informations diverses en rapport avec le contenu du cliché.

Le module est ainsi capable d'identifier un monument, un restaurant, un musée, une oeuvre d'art, une rue, un véhicule, des animaux et donner toute sorte d'informations à leur sujet : horaires d'ouverture, géolocalisation, historique... Une photo d'une affiche de cinéma donnera les horaires de projection et le descriptif du film par exemple.

Malheureusement, il apparait toujours que la fonctionnalité n’est compatible qu'avec les terminaux dont la langue par défaut est configurée sur anglais, sous iOS comme sur Android... Le déploiement est, comme sous Android, progressif, il faudra donc certainement attendre quelques jours pour profiter de la fonctionnalité.