Le groupe Samsung a eu une nouvelle idée pour faire progresser ses composants mémoire destinés aux serveurs et datacenters : ajouter une capacité de traitement d'intelligence artificielle dans ses mémoires HBM (High Bandwith Memory).

Cela donne la mémoire HBM-PIM (PIM pour Processing in Memory), une première industrielle qui veut répondre aux problèmes de déplacements de larges volumes de données pour les besoins de l'IA en matière de deep learning et d'inférence.

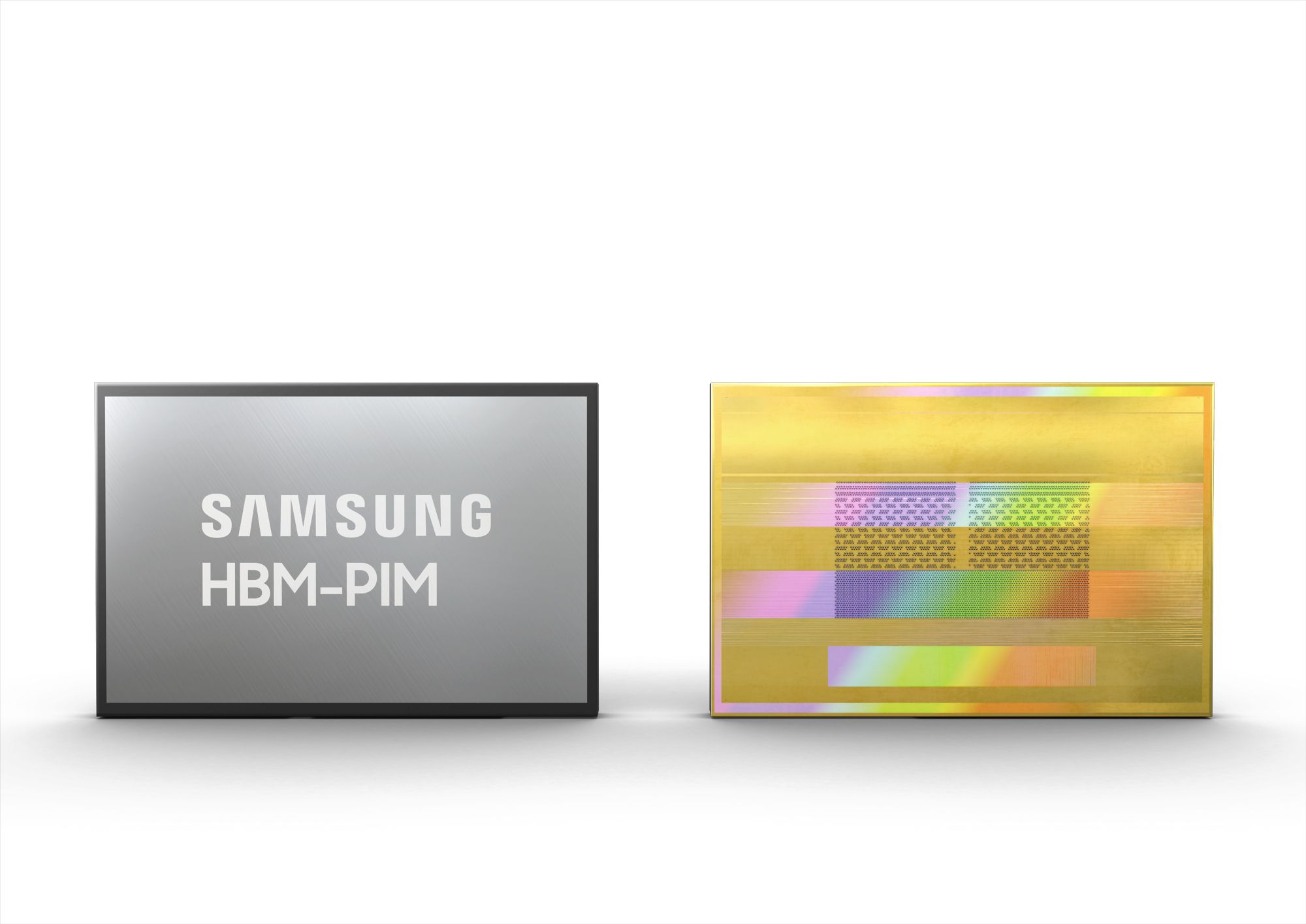

Plutôt que de faire aller et venir des données entre processeurs et mémoire, le composant HBM-PIM dispose d'une capacité de calcul directement au niveau de la mémoire, réduisant les déplacements de données et optimisant les performances des systèmes.

Appliquée à sa mémoire HBM2 Aquabolt, cette solution permet un doublement des performances avec une consommation d'énergie réduite de 70%, annonce le groupe coréen.

La HBM-PIM fonctionne comme la HBM2 et utilise les mêmes contrôleurs mais l'installation de la partie PIM prend un peu de place sur les stacks, réduisant légèrement la capacité mémoire, ce qui donne des composants de 6 Go (au lieu de 8 Go) composés de FIMDRAM (Function in Memory DRAM).

Cela fournit tout de même une capacité de calcul jusqu'à 1,2 TFlops. Pour le moment, les usages sont uniquement tournés vers de grands systèmes de type HPC et supercalculateurs où des solutions HBM-PIM sont actuellement à l'essai. En attendant des applications plus grand public ?