Face à une sécheresse persistante, le gouverneur de Californie Gavin Newsom a mis son véto à une loi qui visait à obliger les data centers à déclarer leur consommation d'eau.

Une décision qui place le développement effréné de l'intelligence artificielle au-dessus de la transparence sur la gestion d'une ressource vitale et de plus en plus rare.

Le gouverneur Gavin Newsom a officiellement opposé son véto au projet de loi connu sous le nom d'Assembly Bill 93. Cette législation aurait contraint les nouveaux centres de données à fournir une estimation de leur consommation d'eau pour obtenir une licence d'exploitation, et les centres existants à publier un rapport annuel sur leur usage réel pour la renouveler. Une mesure de bon sens dans un État où la gestion de l'eau est un enjeu de sécurité nationale.

Un arbitrage en faveur du boom technologique

Dans sa lettre justifiant son refus, Gavin Newsom a été clair : il se dit "réticent à imposer des exigences de déclaration rigides sur les détails opérationnels de ce secteur".

La raison principale est la course mondiale à l'intelligence artificielle, qui provoque une demande sans précédent pour les infrastructures de calcul. Pour le gouverneur, la Californie, en tant qu'"épicentre mondial du secteur technologique", doit soutenir ce développement sans entraves.

Cette position fait écho aux arguments de groupes de pression qui s'opposaient au projet de loi. La crainte sous-jacente est de freiner un boom économique majeur, alors que les dépenses en infrastructures pour l'IA pourraient atteindre 600 milliards de dollars dès 2025, selon Nvidia, acteur majeur du secteur.

En protégeant le secret des affaires, la Californie espère conserver son attractivité pour ces investissements colossaux, quitte à laisser une zone d'ombre sur leur impact environnemental.

Le paradoxe d'une politique de l'eau à deux vitesses

Le véto de Newsom crée une situation paradoxale. D'un côté, l'État intensifie la lutte contre le gaspillage, allant jusqu'à signer une autre loi (SB 394) pour augmenter drastiquement les amendes contre le vol d'eau sur les bouches d'incendie.

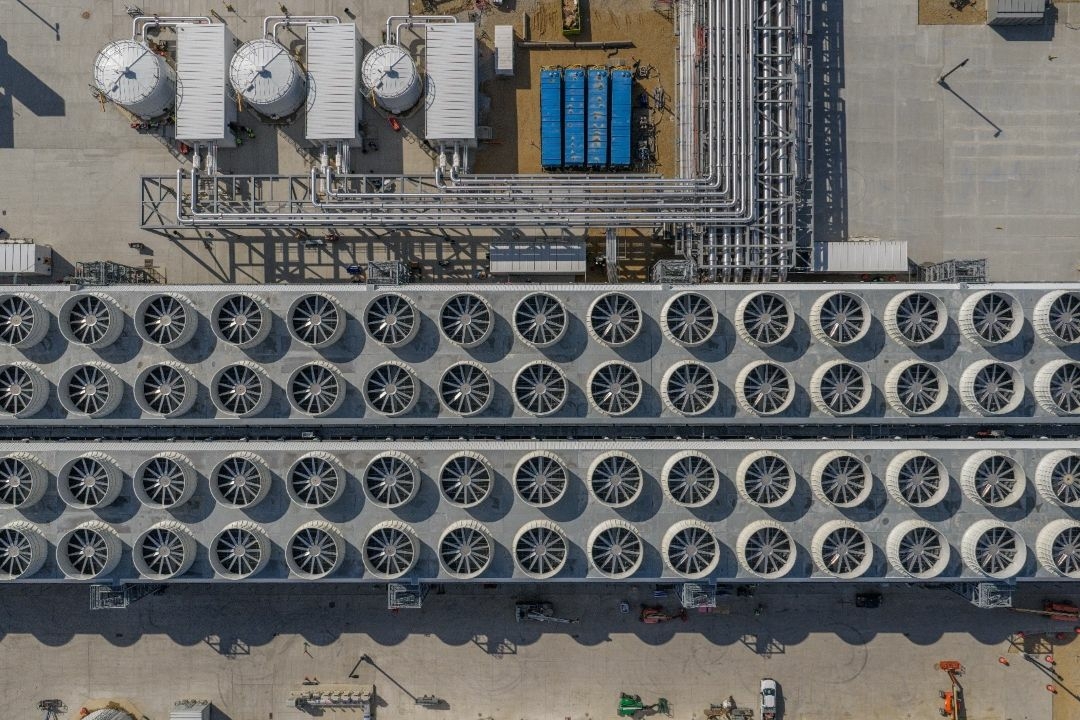

De l'autre, il refuse de quantifier la consommation d'eau d'une industrie particulièrement gourmande. Un data center de taille moyenne peut consommer des centaines de millions de litres par an pour refroidir ses serveurs, et cette demande explose avec les besoins de l'IA.

Selon l'Agence Internationale de l'Énergie (IEA), l'industrie mondiale des data centers pourrait voir sa consommation d'eau plus que doubler d'ici 2030. Or, une part significative de ces nouvelles infrastructures est construite dans des États déjà en situation de stress hydrique, comme la Californie, l'Arizona et le Texas. Plus de 44 % du territoire californien est actuellement affecté par un certain niveau de sécheresse, rendant chaque goutte d'eau précieuse.

Une régulation à l'arrêt, mais des innovations en vue ?

La décision californienne contraste avec les débats en cours ailleurs, notamment en Europe, où la Commission européenne a dévoilé une stratégie sur la résilience de l'eau.

D'autres projets de loi visant à réguler la consommation énergétique des data centers ou à lier des avantages fiscaux à l'utilisation d'énergies renouvelables n'ont pas non plus abouti cette année.

Datacenter Fairwater de Microsoft en circuit d'eau fermé

L'espoir se tourne donc vers l'innovation technologique elle-même. Les grands acteurs du cloud comme Microsoft, Google ou AWS investissent dans des mesures de durabilité et explorent de nouvelles méthodes de refroidissement.

Des études récentes montrent que des techniques comme les plaques froides ou le refroidissement par immersion pourraient réduire l'usage de l'eau de 30 à 50 %. La question reste ouverte : ces avancées suffiront-elles à compenser la croissance exponentielle du secteur, désormais libre d'opérer sans transparence sur sa soif d'une ressource de plus en plus critique ?