Surnommé « Chatcontrol » par ses détracteurs, le projet de règlement européen CSAR (Child Sexual Abuse Regulation) refait surface. Portée par le Danemark, qui assure la présidence du Conseil de l'UE, une nouvelle version du texte est actuellement en discussion entre les 27 États membres et devrait faire l'objet d'un vote en octobre. L'intention affichée est de lutter contre la diffusion de contenus pédocriminels en ligne, mais la méthode proposée déclenche une levée de boucliers massive de la part des experts en sécurité, des associations de défense des libertés et même des entreprises technologiques.

Un projet de surveillance au nom de la protection de l'enfance

L'idée centrale du projet est d'imposer à toutes les plateformes de communication, y compris les messageries sécurisées comme WhatsApp, Signal ou Telegram, de scanner les échanges de leurs utilisateurs. La nouvelle version du texte limite cette obligation de détection aux images et aux URL, laissant de côté les messages textes et audio. Malgré cet ajustement, le principe reste le même : analyser des conversations privées. Si un contenu est identifié comme potentiellement illégal, une alerte serait envoyée aux autorités. Cette approche, bien que partant d'un objectif louable, est considérée par beaucoup comme une porte ouverte à une surveillance de masse généralisée.

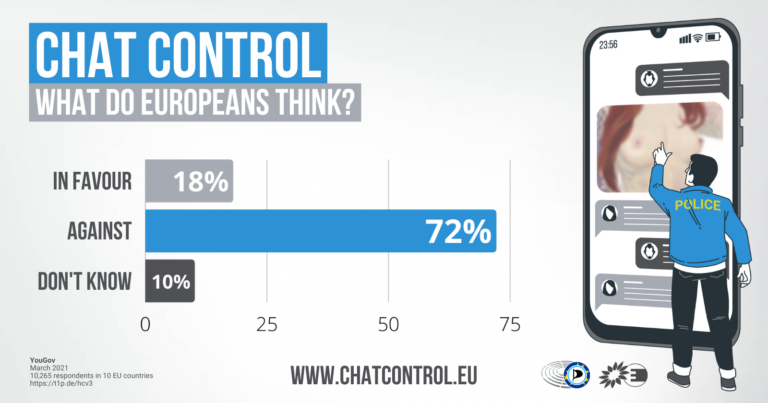

Une opposition massive des experts et de la société civile

Depuis sa première proposition en 2022, le texte fait face à une opposition quasi unanime des spécialistes. Plus de 660 chercheurs et scientifiques, dont une cinquantaine de Français, ont signé une nouvelle lettre ouverte en septembre 2025 pour alerter sur les dangers d'une telle loi. Selon eux, « la nouvelle proposition, à l’instar des précédentes, créera des capacités sans précédent en matière de surveillance, de contrôle et de censure ». Cette mobilisation s'ajoute à celle de plus de 130 organisations de la société civile, du Contrôleur européen de la protection des données (CEPD) et de la société civile, qui a organisé des manifestations à Berlin et Stockholm. Une étude montre même que 80% des jeunes de 13 à 17 ans ne se sentiraient pas à l'aise pour explorer leur identité ou être politiquement actifs si leurs communications étaient surveillées.

Des technologies de détection jugées inefficaces et dangereuses

Le cœur du problème réside dans la technologie qui serait utilisée. Le système repose sur des "hash perceptuels", des sortes de signatures numériquespermettant de reconnaître une image déjà répertoriée dans une base de données, même si elle a été légèrement modifiée. Or, selon l'expert Aurélien Francillon, professeur en sécurité numérique, qui a livré son analyse à 01net, cette méthode est profondément défaillante :

- Un taux d'erreur élevé : Même avec un faible taux de faux positifs (0,1%), le volume immense d'images échangées chaque jour en Europe (des milliards) générerait des centaines de millions de fausses alertes, accusant à tort des citoyens innocents.

- Une détection limitée : La technologie est incapable de reconnaître de nouveaux contenus pédocriminels. Elle ne repère que les images déjà connues.

- Un contournement facile : Les criminels peuvent aisément modifier légèrement les images pour échapper à la détection ou utiliser des téléphones non soumis à ces contrôles.

En somme, le système pénaliserait l'ensemble de la population tout en étant inefficace contre les véritables auteurs d'infractions.

Le chiffrement et les libertés fondamentales en péril

L'une des plus grandes craintes est l'affaiblissement du chiffrement de bout en bout. Cette technologie est aujourd'hui le seul véritable rempart protégeant nos communications privées des pirates, des entreprises ou des États. Obliger les plateformes à analyser le contenu des messages reviendrait à créer des "portes dérobées" (backdoors) dans cette sécurité. La Signal Foundation a même menacé de se retirer du marché européen plutôt que de compromettre la sécurité de son service. Cette mesure menace directement les articles 7 et 8 de la charte des droits fondamentaux de l’Union européenne, qui garantissent le respect de la vie privée et la protection des données personnelles. La question se pose donc : une société est-elle plus sûre si elle renonce aux outils qui la protègent ?