C'était attendu. Google dévoile Gemini 2.0 qui est (forcément) introduit comme son modèle d'IA générative le plus performant à ce jour. Toujours nativement multimodal, Gemini 2.0 va toutefois plus loin en la matière, notamment pour générer nativement de l'audio et des images, et avec la capacité de traiter plusieurs types d'entrées.

Cela étant, Gemini 2.0 est encore en cours de développement. « Nous n'en sommes qu'aux premiers stades de développement, mais nous sommes impatients de voir comment les testeurs de confiance utilisent les nouvelles capacités et quels enseignements nous pouvons en tirer, afin de les rendre plus largement disponibles dans les produits à l'avenir. »

L'ambition affichée de Google est d'intégrer Gemini 2.0 à divers produits, si ce n'est l'ensemble de ses produits au final. Le moteur de recherche de Google n'est pas oublié avec la fonctionnalité AI Overviews pour des résumés générés par IA avec les requêtes des utilisateurs.

Gemini 2.0 Flash à tester dans le chatbot Gemini

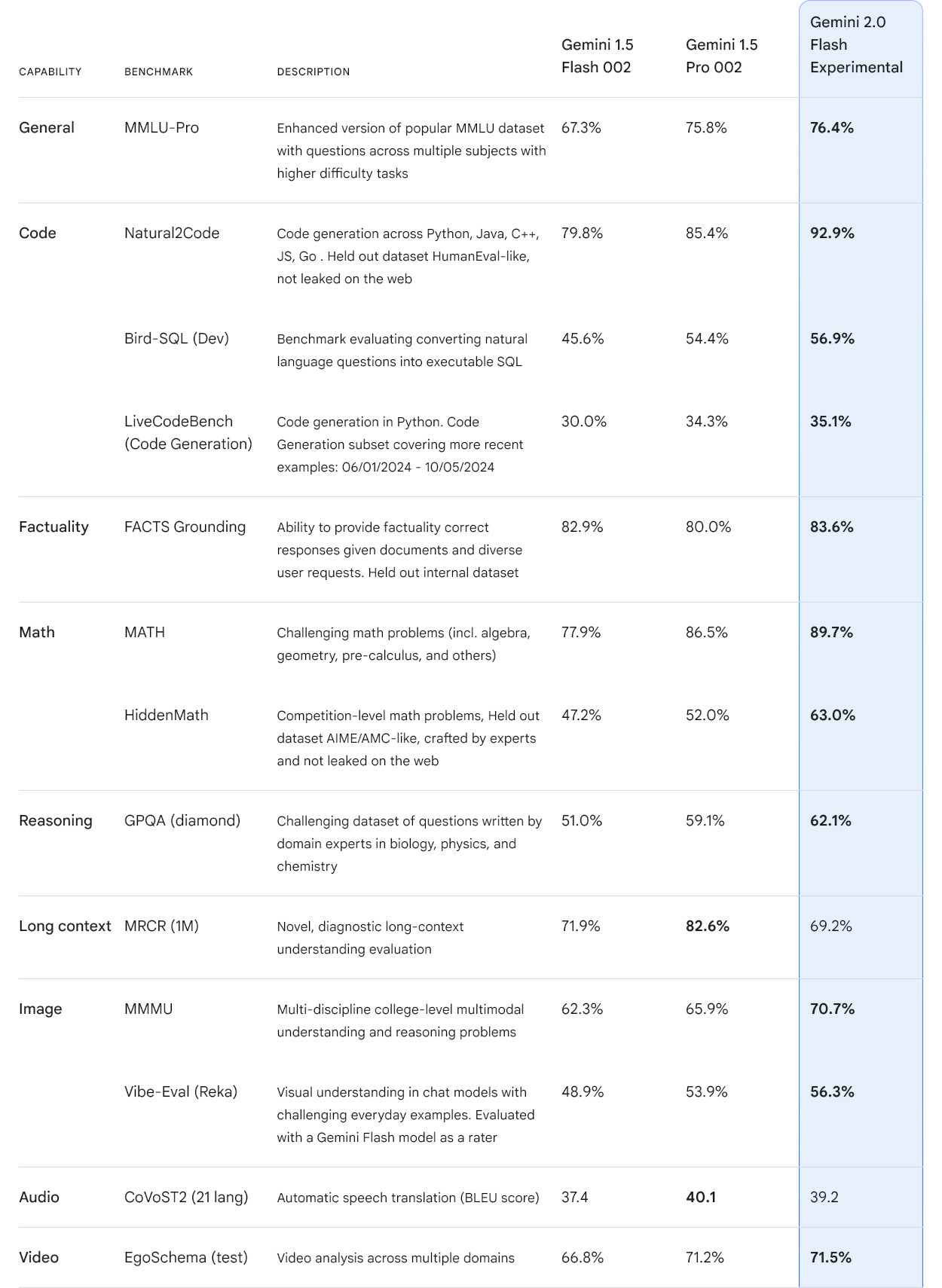

D'ores et déjà, une version expérimentale de Gemini 2.0 Flash (plus petit modèle du côté des paramètres) fait ses débuts dans le chatbot IA Gemini. Optimisé pour les discussions, Gemini 2.0 Flash offre une faible latence et des performances améliorées par rapport à Gemini 1.5 Flash, mais aussi Gemini 1.5 Pro.

Gemini 2.0 Flash (Expérimental) est également disponible auprès des développeurs via l'API Gemini dans Google AI Studio et Vertex AI, avec une entrée multimodale et une sortie texte pour tous. La synthèse vocale et la génération d'images natives sont par contre en accès anticipé pour des partenaires.

Une disponibilité générale pour les développeurs est prévue dès le mois de janvier prochain et s'accompagnera d'autres tailles de modèles. À noter que la technologie de filigrane (watermark) SynthID est appliquée pour toutes les créations avec Gemini 2.0 Flash (images et audio).

Des expériences dites « agentives »

Avec l'arrivée de Gemini 2.0, Google insiste sur des applications en tant qu'agents IA. « Je les considère comme des systèmes intelligents, capables de raisonner, de planifier, de mémoriser, d'anticiper plusieurs étapes à l'avance et de travailler avec des logiciels et des systèmes, tout cela pour accomplir quelque chose en votre nom et, surtout, sous votre supervision », avait déclaré Sundar Pichai, le patron de Google et d'Alphabet, lors de l'édition 2024 de la conférence Google I/O.

Plusieurs prototypes sont ainsi évoqués, en plus d'une mise à jour de Project Astra qui incarne l'avenir d'un assistant IA visuel et universel sur smartphone. Grâce à Gemini 2.0, Project Astra peut désormais gérer plusieurs langues, utiliser la recherche Google, Lens et Maps, mémoriser jusqu'à 10 minutes au cours d'une session, comprendre avec une latence similaire à celle d'une conversation humaine.

Project Mariner est un prototype d'extension pour Chrome afin d'aider à effectuer des tâches web à la place de l'utilisateur, en comprenant le contenu affiché sur l'écran et les éléments du navigateur. Une confirmation de la rumeur au nom de code Jarvis pour piloter le navigateur.

À destination des développeurs, Project Jules est un agent IA qui s'intègre directement dans un flux de travail GitHub pour les aider dans leurs tâches de programmation. Google collabore en outre avec les développeurs de jeux Supercell pour des agents IA capables de comprendre les règles et les défis, puis de faire des suggestions en s'appuyant sur la recherche Google.