Face à la demande énergétique insatiable de l'intelligence artificielle, Elon Musk et Jensen Huang estiment que la Terre ne suffira plus. Ils proposent une solution radicale : délocaliser les supercalculateurs en orbite pour profiter de l'énergie solaire illimitée et d'un refroidissement naturel. Cette vision redéfinira-t-elle notre infrastructure technologique.

Lors d'un événement tenu à Washington, les deux géants de la tech ont dressé un constat alarmant : la planète Terre ne dispose tout simplement pas de l'énergie ou des capacités de refroidissement nécessaires pour supporter la prochaine génération d'IA.

Selon eux, l'escalade de la puissance de calcul est telle que la seule voie viable est de pousser l'infrastructure informatique dans l'espace, un environnement où l'énergie solaire est infinie et le froid sidéral, un atout majeur.

Une planète aux ressources limitées

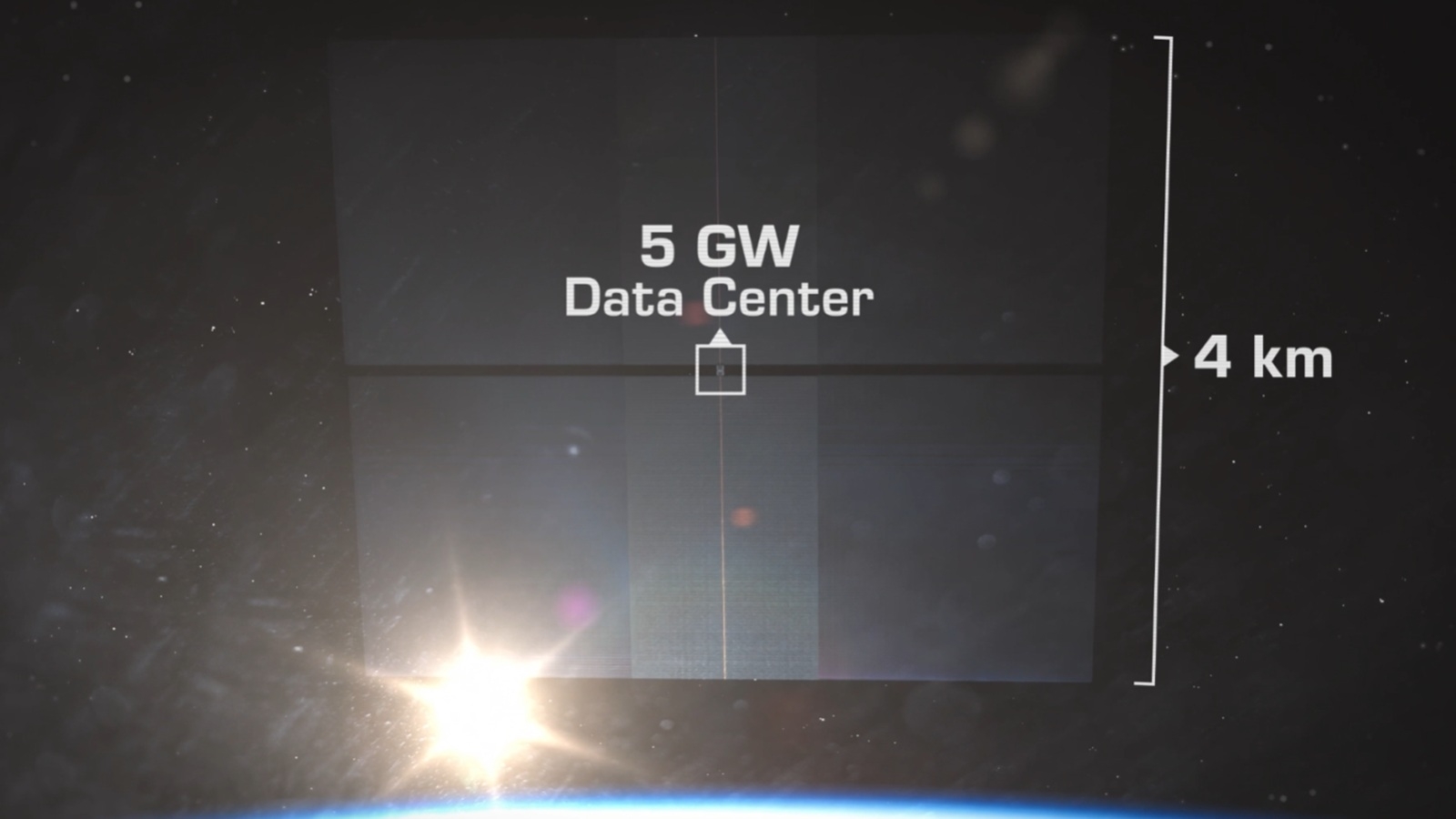

Le principal argument avancé par Elon Musk repose sur un double goulot d'étranglement : l'énergie et le refroidissement. Selon lui, la trajectoire actuelle de l'IA, si elle se maintient, exigera des centaines de gigawatts, voire des térawatts de puissance.

Pour mettre cela en perspective, la consommation moyenne des États-Unis s'élève à environ 460 gigawatts. Atteindre un térawatt de consommation électrique dédiée à l'IA sur Terre est, selon ses termes, "impossible".

Jensen Huang, de son côté, a insisté sur le défi du refroidissement. Il a rappelé que dans les supercalculateurs actuels, comme les racks Nvidia GB300, plus de 95 % de la masse est dédiée aux systèmes de refroidissement.

Avec des puces toujours plus denses et plus chaudes, les solutions terrestres, souvent dépendantes de grandes quantités d'eau et d'espace, deviennent un frein économique et écologique majeur.

L'espace, une solution évidente ?

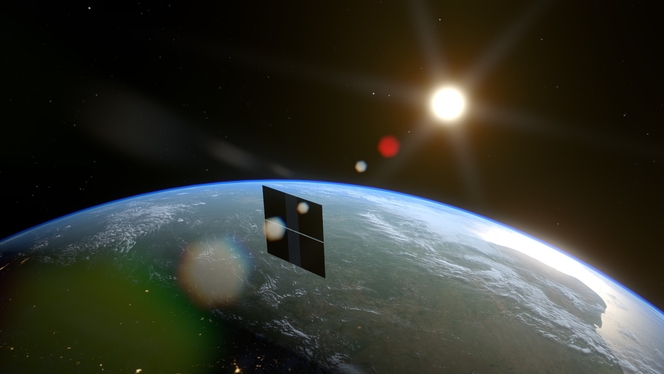

Face à ces limites, l'espace apparaît comme une solution presque parfaite. Les deux dirigeants imaginent des essaims de satellites-data centers alimentés par une énergie solaire continue.

L'absence d'atmosphère et de cycle jour/nuit élimine le besoin de lourdes batteries. De plus, les panneaux solaires spatiaux peuvent être plus légers et moins chers, car ils ne nécessitent ni verre de protection ni structures de support massives.

Le refroidissement, quant à lui, deviendrait passif. Dans le vide spatial, la chaleur est simplement dissipée par radiation, un processus naturel et sans coût. Elon Musk estime même que d'ici quatre à cinq ans, le coût de calcul de l'IA dans l'espace pourrait devenir "massivement plus avantageux" que sur Terre.

Un rêve encore lointain

Si la vision est séduisante, Jensen Huang l'a lui-même qualifiée de "un rêve" pour le moment. Les obstacles sont en effet colossaux. Déployer des fermes de serveurs en orbite géostationnaire (GEO), l'orbite la plus propice, soulève d'immenses contraintes techniques.

La dissipation de la chaleur exigerait des radiateurs de plusieurs dizaines de milliers de mètres carrés, des structures d'une taille jamais déployée.

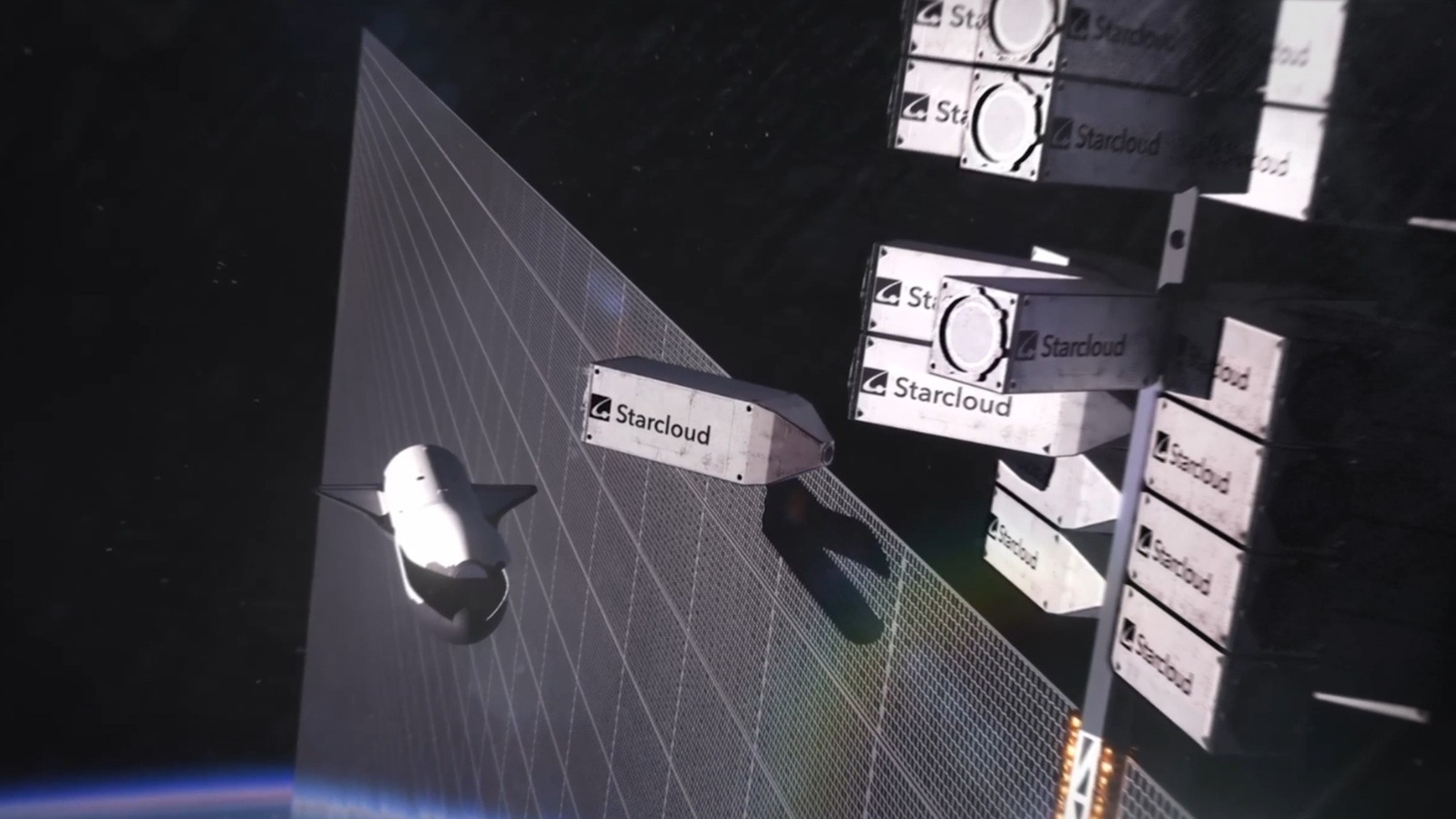

Projet de datacenter spatial de Starcloud

De plus, les composants électroniques de haute performance ne sont pas conçus pour survivre aux rayonnements cosmiques sans un blindage lourd ou une reconception complète, ce qui réduirait leurs performances.

Enfin, la logistique est sans commune mesure avec ce qui existe aujourd'hui : le lancement de telles masses nécessiterait des milliers de vols Starship, sans parler des défis liés à la maintenance robotisée et à la connectivité haut débit avec la Terre.

La proposition de Musk et Huang n'est donc pas seulement une décision technologique, mais un véritable pari civilisationnel. Elle marque peut-être la première étape vers une dissociation entre l'humanité et ses outils de calcul les plus puissants.

Reste à savoir si ce futur se réalisera dans les cinq ans, comme l'anticipe Musk, fidèle à son image d'homme pressé, ou s'il restera encore longtemps dans le domaine de la science-fiction.