À l’horizon 2026, Nvidia veut transformer en profondeur la manière dont ses unités de calcul communiquent. Le géant du GPU prépare le déploiement d’interconnexions optiques reposant sur la photonique sur silicium et les plateformes de commutateurs à très haut débit.

Ces innovations visent à dépasser les limites du cuivre et à rendre possibles des infrastructures rassemblant potentiellement des millions de processeurs graphiques dédiés à l’intelligence artificielle. Une évolution qui pourrait redessiner les architectures des futurs centres de données.

Pourquoi la lumière est devenue incontournable

À mesure que les réseaux d’IA s’étendent, le goulot d’étranglement ne réside plus seulement au niveau des GPU, mais dans la façon dont ils communiquent entre eux.

Les connexions électriques traditionnelles atteignent leurs limites, en termes de débit, mais aussi en raison de leur forte consommation énergétique. Recourir à la lumière, par le biais de la photonique intégrée, permet de réduire les pertes et d’accroître drastiquement la bande passante.

Nvidia envisage d’intégrer directement ces composants optiques dans ses plateformes. Ce choix ne relève pas uniquement de la performance brute : il répond aussi au besoin de réduire la dépense énergétique et le coût croissant des centres de données IA.

Les interconnexions optiques prévues par Nvidia

L’objectif affiché est de mettre en place d’ici 2026 des réseaux reposant sur des switches capables de gérer jusqu’à 400 térabits par seconde. Ces plateformes pourraient supporter des clusters regroupant plusieurs millions de GPU, une dimension encore jamais atteinte.

L’entreprise met en avant sa technique co-packaged optics Networking switches (Nvidia Spectrum-X et Quantum-X), une technologie annoncée début 2025 consistant à intégrer au plus près de la puce les éléments optiques, afin de minimiser les pertes dues aux interconnexions électriques classiques.

Nvidia développe ainsi les bases d’une infrastructure appelée à s’imposer comme un standard pour les centres de calcul de nouvelle génération. Si cette transition réussit, elle donnerait naissance à une architecture où la connectivité suit la même courbe de progression que la puissance individuelle des processeurs graphiques.

Un bouleversement pour les data centers d’IA

Ce déploiement pourrait transformer radicalement le paysage des datacenters. L’idée n’est plus de simplement relier quelques dizaines ou même quelques centaines de milliers de GPU, mais de permettre à des bataillons de processeurs graphiques d’échanger en temps réel, comme s’ils ne formaient qu’un seul système. La vision portée par Nvidia est celle d’immenses clusters taillés pour l’entraînement de modèles toujours plus vastes.

Ces changements s’accompagnent aussi d’une nouvelle façon de concevoir les architectures. Là où l’évolutivité était auparavant limitée par les câblages électriques, la lumière ouvre la possibilité d’un passage à des échelles inédites.

Les enjeux stratégiques de cette transition

Derrière l’aspect technique, l’initiative a une portée bien plus large. Nvidia entend non seulement résoudre un problème d’ingénierie, mais aussi sécuriser sa position dominante sur le marché de l’IA.

En offrant des plateformes capables d’orchestrer des millions de GPU, la firme verrouille une partie cruciale de la chaîne technologique. Les acteurs qui développeront leurs futures infrastructures pourraient se retrouver dépendants de ces choix matériels.

Cette orientation répond aussi à une tendance de fond : la soif insatiable de puissance de calcul pour entraîner les modèles d’IA. Chaque saut technologique dans la connectivité conditionne l’avenir de ces applications. C’est pourquoi la photonique sur silicium n’apparaît plus comme une option, mais comme une nécessité stratégique.

Si les prédictions de Nvidia se confirment, les années à venir pourraient être marquées par l’arrivée progressive de centres de données bâtis autour de la lumière. Pour de nombreux experts, il s’agit d’un changement de paradigme comparable à l’introduction des GPU eux-mêmes dans le calcul intensif.

Vers des GPU pensés comme un réseau optique

Là où la puissance de calcul brute constituait jusqu’ici le moteur de l’innovation, la connectivité devient désormais une dimension tout aussi critique. L’idée n’est pas uniquement d’ajouter davantage de GPU, mais d’organiser leur interaction de manière fluide grâce à des interconnexions photoniques.

Ce modèle pourrait aboutir à ce que l’on considère les clusters de GPU non plus comme des ensembles de composants séparés, mais comme un seul calculateur maillé par la lumière.

Le calendrier annoncé pour 2026 laisse peu de temps pour valider cette transition à grande échelle, mais Nvidia a déjà commencé à bâtir le cadre nécessaire. Cette vision, combinée à la croissance rapide des applications IA, pourrait remodeler la hiérarchie des acteurs technologiques d’ici la fin de la décennie.

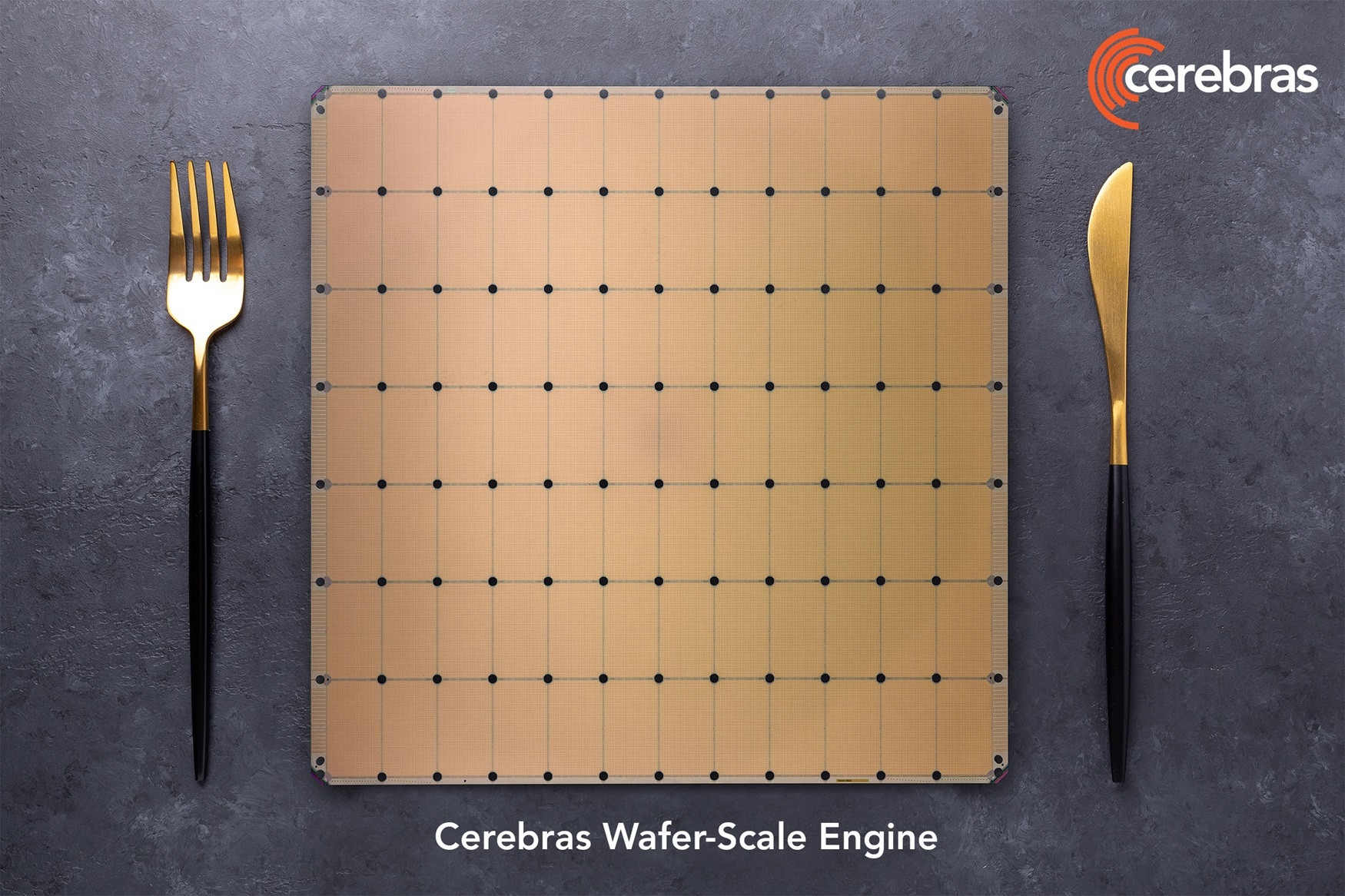

Les GPU avec photonique rivaliseront-ils avec les puces géantes sur wafer ?

C'est peut-être aussi une façon de relancer l'intérêt du GPU par rapport aux solutions récentes poussées par des concurrents, à l'image des puces géantes sur wafer combinant des centaines de milliers de processeurs spécialisés travaillant ensemble grâce à un système d'interconnexion et une très généreuse quantité de mémoire.

Passer à la photonique résoudrait un certain nombre des barrières techniques qui font qu'au-delà d'un seuil, augmenter le nombre de GPU dans un système n'a plus d'intérêt du fait de l'augmentation d'autres contraintes.