Après plusieurs mois de rumeurs et une curiosité aiguisée par le phénomène ChatGPT fonctionnant avec GPT-3.5, OpenAI vient d'annoncer GPT-4 (Generative Pre-trained Transformer 4) qui est introduit comme un grand modèle de langage multimodal.

OpenAI plante le décor : " Bien que moins performant que les humains dans de nombreux scénarios de la vie réelle, GPT-4 affiche des performances de niveau humain sur diverses références professionnelles et académiques. "

À titre d'exemple, OpenAI indique que GPT-4 a réussi un examen simulé du barreau pour devenir avocat avec un score se situant parmi les meilleurs 10 %, quand le score de GPT-3.5 se situait dans le bas du classement, au niveau des 10 % les moins bons.

Pas une nouvelle révolution

Dans le cadre d'une discussion informelle, OpenAI souligne cependant que la différence entre GPT-3.5 et GPT-4 peut être subtile. " La différence apparaît lorsque la complexité de la tâche atteint un certain seuil suffisant. GPT-4 est alors plus fiable, plus créatif et capable de traiter des instructions beaucoup plus nuancées que GPT-3.5. "

Dès lors mieux adapté à la résolution de tâches et problèmes plus compliqués avec une meilleure précision, GPT-4 ne gomme pas certaines limitations des modèles précédents. Il est toujours sujet à des erreurs de raisonnement et aux fameuses hallucinations de l'IA, même si elles ont été réduites de manière significative par rapport à GPT-3.5.

La base de connaissances de GPT-4 demeure cantonnée à septembre 2021 et pas au-delà. Par ailleurs, GPT-4 n'apprend pas de sa propre expérience et de ses potentielles erreurs. Les diverses versions de GPT ont progressé grâce à toujours plus de capacité de traitement de paramètres, mais c'est un point qu'Open AI ne détaille pas… après de folles rumeurs.

Avec des entrées visuelles, mais pas en sortie

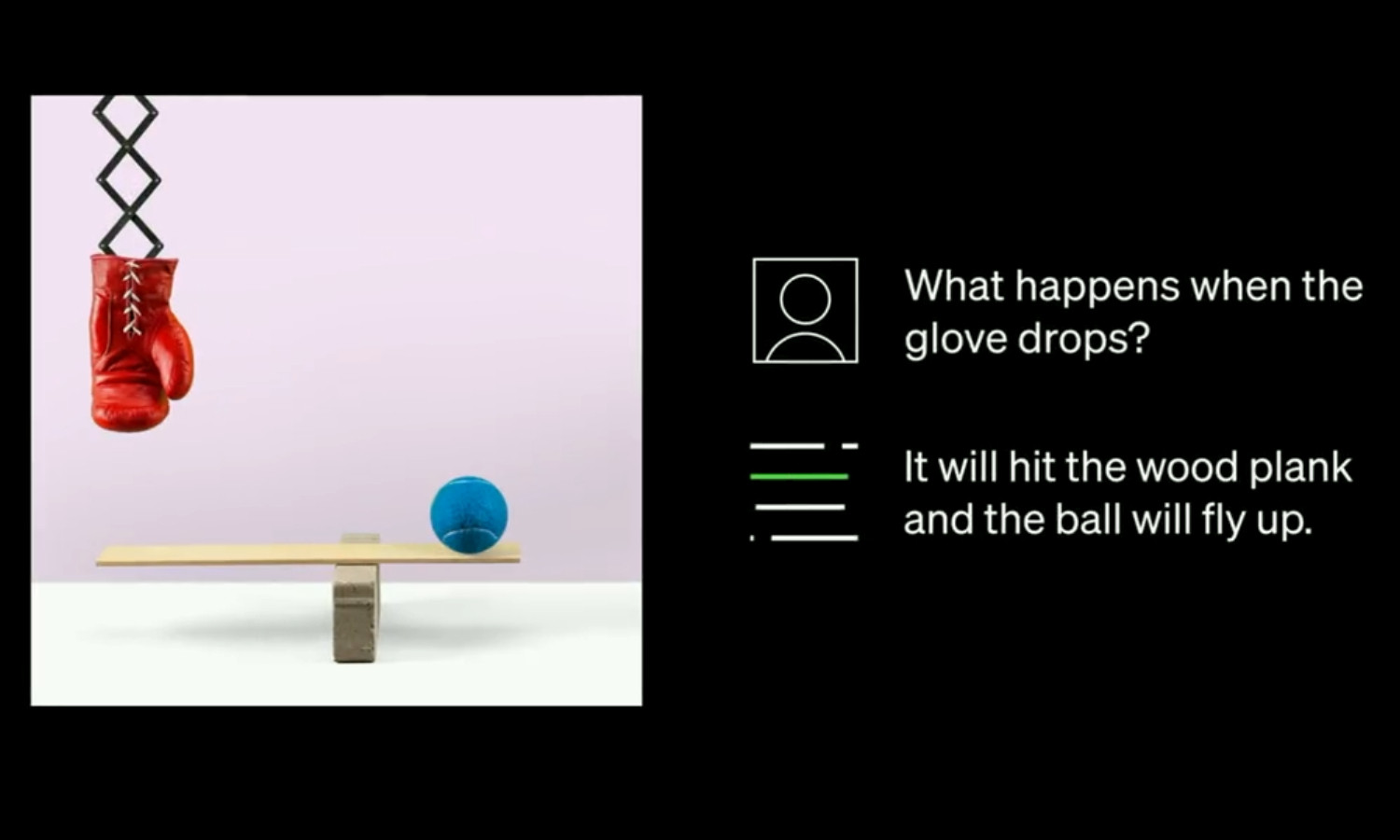

En tant que modèle de langage multimodal, GPT-4 dispose de la faculté de traiter des images, en plus du texte. Des commandes textuelles et des images pourront ainsi être acceptées en entrée, tandis que la génération de réponses se limitera à du texte.

OpenAI précise une génération de sorties textuelles (langage naturel, code informatique…) à partir d'entrées composées de texte et d'images intercalés. Une telle analyse en simultané doit permettre une interprétation de données plus complexes. Pour les entrées visuelles avec le modèle GPT-4, il s'agit actuellement d'un stade alpha préliminaire. L'association avec du texte semble en tout cas prometteuse.

OpenAI a déjà plusieurs partenaires pour l'intégration de GPT-4 dans divers produits, dont Duolingo et Stripe, alors que Be My Eyes exploite GPT-4 pour l'accessibilité visuelle. Pour le grand public, le nouveau modèle d'IA est disponible via l'abonnement payant ChatGPT Plus.