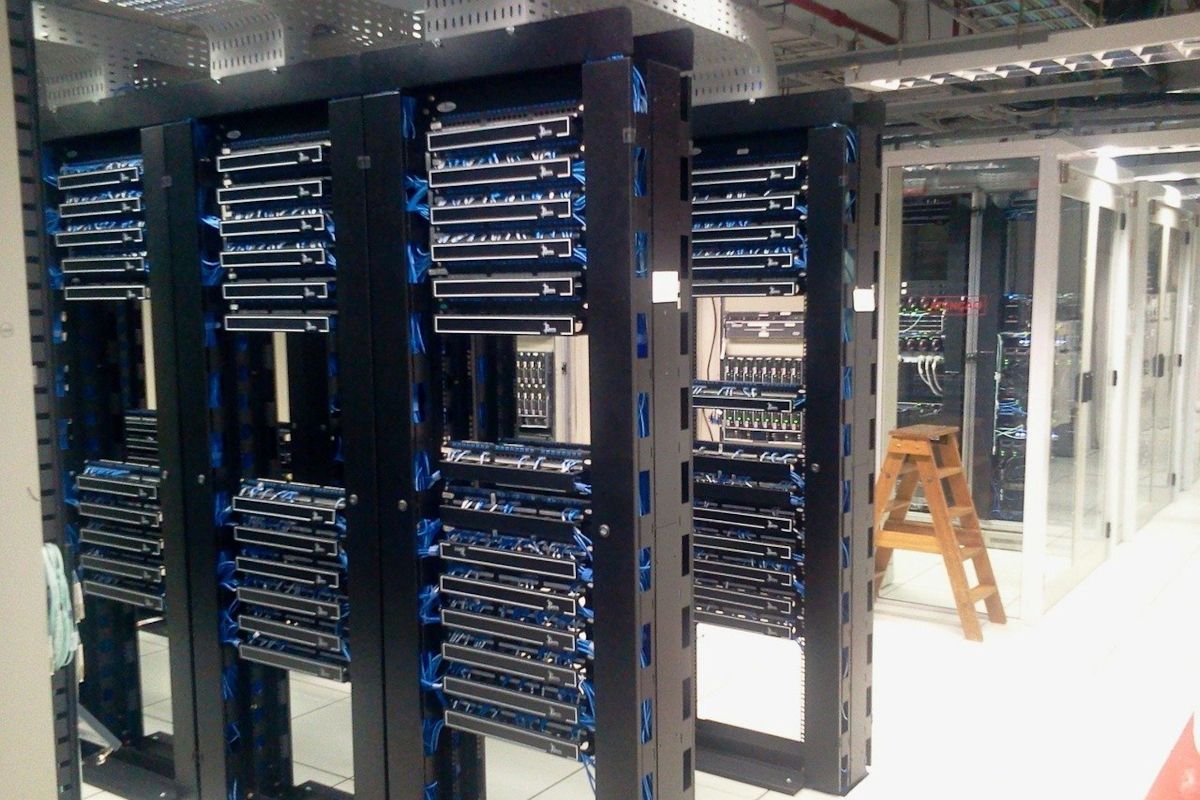

En 2020, Microsoft avait dévoilé l'existence d'un supercalculateur développé en collaboration avec OpenAI. Via la plateforme Azure, c'est une exclusivité pour les coûteux besoins en matière d'entraînement des modèles d'IA massifs et distribués du créateur de ChatGPT, DALL-E et autres.

À l'époque, le supercalculateur avait été annoncé avec plus 285 000 cœurs CPU, 10 000 GPU et une bande passante de 400 Gbit/s pour chaque serveur GPU. Actuellement, il s'agit en particulier de puces graphiques A100 (Ampere) et H100 (Hopper) de Nvidia.

Selon une information de Reuters, OpenAI envisage à son tour la possibilité de fabriquer ses propres puces d'IA afin de soutenir ses activités. Aucune décision définitive n'aurait toutefois été prise pour ce qui serait un travail de longue haleine. OpenAI n'a pas souhaité faire de commentaires.

Face à la crainte constante d'une pénurie

Diverses options seraient sur la table, y compris par le biais de l'acquisition d'une société spécialisée dans le but d'accélérer un peu les choses. Pour autant, ce ne serait pas nécessairement gage de succès. Qui plus est, la dépendance à un acteur comme Nvidia resterait forte pendant encore un bon moment.

Une crainte exprimée par Sam Altman, cofondateur et patron d'OpenAI, est le manque d'accès à davantage de puces d'IA. Une pénurie en lien avec une forte demande qui est susceptible de ralentir certains projets d'IA. La question des onéreux coûts associés est également problématique.

Récemment et dans le cadre du déploiement de DALL-E 3 avec Bing Chat et Bing.com/create, Microsoft a indiqué que l'intérêt suscité a été tel qu'il a nécessité l'ajout de plus de GPU.