La technologie, lorsqu'elle est pensée avec empathie, peut devenir une formidable extension des sens. C'est cette ambition que Meta concrétise avec ses lunettes intelligentes Ray-Ban Meta, en dévoilant, à l'occasion de la Journée Mondiale de Sensibilisation à l'Accessibilité, des fonctionnalités qui pourraient bien changer le quotidien des personnes aveugles ou malvoyantes. L'intelligence artificielle se met ici au service d'une perception du monde enrichie, promettant un surcroît d'autonomie significatif.

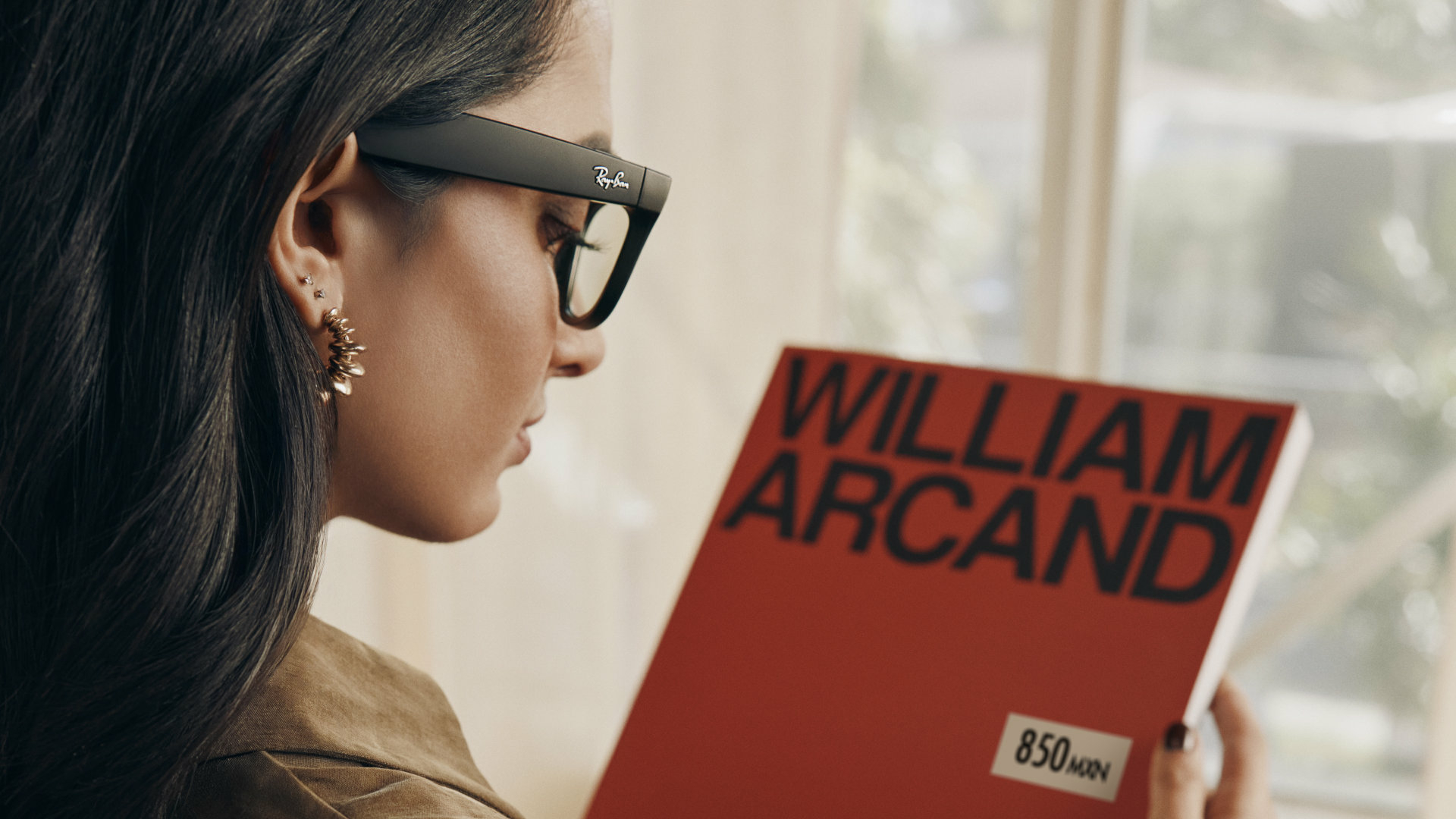

L'IA des Ray-Ban Meta : le monde décrit à l'oreille

Au cœur du dispositif, l'intelligence artificielle de Meta, Meta AI, exploite la caméra ultra grand-angle de 12 mégapixels des Ray-Ban pour "voir" l'environnement de l'utilisateur. Plus qu'une simple capture, il s'agit d'une interprétation vocalisée : les lunettes narrent ce qu'elles perçoivent grâce à de discrets haut-parleurs dirigeant le son vers l'oreille. Si les descriptions sont par défaut concises pour ne pas être envahissantes, une nouvelle option baptisée "Réponses détaillées" ("Detailed Responses") permet d'obtenir un niveau d'information bien plus riche. Imaginons une promenade dans un parc : l'IA ne se contentera pas d'identifier les arbres et les passants, elle pourra aussi commenter la netteté des pelouses ou d'autres détails significatifs. Cette fonction, actuellement en test aux États-Unis et au Canada, devrait progressivement s'étendre à d'autres régions. Bien sûr, Meta rappelle à juste titre que la technologie des grands modèles de langage (LLM), aussi avancée soit-elle, n'est pas infaillible et ne doit pas remplacer le jugement humain pour des tâches critiques pour la sécurité. C'est une nuance d'importance pour les utilisateurs de cette intelligence artificielle.

"Be My Eyes" : la solidarité humaine au bout des branches

L'autre avancée majeure, et peut-être la plus touchante, est l'intégration étendue du service "Be My Eyes" par Meta. Cette initiative remarquable met en relation directe les porteurs de Ray-Ban Meta aveugles ou malvoyants avec un réseau impressionnant de plus de 8 millions de bénévoles voyants à travers le monde. Une simple commande vocale – "Hey Meta, Be My Eyes" – et un lien s'établit. Le bénévole reçoit alors en temps réel le flux vidéo capté par la caméra des lunettes et peut guider l'utilisateur, lui lire une étiquette, l'aider à identifier un objet ou à s'orienter dans un environnement inconnu, le tout via les haut-parleurs "open-ear". C'est une forme d'assistance personnalisée et instantanée qui prend tout son sens au quotidien. Déjà testé dans quelques pays depuis novembre dernier, ce service va être déployé d'ici la fin du mois de mai dans les 18 pays où Meta AI est disponible, amplifiant considérablement sa portée et son potentiel d'aide en matière d'accessibilité.

L'accessibilité, un horizon technologique en pleine expansion

Ces développements pour les Ray-Ban Meta ne sont pas des initiatives isolées. Ils s'inscrivent dans une volonté plus large de Meta de placer la technologie au service de l'inclusion, comme en témoigne aussi le lancement d'un système de sous-titrage en direct pour ses casques de réalité virtuelle Quest. Le secteur technologique dans son ensemble, d'ailleurs, semble prendre de plus en plus la mesure des enjeux liés à l'accessibilité, à l'image d'Apple qui explore des fonctionnalités similaires pour son Vision Pro. Si le chemin vers une technologie parfaitement inclusive et infaillible est encore long, chaque avancée de ce type pour des produits grand public comme les lunettes connectées ouvre de nouvelles perspectives et redonne un peu plus d'autonomie aux personnes malvoyantes.