Elon Musk annonce un changement stratégique majeur : la puce d'intelligence artificielle AI5 de Tesla sera coproduite par Samsung au Texas et TSMC en Arizona.

Cet ajustement vise à garantir un surplus de production pour ses véhicules et centres de données, tout en misant sur une conception radicalement simple pour surpasser les performances par dollar des puces Nvidia.

Jusqu'à présent, la feuille de route semblait claire : TSMC devait produire la puce AI5, tandis que Samsung hériterait de sa successeure, l'AI6. Mais lors de la dernière communication aux investisseurs, Elon Musk a dévoilé un changement de stratégie notable.

Les deux géants de la fonderie, Samsung et TSMC, se partageront finalement la fabrication de l'AI5 dans leurs usines américaines respectives, au Texas et en Arizona.

Pourquoi Tesla double la mise sur ses fournisseurs ?

Cette nouvelle stratégie de double approvisionnement répond à un objectif explicite martelé par le dirigeant : atteindre une "surproduction" de puces AI5. L'idée est de disposer d'un stock excédentaire qui pourra être alloué non seulement à sa flotte de véhicules et à ses robots humanoïdes Optimus, mais aussi à ses propres centres de données.

Elon Musk a justifié ce choix en soulignant que l'usine de Samsung au Texas disposait d'équipements "légèrement plus avancés" que le site de TSMC en Arizona. Un argument technique qui vient renforcer la volonté de Tesla de ne jamais manquer de composants critiques pour son écosystème en pleine expansion.

Une puce conçue pour la "simplicité radicale"

La véritable force de l'AI5 ne réside pas seulement dans sa puissance brute, mais dans sa philosophie de conception. Contrairement à Nvidia, qui doit créer des puces polyvalentes pour une multitude de clients aux besoins variés, Tesla n'a qu'un seul client à satisfaire : lui-même. Cette conception sur mesure permet, selon Elon Musk, de "supprimer une énorme complexité".

L'équipe d'ingénieurs, avec laquelle le PDG affirme avoir passé "presque tous les week-ends", a pu lâcher du lest en éliminant des composants hérités et jugés superflus pour ses propres applications, comme les processeurs graphiques (GPU) et de signal d'image (ISP) traditionnels.

Le résultat est une puce plus petite, qui tient sur un "demi-réticule", et optimisée de bout en bout pour les tâches d'inférence IA spécifiques à Tesla.

Quelles performances face au géant Nvidia ?

Les chiffres avancés sont ambitieux. La puce AI5 offrirait une performance par dollar jusqu'à dix fois supérieure à celle des solutions de Nvidia. Sur certains paramètres, elle serait même 40 fois plus performante que l'actuelle puce AI4 qui équipe les derniers véhicules de la marque.

Elon Musk a toutefois tenu à clarifier sa position vis-à-vis du leader du marché : "Nous ne sommes pas sur le point de remplacer Nvidia".

Tesla continuera d'utiliser les puissants GPU de la firme pour l'entraînement de ses modèles d'IA. Les puces AI5 excédentaires viendront simplement compléter l'infrastructure existante dans les centres de données.

Cette approche pragmatique illustre la double casquette de Tesla, à la fois client majeur de Nvidia via sa startup xAI et concurrent direct sur le segment du matériel d'inférence.

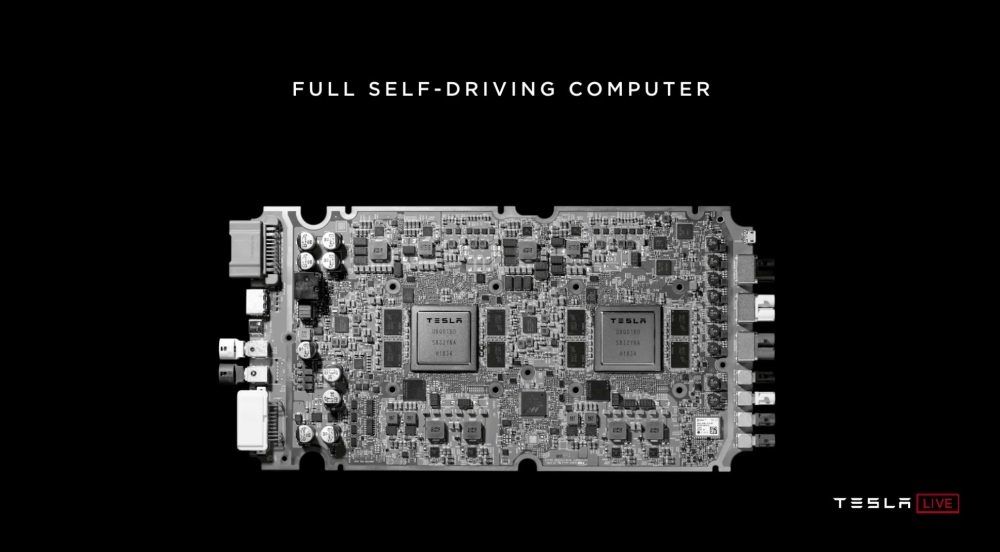

Cette montée en puissance matérielle est la pierre angulaire des futures avancées logicielles, notamment la version 14.2 du Full Self-Driving (FSD) qui promet d'introduire des capacités de "raisonnement".

Avec une production d'AI5 sécurisée et massive, Tesla prépare le terrain pour ses prochains grands projets, du Cybercab à la généralisation de la conduite véritablement autonome.