Google introduit TranslateGemma, une nouvelle collection de modèles de traduction à poids ouverts pour l'accès à une traduction de haute qualité en local. Elle découle de l'architecture Gemma 3 et se décline en trois tailles : 4, 12 et 27 milliards de paramètres.

TranslateGemma permet de couvrir 55 langues. L'annonce intervient alors qu'OpenAI a lancé en catimini ChatGPT Translate. Un simple hasard ? Il n'est pas interdit de penser qu'OpenAI a cherché à anticiper - ou parasiter - la communication de Google et d'autres à venir.

Une efficacité remarquable pour TranslateGemma

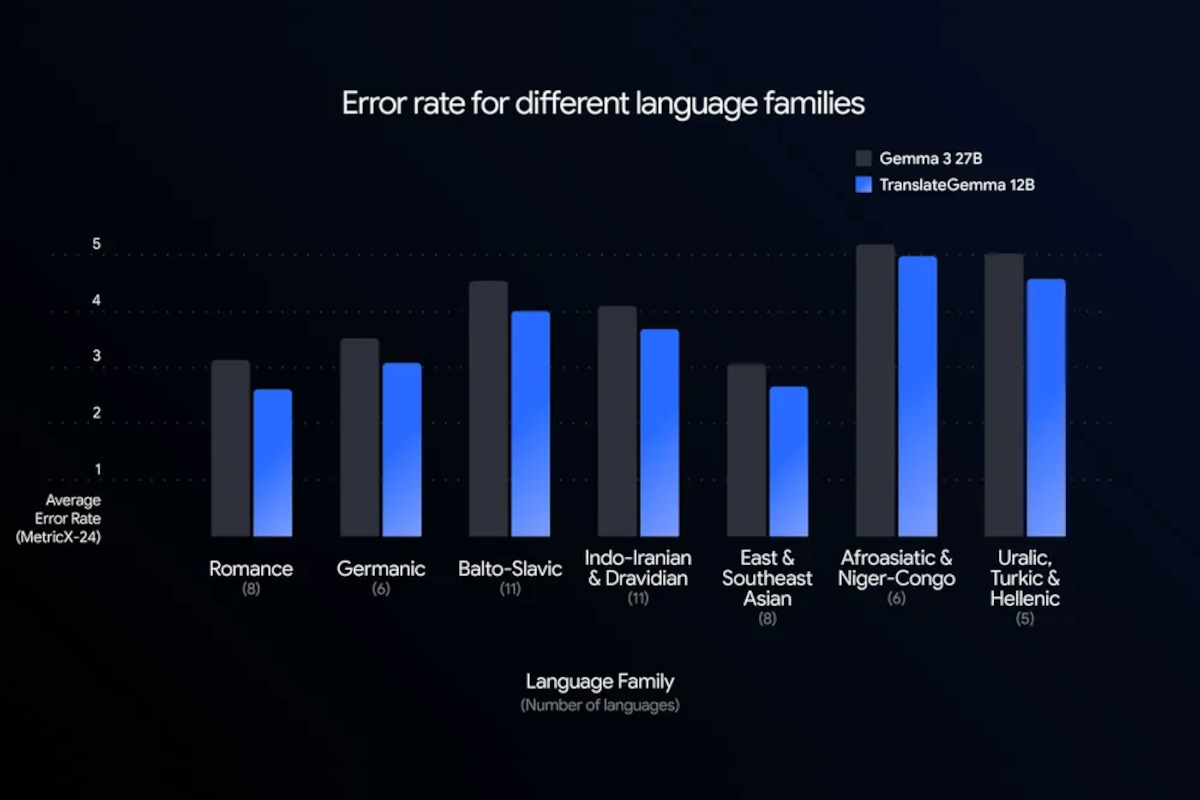

La prouesse de TranslateGemma réside dans son efficacité. Selon le benchmark WMT24++, le modèle de 12 milliards de paramètres (12B) surpasse le modèle de base Gemma 3 de 27 milliards de paramètres.

De même, le modèle 4B de TranslateGemma rivalise avec les performances du modèle de base 12B de Gemma 3, ce qui en fait un modèle puissant pour l'inférence sur appareil mobile.

Pour les développeurs, cela se traduit par un débit plus élevé et une latence réduite, sans compromis sur la précision. Le modèle 4B est optimisé pour les appareils mobiles, le 12B pour les ordinateurs portables grand public, et la version 27B est taillée pour le cloud sur un unique GPU H100.

Quel est le secret de cette optimisation ?

Google met en avant un processus de fine-tuning spécialisé en deux étapes, distillant les capacités des puissants modèles Gemini.

La première phase, le Supervised Fine-Tuning (SFT), utilise un large ensemble de données mixtes incluant des textes traduits par des humains et des traductions synthétiques de haute qualité générées par Gemini.

La seconde phase repose sur l'apprentissage par renforcement (Reinforcement Learning), où un ensemble de modèles de récompense guide les modèles vers des traductions plus naturelles et contextuellement justes.

Sans sacrifier les capacités multimodales

Les modèles TranslateGemma conservent les solides capacités multimodales de Gemma 3. Des tests sur le benchmark Vistra ont montré que les améliorations en traduction textuelle se répercutent positivement sur la traducition de texte présent dans les images, même sans entraînement multimodal spécifique.

Notamment disponibles sur Kaggle et Hugging Face, ces outils sont conçus pour être un point de départ pour les chercheurs et les développeurs avec les barrières linguistiques.