Comme pour Alexa d'Amazon et Google Assistant, l'assistant vocal Siri d'Apple peut être indiscret avec une écoute par des oreilles humaines. Suite à la publication d'un article du Guardian, Apple reconnaît que moins de 1 % des activations quotidiennes de Siri font l'objet d'une analyse par des examinateurs humains.

Apple souligne qu'il s'agit d'une " petite portion " des requêtes avec Siri d'une durée de quelques secondes, selon une sélection aléatoire et dans le but d'améliorer sa compréhension.

Selon le Guardian, les examinateurs humains sont par exemple chargés d'évaluer les réponses pour déterminer si l'activation de Siri était bien intentionnelle, si Siri était en mesure de répondre et si la réponse était appropriée.

La firme de Cupertino souligne que les réponses de Siri sont analysées dans des installations sécurisées et tous les évaluateurs sont tenus de respecter des exigences dites strictes de confidentialité. Par ailleurs, les requêtes des utilisateurs ne sont pas associées à leurs identifiants Apple.

Des sous-traitants avec des employés à travers le monde travaillent pour Apple à cette tâche. Sous couvert d'anonymat, un lanceur d'alerte explique que les enregistrements audio déclenchés par erreur sont plus fréquents avec l'Apple Watch et le HomePod. Néanmoins, rappelons que Siri est intégré dans le plupart des appareils d'Apple.

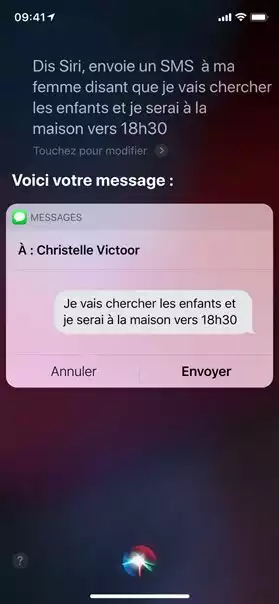

Il ajoute en outre que " d'innombrables exemples d'enregistrements " comportent des discussions privées entre médecins et patients, des transactions commerciales, voire pour des relations sexuelles ou apparemment criminelles. Ces enregistrements sont accompagnés de coordonnées, détails sur des contacts et données des applications en rapport avec l'appareil. Sans compter des informations personnelles susceptibles de permettre une identification qui sont divulguées dans les conversations elles-mêmes.

Pour le lanceur d'alerte, Apple n'est pas assez transparent vis-à-vis des utilisateurs. The Guardian écrit que contrairement à Amazon et Google qui permettent de refuser certaines utilisations de leurs enregistrements (à savoir, pour améliorer le service), ce n'est pas le cas avec Apple si ce n'est en désactivant entièrement Siri.

L'article du Guardian est une pique à l'encontre d'Apple qui fait de la confidentialité un argument marketing. Dans l'absolu, la situation n'est pas tellement différente qu'avec Amazon et Google pour l'amélioration des assistants vocaux, et il y a également des enregistrements par erreur qui sont analysés.

Avant ces révélations, Apple n'était pas explicite sur le fait que du personnel humain peut écouter des enregistrements.

Sur sa page consacrée à la protection de la vie privée, Apple écrit au chapitre " Siri et Dictée " que : " Pour les aider à reconnaître votre prononciation et à vous fournir des réponses mieux adaptées, certaines données comme votre nom, vos contacts, la musique que vous écoutez et vos recherches sont envoyées vers les serveurs Apple à l'aide de protocoles chiffrés. Siri et la fonction Dictée n'associent pas ces informations à votre identifiant Apple, mais à votre appareil via un identifiant aléatoire. " Il n'est pas fait mention d'une analyse par des humains.