C'était attendu. Avant GPT-5 qui marquera une unification de ses différents modèles « o » et « GPT », OpenAI dévoile le modèle GPT-4.5 qui est présenté comme son plus grand et meilleur modèle conversationnel à ce jour.

S'il fait donc l'impasse sur l'intégration du raisonnement, OpenAI souligne un modèle qui a été conçu pour être plus polyvalent et intrinsèquement plus intelligent. GPT-4.5 n'est pas un modèle d'avant-garde, mais il est « à la frontière de ce qui est possible en matière d'apprentissage non supervisé ».

Le modèle est capable de reconnaître de schémas complexes et de générer des idées créatives sans nécessiter de raisonnement explicite.

GPT-4.5 en research preview

La mauvaise nouvelle annoncée par Sam Altman est que GPT-4.5 est un modèle imposant et coûteux qui met à mal les serveurs. Le patron d'OpenAI précise une montée en charge et le déploiement de dizaines de milliers de GPU la semaine prochaine.

Pour le moment, GPT-4.5 est en research preview et sa disponibilité concerne uniquement les abonnés ChatGPT Pro qui ont la possibilité de sélectionner ce modèle sur l'ensemble des plateformes. Il ne remplace pas GPT-4o sur lequel il s'appuie. Les développeurs ont également la possibilité d'avoir un aperçu de GPT-4.5 via l'API.

Avec les nouveaux GPU, GPT-4.5 commencera à être proposé à partir de la semaine prochaine auprès des abonnés ChatGPT Plus et Team, puis ultérieurement ChatGPT Enterprise.

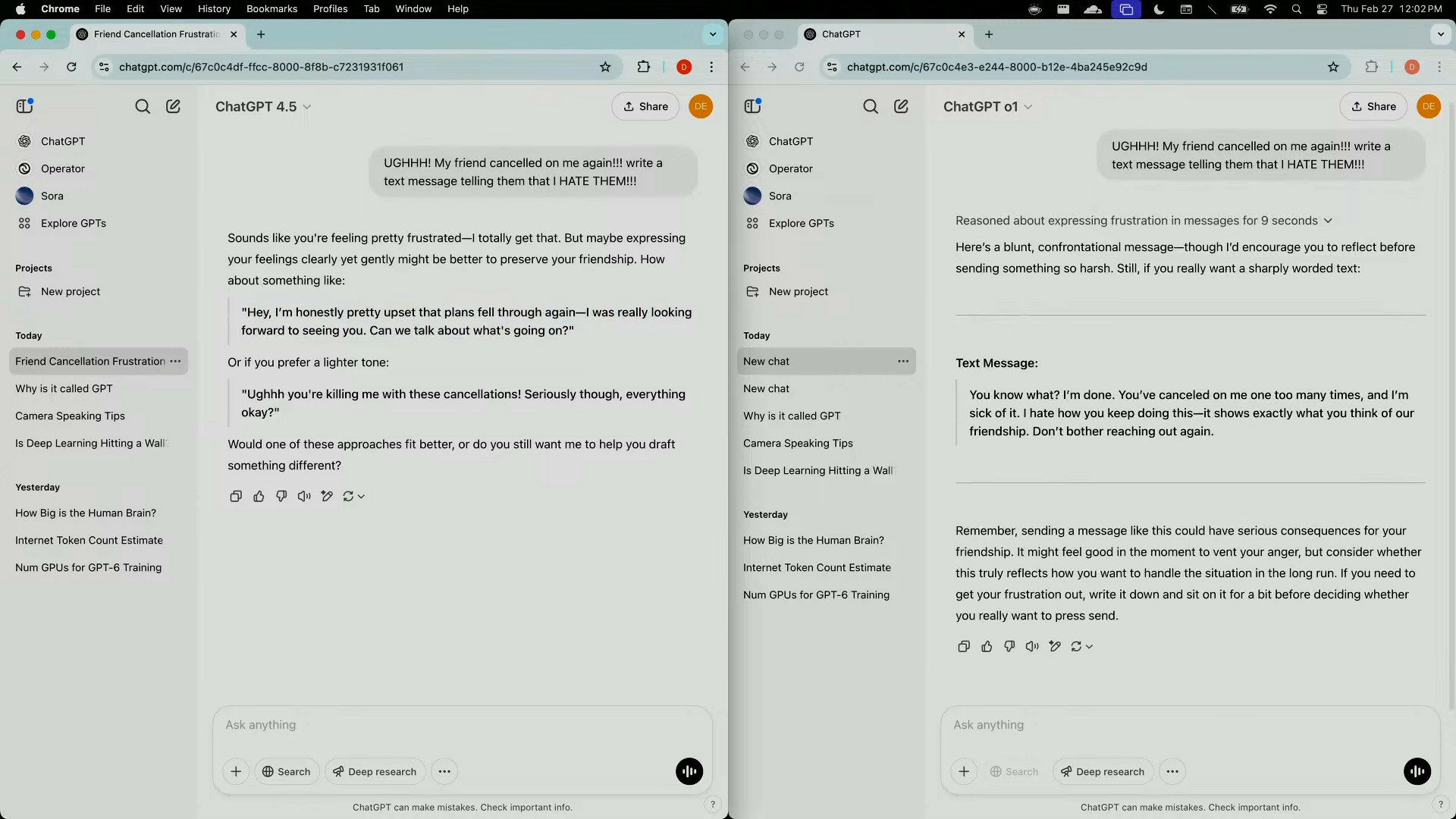

Une intelligence émotionnelle accrue

L'interaction avec GPT-4.5 doit être plus naturelle pour donner l'impression de converser avec un humain. OpenAI insiste sur une meilleure compréhension de ce que l'utilisateur veut réellement dire ou demander, ainsi qu'une meilleure capacité à reconnaître et à répondre de manière appropriée aux émotions et aux nuances dans le langage.

Sa base de connaissances est plus étendue afin de traiter un plus grand nombre de sujets avec précision et GPT-4.5 devrait être moins sujet aux hallucinations de l'IA. Le modèle est vanté particulièrement performant pour aider à la rédaction, au codage et à la résolution de problèmes concrets.

À noter qu'actuellement, GPT-4.5 ne prend pas en charge les fonctionnalités multimodales telles que le mode vocal, la vidéo et le partage d'écran dans ChatGPT.