Le groupe Microsoft officialise sa nouvelle puce IA, la Maia 200, un accélérateur gravé en 3nm par TSMC. Conçue pour l'inférence, elle vise à optimiser les coûts et les performances des modèles comme GPT-5.2 et Copilot, tout en défiant directement les solutions d'Amazon et Google dans la course à la souveraineté matérielle.

La tendance n'est pas nouvelle : pour réduire leur dépendance à l'égard de Nvidia et optimiser une structure de coûts de plus en plus lourde, les géants de la tech développent leurs propres puces. Google avec ses Tensor Processing Units (TPU) et Amazon avec sa gamme Trainium ont ouvert la voie.

C'est dans ce contexte de compétition stratégique que Microsoft muscle son jeu, deux ans après une première tentative, la puce IA Maia 100, qui n'avait jamais été proposée aux clients de son cloud.

Une architecture pensée pour l'efficacité de l'inférence

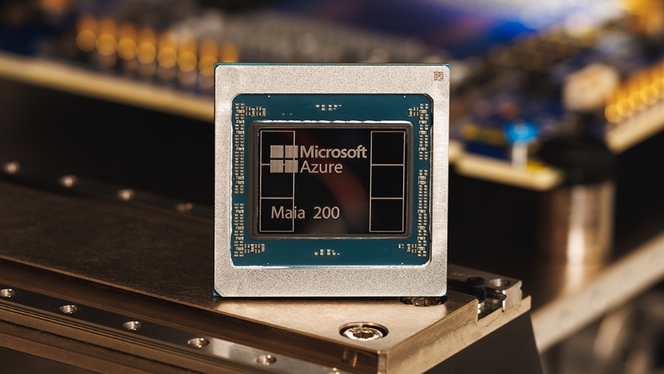

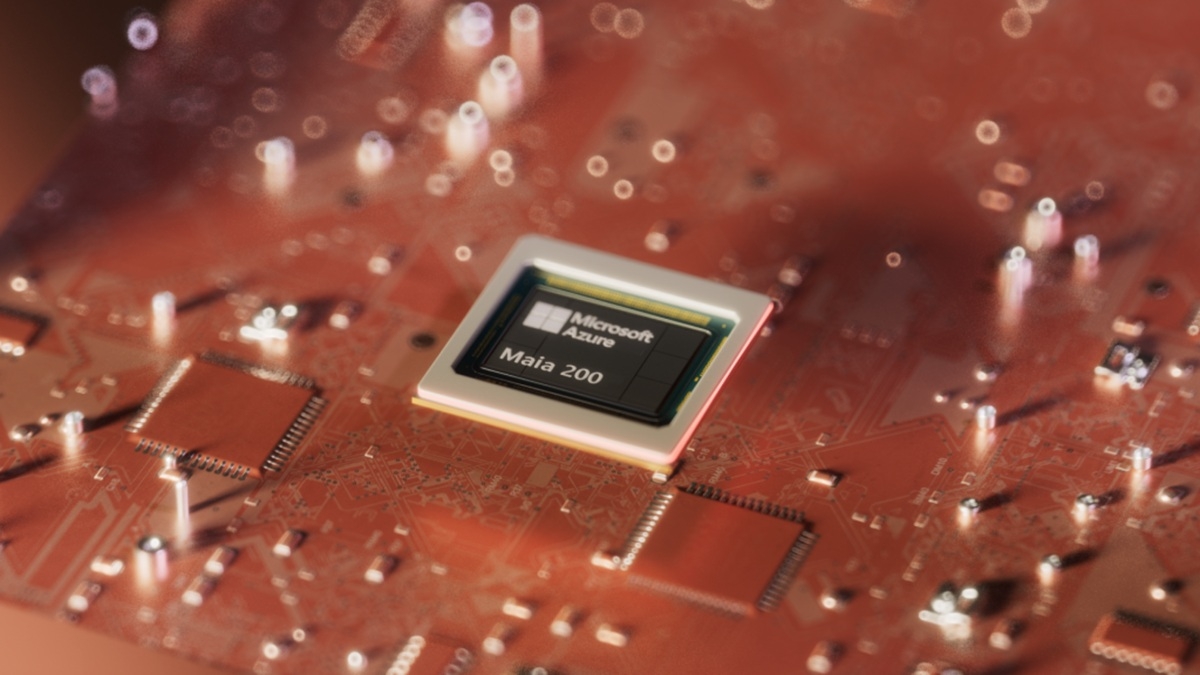

La nouvelle puce, baptisée Maia 200, est une véritable démonstration de force technique. Fabriquée par TSMC en utilisant un processus de lithogravure de 3 nanomètres, elle embarque plus de 140 milliards de transistors.

Sa conception est entièrement tournée vers l'inférence, c'est-à-dire l'exécution d'un modèle d'IA déjà entraîné, une tâche qui représente une part croissante des coûts opérationnels.

Pour y parvenir, elle affiche des performances brutes impressionnantes : plus de 10 pétaflops en précision 4 bits (FP4) et 5 pétaflops en 8 bits (FP8).

Ces chiffres permettent à Microsoft d'affirmer que sa puce IA Maia 200 offre des performances FP4 trois fois supérieures à la troisième génération des puces Amazon Trainium et surpasse la septième génération des TPU de Google en FP8.

Plus concrètement, l'entreprise promet une performance par dollar (un indicateur très suivi) améliorée de 30 % par rapport au matériel le plus récent de sa flotte actuelle, un argument économique de poids pour les développeurs et les entreprises.

Au-delà du silicium : une stratégie d'écosystème intégré

L'annonce de la Maia 200 concerne aussi le logiciel. Conscient que la domination de Nvidia repose autant sur son écosystème logiciel CUDA que sur ses GPU, Microsoft accompagne sa puce d'une suite d'outils de développement complète.

Le Maia SDK, disponible en avant-première, inclut une intégration à PyTorch et au compilateur open-source Triton, offrant ainsi une alternative directe à l'environnement de Nvidia.

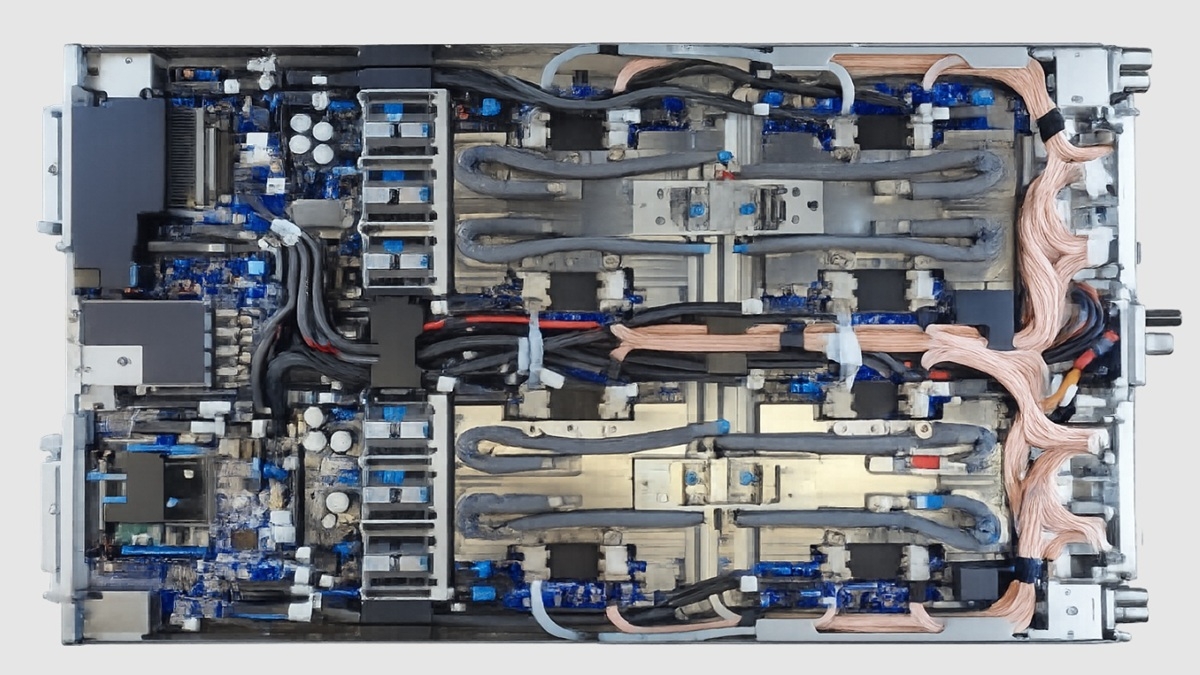

Au niveau du système, la firme de Redmond opte pour une approche pragmatique en utilisant des câbles Ethernet standard pour relier les puces entre elles, plutôt que la norme propriétaire InfiniBand promue par Nvidia.

Cette architecture permet de connecter jusqu'à 6 144 accélérateurs en cluster, réduisant la complexité et le coût total de possession tout en garantissant des performances prévisibles à grande échelle pour les charges de travail d'inférence IA.

Déploiement stratégique et prochaines étapes

La puce Maia 200 est déjà à l'œuvre. Le groupe Superintelligence de Microsoft, dirigé par Mustafa Suleyman, l'utilise pour ses propres besoins. Elle alimente également des services phares comme Microsoft 365 Copilot et la plateforme Microsoft Foundry. Elle servira également de support aux derniers modèles d'OpenAI, dont le futur GPT-5.2. Le déploiement a commencé dans le centre de données de l'Iowa, et celui de l'Arizona suivra prochainement.

Ce lancement marque une étape décisive dans la stratégie de Microsoft, qui vise une intégration verticale complète, de la puce au logiciel. Le programme d'accélérateurs Maia est conçu pour être multi-générationnel et l'entreprise travaille déjà sur les futures itérations.

En invitant les développeurs, les universitaires et les laboratoires d'IA à tester le kit de développement, Microsoft s'assure de construire un écosystème robuste autour de son silicium, préparant ainsi le terrain pour les futures batailles de l'intelligence artificielle.