" La toute première IA douée de parole accessible à tous. " C'est ainsi que Kyutai présente Moshi. Basé à Paris, ce laboratoire de recherche indépendant est dédié à l'open science en IA. Lancé en novembre dernier et à but non lucratif, Kyutai a été cofondé par Xavier Niel (Iliad), Rodolphe Saadé (CMA-CGM) et Eric Schmidt (Schmidt Futures).

Modèle d'intelligence artificielle axé sur la voix, Moshi a été développé en seulement six mois par une équipe de huit chercheurs de Kyutai qui est partie de zéro, et avec l'aide d'un millier de GPU de Scaleway. Actuellement, il s'agit d'un prototype de recherche.

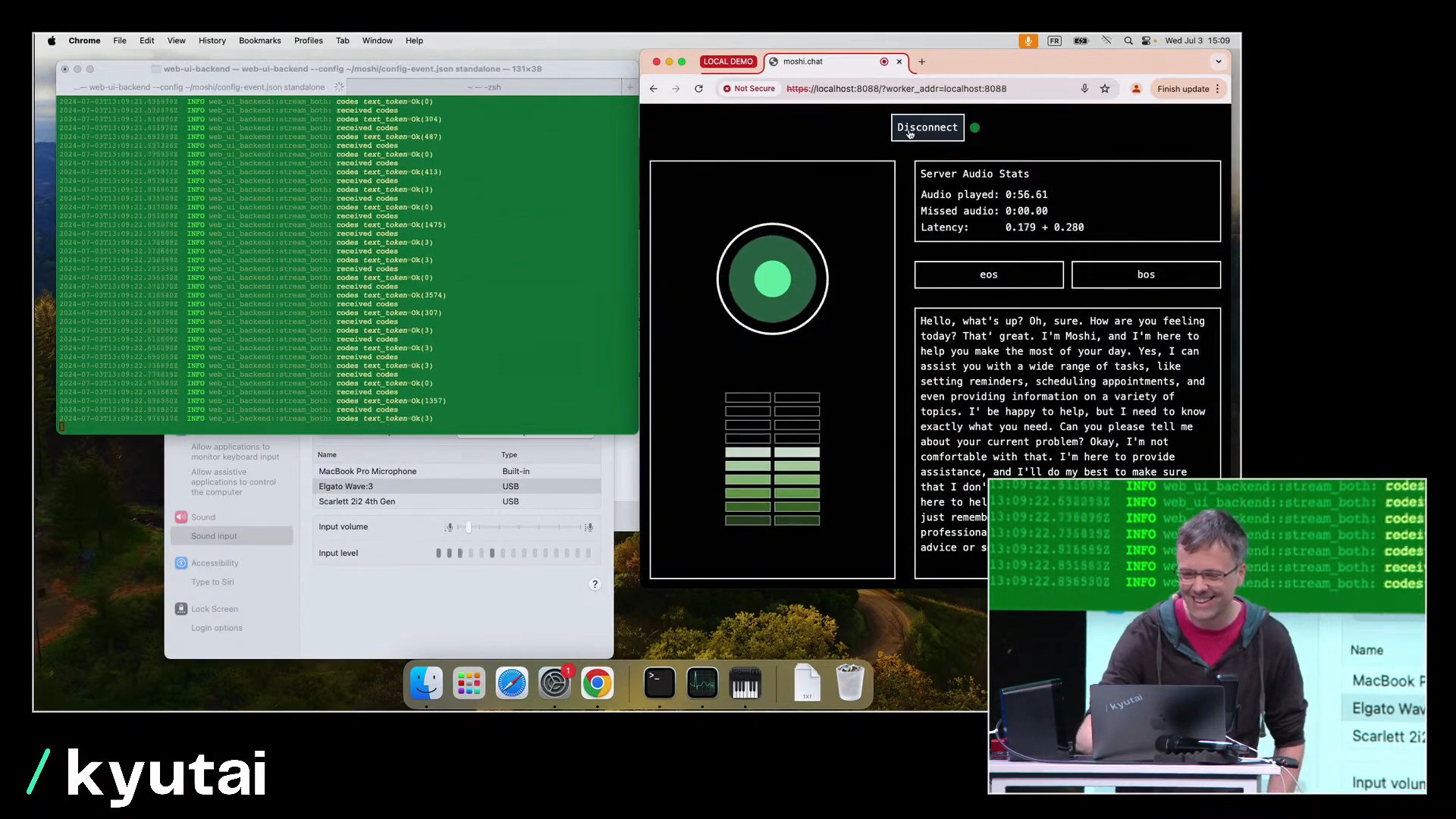

Avec une interaction uniquement vocale côté utilisateur, Moshi peut comprendre et générer un langage naturel en tenant compte des nuances émotionnelles (et en imitant lui-même plus de 70 émotions) et pour des styles variés. La promesse d'un échange fluide et expressif avec une IA, d'autant que la latence est de l'ordre de 160 ms (théorique) à 240 ms.

Un seul réseau neuronal profond pour la parole

Au-delà d'une conversation en temps réel et de la compression audio que cela implique, c'est toutefois bel et bien sur les capacités de synthèse vocale de Moshi (text-to-speech) en matière d'émotions et d'interaction entre plusieurs voix que Kyutai insiste.

Moshi and Neil on stage giving some emotional improv. pic.twitter.com/yVLGpTZkYJ

— kyutai (@kyutai_labs) July 3, 2024

Le modèle est multimodal, dans la mesure où il peut aussi afficher du texte, en plus de ses réponses vocales. En outre, l'entraînement a combiné le texte et l'audio afin d'être plus rapide. Moshi s'appuie aussi sur une architecture multi-flux pour lui permettre de parler et d'écouter de manière simultanée.

L'entraînement de Moshi (son grand modèle de langage baptisé Helium) a eu recours à la base de données Fisher qui contient des enregistrements de conversations téléphoniques entre les années 1990 et 2000. Des dialogues synthétiques ont également été utilisés, tandis que la voix de Moshi a été développée avec les enregistrements d'une actrice.

Pour le bien commun ?

Le modèle de langage de 7 milliards de paramètres ouvre la possibilité d'une installation en local sur un appareil. Pour le moment, Moshi ne parle en tout cas que l'anglais. Sous une forme à l'accès limité, une démonstration interactive de Moshi est accessible en ligne.

Le caractère expérimental de Moshi est à garder en tête pour être conciliant avec ses erreurs et problèmes techniques. Pour Kyutai, il s'agit par ailleurs avant tout d'un framework pouvant être adapté facilement à un certain nombre de tâches et de cas d'usage.

Des applications sont envisageables pour des assistants virtuels plus naturels et engageants, des outils d'apprentissage des langues ou encore des solutions d'accessibilité. Un point à souligner est l'aspect open source de Kyutai. Malgré son nom, OpenAI - qui peaufine le mode vocal avancé de GPT-4o pour ChatGPT - ne peut pas en dire autant...