Samsung et Nvidia s'associent pour créer une "AI Megafactory" équipée de plus de 50 000 GPU. Ce projet majeur vise à intégrer l'intelligence artificielle au cœur de la production de semi-conducteurs du géant coréen, de la conception à la fabrication, et vient consolider une collaboration historique avec un volet stratégique sur les mémoires HBM4 et les jumeaux numériques.

La relation entre le géant coréen de l'électronique et le leader des puces graphiques n'est pas nouvelle ; elle s'étend sur plus de 25 ans, débutant lorsque les puces mémoire DRAM de Samsung équipaient les premières cartes graphiques de Nvidia.

Aujourd'hui, cette collaboration de longue date franchit un cap décisif avec l'annonce de la création d'une "AI Megafactory". Le projet est colossal : Samsung prévoit de déployer un parc de plus de 50 000 GPU Nvidia pour insuffler de l'IA à l'intégralité de sa chaîne de production.

Une usine dopée à l'intelligence artificielle

Plus qu'un centre de données, cette méga-usine vise à transformer radicalement les méthodes de fabrication. L'idée est d'intégrer les processus de production, souvent complexes et cloisonnés, au sein d'un réseau intelligent unique.

Dans ce système, l'IA analysera, prédira et optimisera en permanence les environnements de production en temps réel. Pour y parvenir, Samsung s'appuiera sur la plateforme Nvidia Omniverse afin de créer des jumeaux numériques de ses usines.

Ces répliques virtuelles permettront de simuler et d'affiner les lignes de production avant même leur mise en service physique, tout en assurant une maintenance prédictive pour éviter les pannes.

Plus qu'un client, un partenaire stratégique

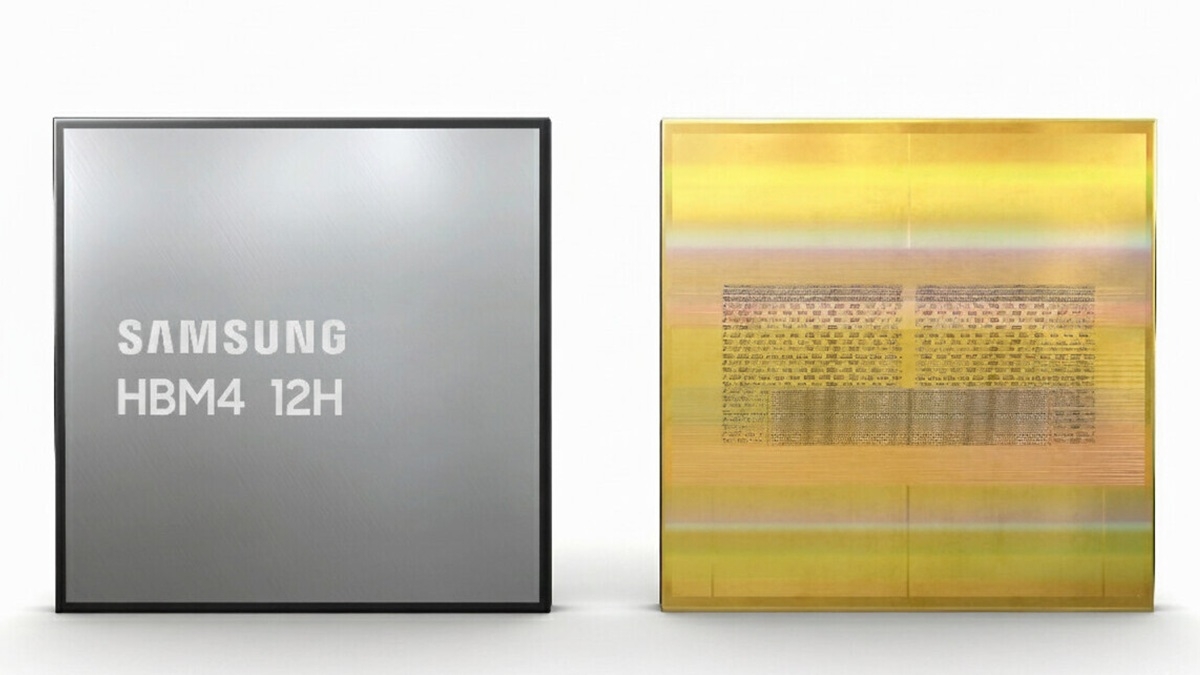

L'accord est à double sens et révèle la profondeur de l'alliance. Si Samsung est un client majeur pour les GPU Nvidia, l'entreprise est aussi un fournisseur essentiel. Le partenariat s'étend ainsi au développement conjoint des prochaines générations de mémoires haute performance, cruciales pour les accélérateurs d'IA.

Samsung a d'ailleurs confirmé être en discussion avancée pour fournir ses futures mémoires HBM4 à Nvidia. Ces puces promettent des débits dépassant les 11 Gbps, bien au-delà des standards actuels, et sont une pierre angulaire des futures architectures de calcul intensif. La collaboration inclut également des solutions comme les mémoires GDDR7 et les modules SOCAMM2.

La Corée du Sud, nouvel épicentre de l'IA ?

Cette initiative s'inscrit dans une stratégie bien plus vaste de la part de Nvidia pour faire de la Corée du Sud un pôle majeur de l'IA. Le concurrent direct de Samsung, SK hynix, a annoncé un projet similaire, lui aussi basé sur un déploiement massif de dizaines de milliers de GPU.

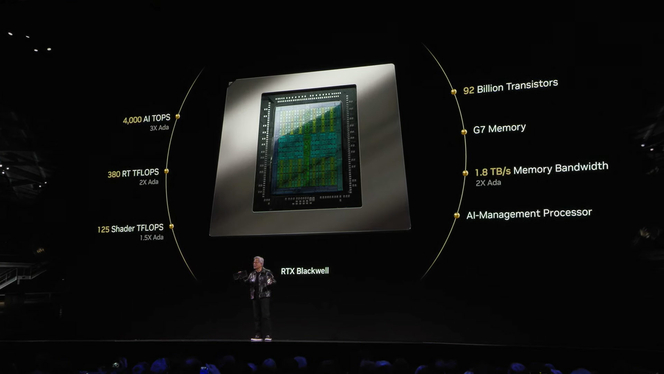

Au total, Nvidia prévoit de fournir près de 260 000 GPU de sa génération Blackwell au gouvernement coréen et à des entreprises locales comme Hyundai ou Naver Cloud.

Ce déploiement massif vise à quintupler la puissance de calcul IA du pays, en l'étendant au-delà des serveurs cloud pour toucher directement l'industrie, la robotique et les télécommunications avec le développement de l'AI-RAN.

Cette convergence entre l'IA logicielle et l'industrie physique pourrait bien dessiner les contours de la prochaine grande étape du secteur technologique.