La course à la performance dans le domaine de l'intelligence artificielle est, avant tout, une course à la mémoire. Chaque nouvelle génération de processeurs graphiques et d'accélérateurs IA exige des débits de données plus élevés et des capacités accrues pour traiter des modèles de langage toujours plus vastes.

Dans ce contexte, le sud-coréen SK hynix s'est imposé comme un acteur incontournable, et le CES 2026 de Las Vegas a servi de tribune pour présenter sa feuille de route.

L'entreprise y a organisé des rencontres ciblées avec ses clients clés pour solidifier ses collaborations futures et aligner sa production sur les besoins imminents du marché.

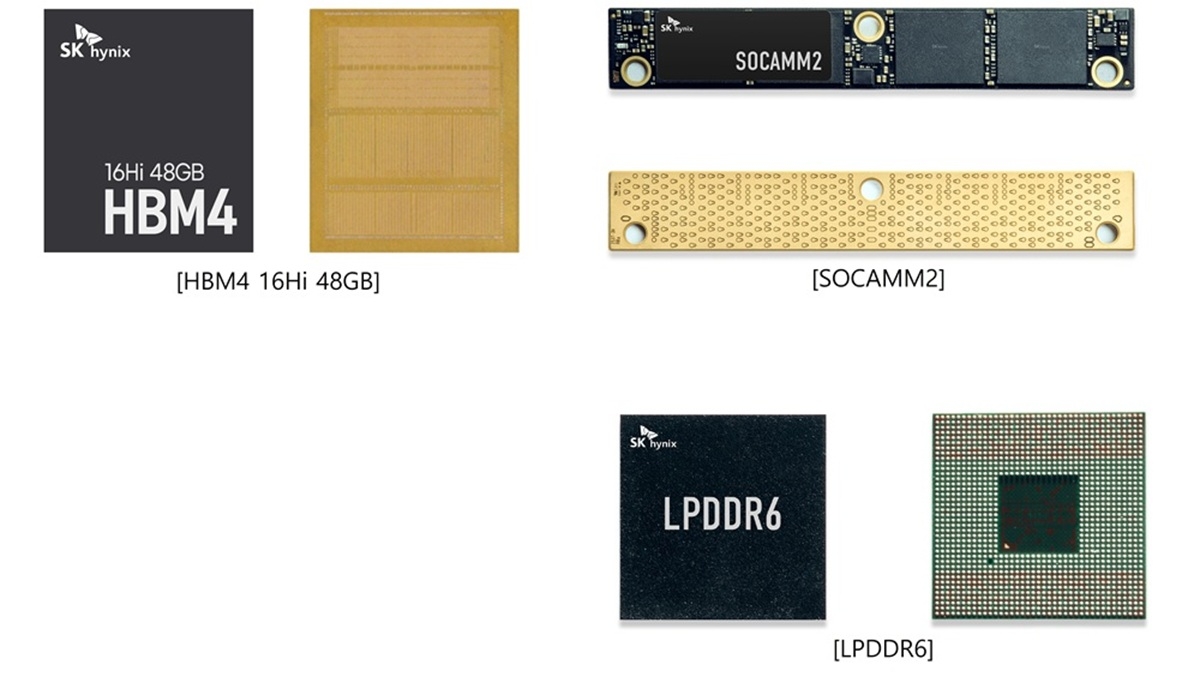

La HBM4, nouvelle reine de la performance

Le produit phare de cette démonstration était sans conteste la nouvelle puce HBM4, présentée dans une configuration inédite de 48 Go. Cette prouesse technique repose sur l'empilement de 16 couches de DRAM, une avancée majeure qui a nécessité de surmonter des défis complexes en matière de finesse de gravure, de déformation des wafers et de gestion thermique.

Cette puce succède à la version 12 couches de 36 Go et affiche une vitesse record de 11,7 Gbps, promettant une bande passante de plus de 2 To/s par empilement.

Parallèlement à cette innovation, SK hynix a également mis en avant sa mémoire HBM3E de 36 Go, qui devrait constituer le standard du marché cette année. Pour illustrer son intégration concrète, l'entreprise a exposé un module GPU pour serveurs IA, conçu avec un partenaire, montrant la mémoire en action dans un environnement système réel.

Un écosystème mémoire complet pour l'IA

L'arsenal de SK hynix ne s'arrête cependant pas à la mémoire à haute bande passante, très demandée pour répondre aux exigences des derniers modèles d'IA.

L'entreprise a dévoilé une gamme de produits diversifiée, conçue pour répondre à tous les segments du marché de l'IA. Parmi eux, la LPDDR6 se destine à l'« On-Device AI », l'intelligence artificielle embarquée directement dans nos appareils du quotidien comme les smartphones.

Cette nouvelle génération offre une nette amélioration de la vitesse de traitement et de l'efficacité énergétique par rapport aux standards précédents. On devrait la retrouver dans les processeurs mobiles de prochaine génération au second semestre, chez Qualcomm comme chez MediaTek.

Pour les serveurs IA, SK hynix a présenté le module SOCAMM2, une solution mémoire à faible consommation d'énergie. En élargissant son portefeuille au-delà de la HBM, l'entreprise montre sa capacité à fournir un écosystème complet, capable de répondre à la demande croissante et variée des infrastructures d'intelligence artificielle.

Au-delà de la RAM, le stockage et les concepts du futur

La gestion des données massives générées par l'IA ne repose pas uniquement sur la mémoire vive. SK hynix l'a bien compris en présentant sa nouvelle mémoire flash NAND QLC de 321 couches et 2 Tb.

Optimisée pour les SSD d'entreprise (eSSD) à très haute capacité, cette technologie répond aux besoins de stockage des centres de données IA, où la densité de stockage et une faible consommation électrique sont des critères déterminants.

Cette mémoire IA de stockage offre des gains significatifs en performance et en efficacité par rapport aux générations QLC antérieures.

Enfin, SK hynix a ouvert une fenêtre sur l'avenir avec sa « AI System Demo Zone » sur son stand au salon CES 2026. Cet espace permet de visualiser des concepts avancés comme la cHBM (Custom HBM), une mémoire personnalisée intégrant des fonctions de calcul, ou encore le PIM (Processing-In-Memory), qui vise à réduire les goulots d'étranglement en rapprochant le calcul des données.

Ces innovations suggèrent une tendance de fond : une intégration toujours plus poussée entre la mémoire et le traitement, qui pourrait bien redéfinir l'architecture des systèmes de demain, notamment en lien avec les futures plateformes comme Rubin de NVIDIA.