Après avoir connu des retards qui ont pesé sur ses résultats, Samsung Electronics change de dynamique. Longtemps devancé par son concurrent direct SK Hynix dans la fourniture de mémoire à haute bande passante (HBM) pour les processeurs d'IA, le conglomérat semble déterminé à reprendre la tête de la course.

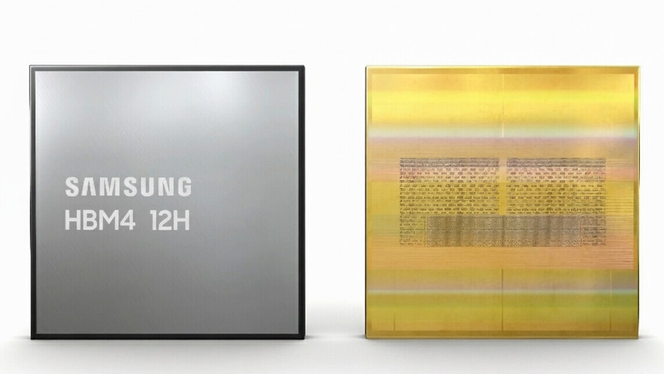

La validation récente de ses puces de nouvelle génération HBM4 par des clients majeurs marque un tournant potentiellement décisif et cela prépare l'arrivée des prochaines générations d'accélérateurs IA, à commencer par Vera Rubin de Nvidia.

Une validation technique qui change la donne

Selon plusieurs sources concordantes de l'industrie, Samsung a récemment franchi avec succès les tests de qualification finaux pour sa mémoire HBM4 auprès de géants comme Nvidia et AMD.

Cette étape cruciale signifie que les commandes ne se limitent plus à de simples échantillons, mais concernent désormais la production de masse. Les livraisons pourraient même débuter dès le mois prochain, préparant le terrain pour une intégration rapide dans les futurs produits.

Techniquement, l'offre de Samsung se distinguerait nettement. La firme aurait atteint une vitesse de transfert de données de 11,7 Gb/s par broche, dépassant les exigences de ses clients qui étaient fixées autour de 10 Gb/s.

Cette performance serait le fruit de l'utilisation de DRAM de sixième génération (1c) et d'une puce logique gravée en 4 nm, une avancée de plusieurs générations sur la concurrence pour l'intégration du cœur de contrôle.

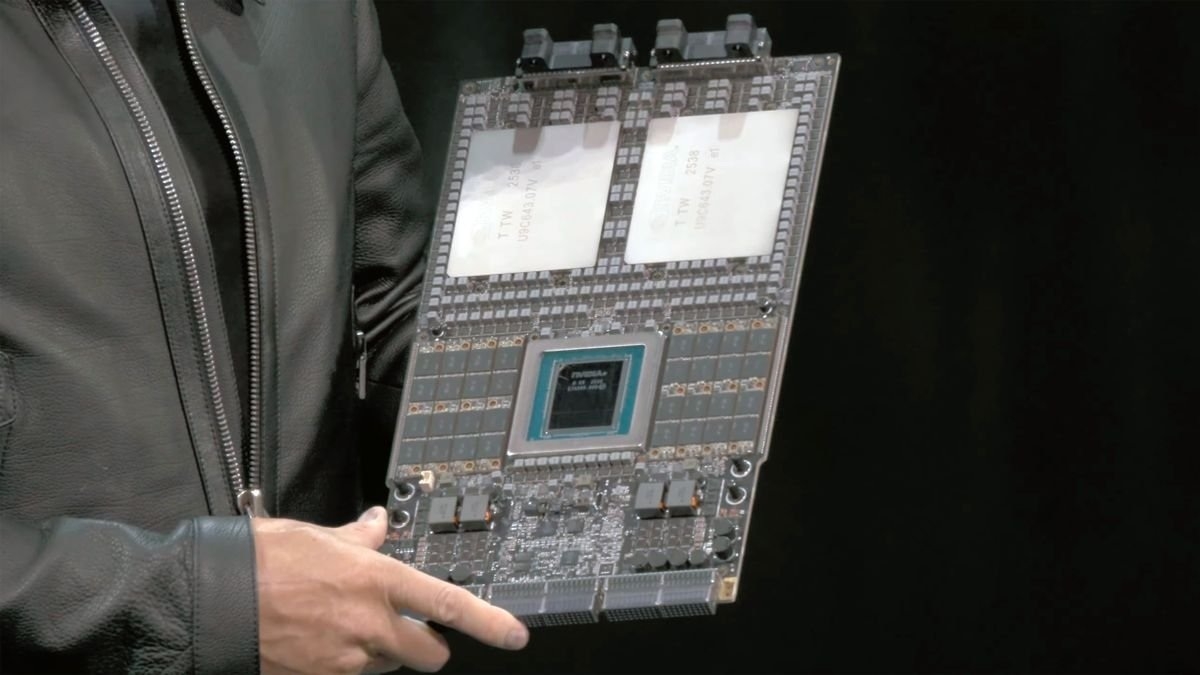

L'avantage stratégique de l'intégration verticale

Le véritable atout de Samsung réside dans sa capacité à produire en interne sa propre puce logique. Contrairement à ses rivaux SK Hynix et Micron, qui dépendent de TSMC pour cet élément essentiel, Samsung maîtrise l'ensemble de la chaîne de production.

Cet avantage lui confère une plus grande flexibilité et des délais de livraison potentiellement plus courts, un critère essentiel pour des clients comme Nvidia.

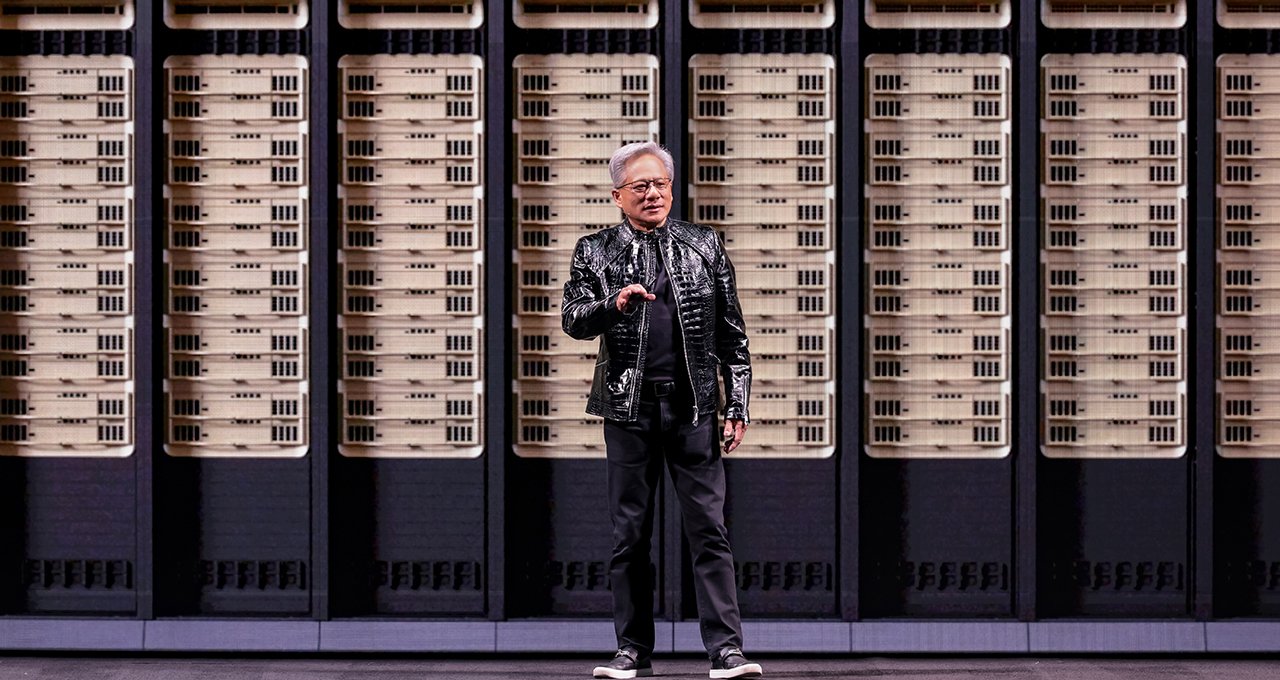

Nvidia Vera Rubin

Face à la mise en production à plein régime de la future plateforme d'IA Vera Rubin par le géant américain, la réactivité des fournisseurs est devenue un enjeu majeur.

En sécurisant son approvisionnement en puces logiques, Samsung se positionne comme un partenaire fiable et agile, capable de suivre le rythme effréné imposé par le leader du marché des accélérateurs d'IA.

Un calendrier serré pour une ambition retrouvée

Si les premières livraisons sont attendues très prochainement, le déploiement à grande échelle de la mémoire HBM4 devrait débuter aux alentours de juin.

Ces puces seront directement intégrées aux accélérateurs d'IA, comme la plateforme Rubin, qui devrait être officiellement présentée lors de la conférence GTC 2026 au mois de mars, temps habituel des annonces IA professionnelles et des grandes avancées de Nvidia. Le volume de production de Samsung s'ajustera donc en fonction du calendrier de fabrication final de ses clients.

Cette offensive sur la HBM4 est une manœuvre claire de Samsung pour non seulement rattraper son retard, mais aussi pour s'imposer comme le leader sur les futures générations.

L'entreprise mise sur ses capacités d'intégration complètes, de la conception des puces logiques à l'empaquetage final, pour développer des solutions personnalisées et renforcer sa position dominante pour les technologies à venir, comme la HBM4E.