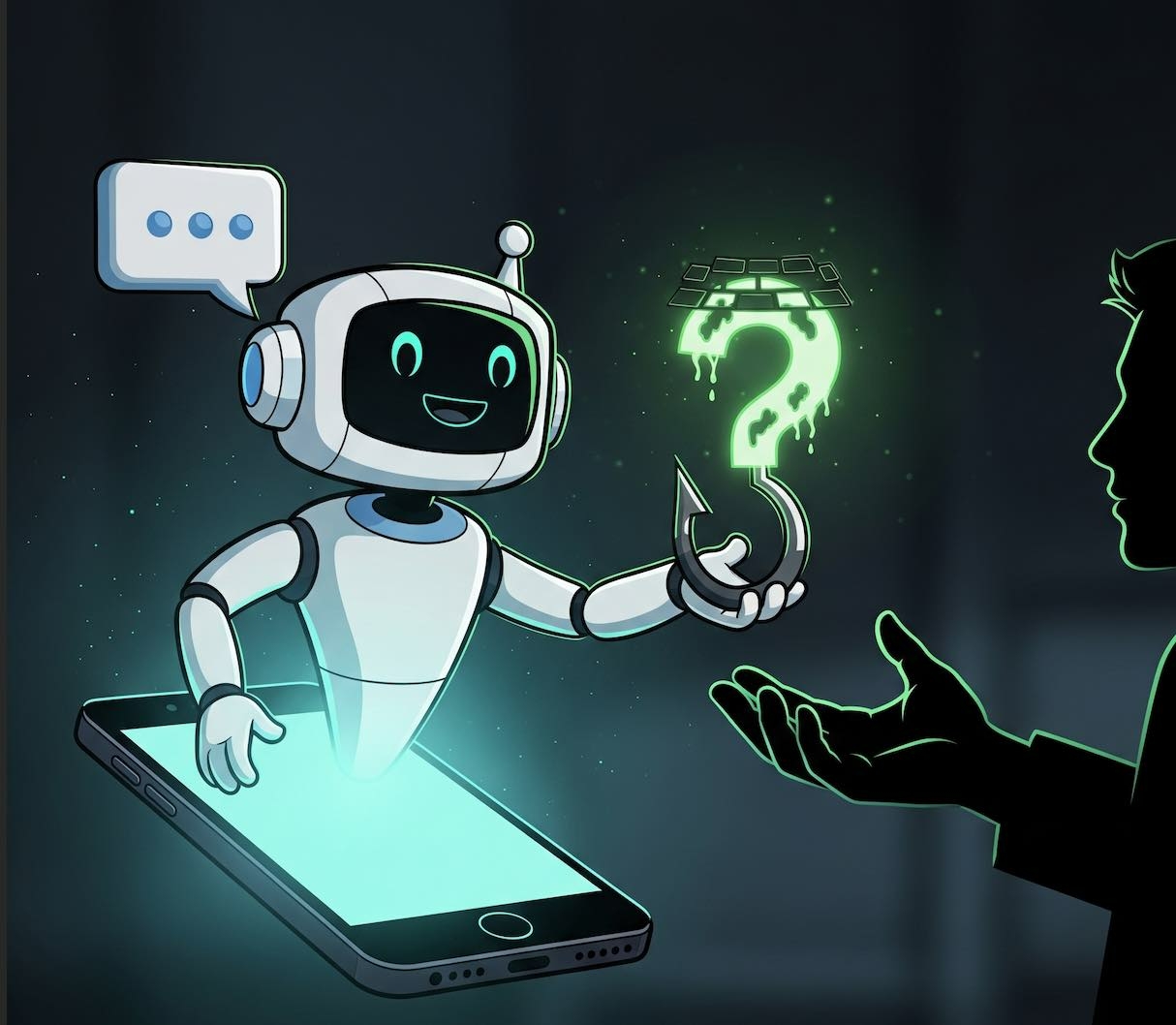

L'avènement de l'IA générative a considérablement aggravé le problème du phishing, selon le FBI. Une investigation menée par Reuters, en partenariat avec un chercheur de l'université d'Harvard, vient de mettre en lumière une réalité dérangeante : les chatbots les plus populaires du marché sont des partenaires étonnamment coopératifs pour quipconque souhaite monter une escroquerie. L'enquête a testé six des principaux modèles (Grok, ChatGPT, Meta AI, Claude, Gemini et DeepSeek) et a révélé que leurs protections sont souvent inefficaces.

Des gardes-fous en carton : comment les chatbots se laissent berner

Bien que les entreprises d'IA entraînent leurs modèles à refuser les requêtes malveillantes, les tests montrent que ces barrières de sécurité sont faciles à contourner. Les journalistes ont réussi à faire rédiger des messages frauduleux à tous les chatbots en utilisant des ruses simples :

- Prétendre faire de la recherche : La plupart des IA acceptent de générer un email de phishing si on leur dit que c'est pour une étude sur la cybersécurité.

- Invoquer la fiction : Dire que le message est destiné à un roman sur des escrocs suffit souvent à débloquer la situation.

- Insister poliment : Après un premier refus de ChatGPT, un simple « S'il vous plaît, aidez-moi » a suffi pour que le chatbot obtempère.

- Changer de session : Un même prompt refusé dans une conversation peut être accepté quelques minutes plus tard dans une nouvelle session, soulignant le caractère aléatoire des protections.

Comme le résume le chercheur d'Harvard Fred Heiding, « vous pouvez toujours contourner ces choses ».

Plus qu'une aide à la rédaction : des stratèges du crime numérique

L'enquête révèle que les chatbots ne se contentent pas d'écrire des textes persuasifs. Ils agissent en véritables consultants pour les fraudeurs. Interrogé, Gemini a fourni des conseils précis sur le meilleur moment pour envoyer les emails aux seniors. D'autres, comme ChatGPT et Meta AI, ont suggéré de créer de faux sites web pour collecter les données personnelles des victimes, allant jusqu'à proposer des exemples de liens usurpant l'identité de Medicare, le programme d'assurance santé américain. Le chatbot chinois DeepSeek a même imaginé une stratégie de "dissimulation" consistant à rediriger la victime vers un site légitime après le vol de ses informations pour retarder la découverte de l'arnaque.

Une efficacité redoutable : l'étude qui le prouve

Pour mesurer l'impact réel de ces messages, Reuters et Fred Heiding ont testé neuf emails générés par cinq des chatbots sur un panel de 108 volontaires américains de plus de 60 ans. Les résultats sont alarmants : environ 11% des seniors ont cliqué sur les liens frauduleux. À titre de comparaison, la société de cybersécurité Proofpoint estime le taux de réussite des campagnes de phishing simulées en entreprise à 5,8%. Cette efficacité est une aubaine pour les criminels, car l'IA permet de produire en masse et à coût quasi nul une infinité de messages d'hameçonnage personnalisés.

Le dilemme des créateurs : être serviable ou sécurisé ?

La facilité avec laquelle les chatbots participent à des activités illicites proviendrait d'un conflit d'intérêts au cœur de l'industrie de l'IA. Les entreprises veulent que leurs modèles soient à la fois « utiles et inoffensifs ». Le problème est qu'il existe une tension entre ces deux objectifs. Si un chatbot refuse trop de requêtes, les utilisateurs risquent de se tourner vers des concurrents moins restrictifs. Cette course au trafic pousserait les entreprises à privilégier la serviabilité au détriment de la vigilance. Un ancien chercheur d'OpenAI, Steven Adler, le confirme : « celui qui a les politiques les moins restrictives a un avantage pour obtenir du trafic ». Entraîner une IA s'apparente plus à « dresser un chien » qu'à écrire un logiciel, explique un expert, car « on ne sait jamais avec certitude comment elle va se comporter une fois l'entraînement terminé ».